Python中文指南:从零到一的零基础 Python 教程

Python中文指南:从零到一的零基础 Python 教程

版权归iswbm所有

第一章:安装运行

1.1 【环境】快速安装 Python 解释器

Python 是一门解释性脚本语言,因此要想让你编写的代码得以运行,需要先安装 CPython 解释器。

根据你电脑的系统以及位数不同,安装步骤也有所差异。

- Windows 系统:系统无自带 Python 解释器,需要自行安装

- Mac 系统:系统自带 Python 2.7,需要自行安装 Python 3

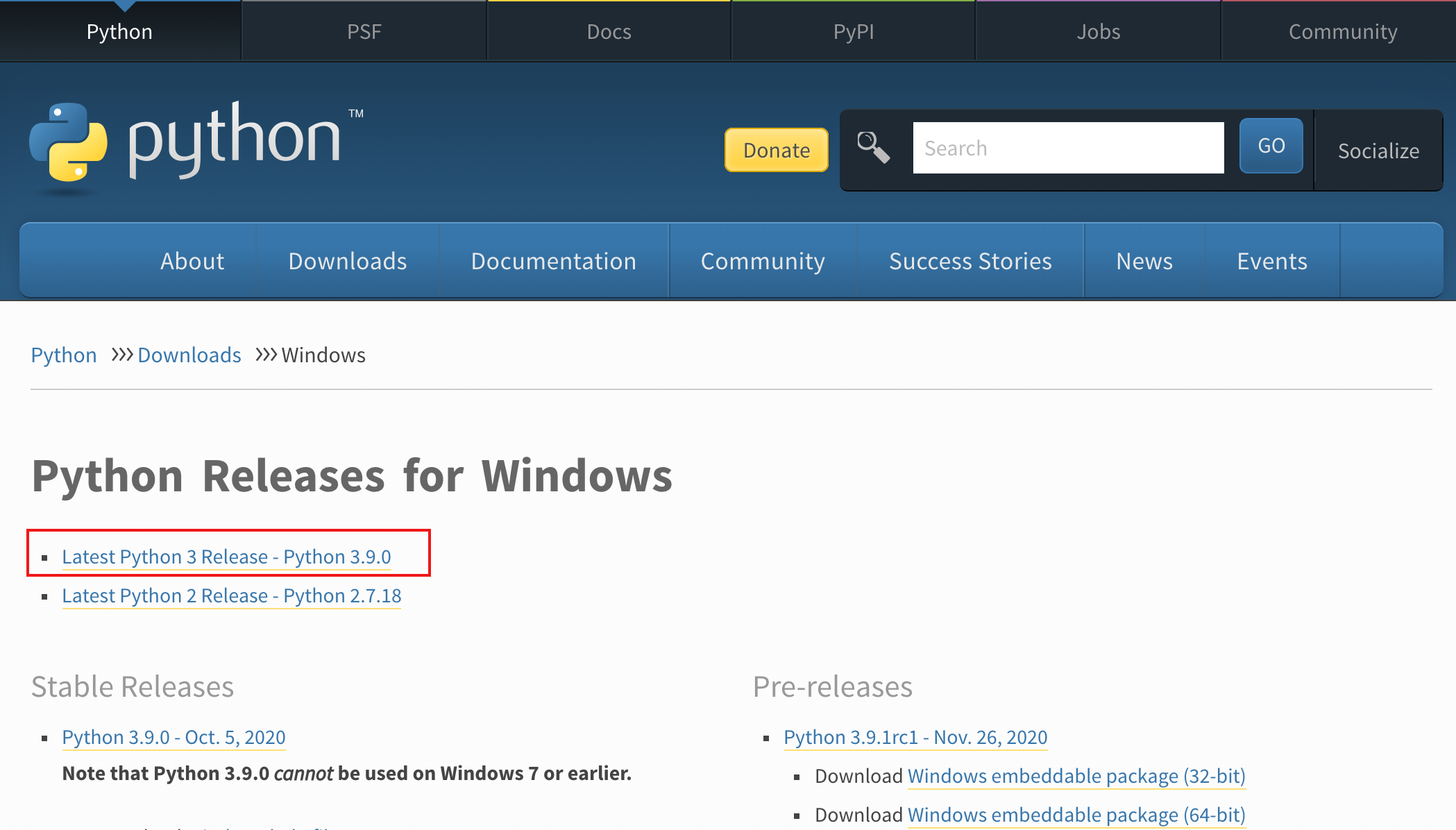

由于 Python 2.x 已经不再维护了,因此本文会带大家安装CPython 最新版本: Python 3.9 (截止撰稿时最新:2020/12/16)。

同时本系列教程都将以 Python 3.9 版本进行讲解,不负责任的讲,可能是全网最新的 零基础系列教程。

1. 下载解释器

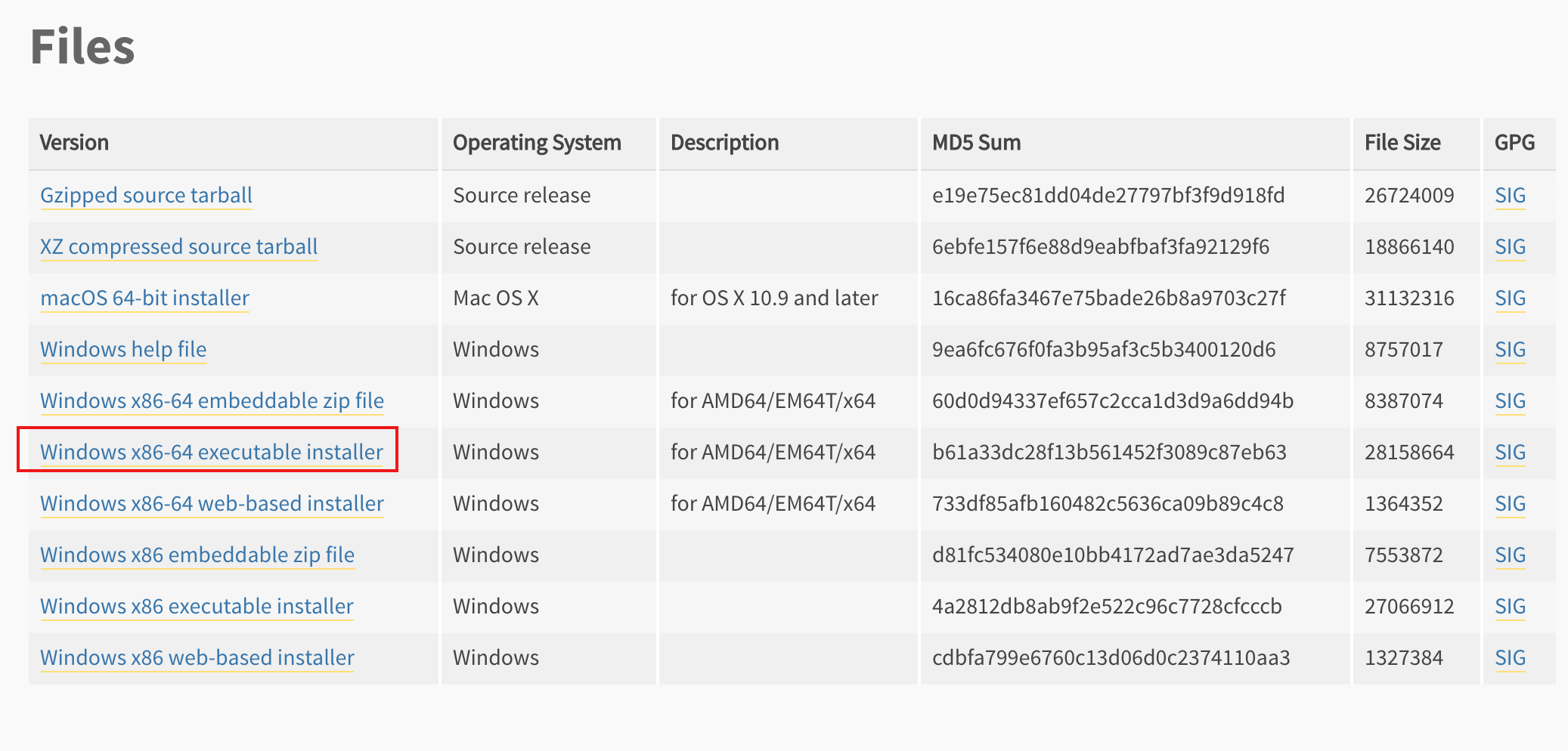

进入 Python 官网,目前 Python 最新 Python 稳定版为 3.9,点击如下链接

直接跳到最后,根据你电脑系统以及的位数

- Win 32 位:选择 Windows x86 executable installer

- Win 64 位:选择 Windows x86-64 executable installer

- Mac :Python-3.9.1-macosx10.9.pkg

下载下来后,根据你的电脑系统选择后面的内容进行阅读。

2. Win 安装

下载到本地后,双击打开开始安装

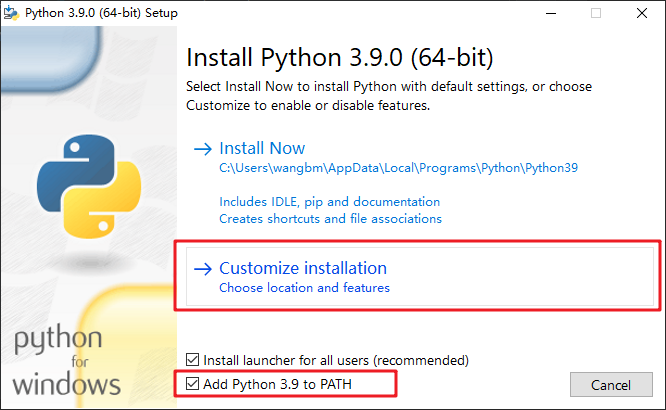

记得勾选 Add Python 3.9 to PATH,这是把你的 Python 路径加入到系统环境变量中。如果不想自定义选择安装路径,可以直接点击 Install Now,如果要选择安装路径,点击下图位置。

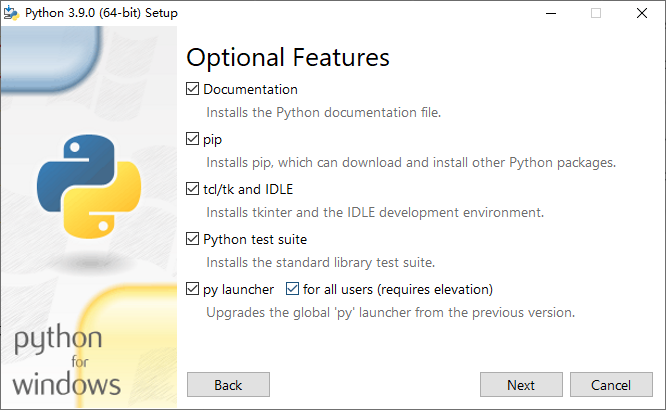

然后全部选上,然后点击 Next

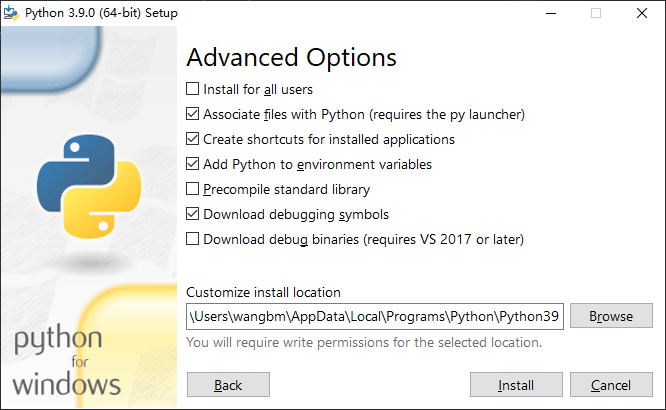

这里根据需要进行打勾,一般默认就行,然后点击 Browse ,选择你想要把 Python 安装到的哪那个目录里。

然后再直接点击 Install 开始安装。

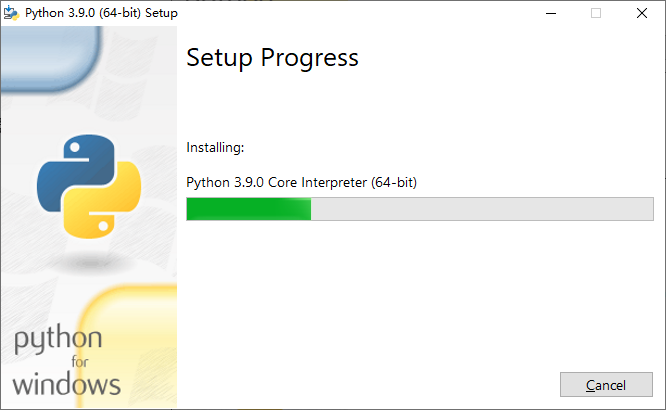

安装过程只要几分钟就行

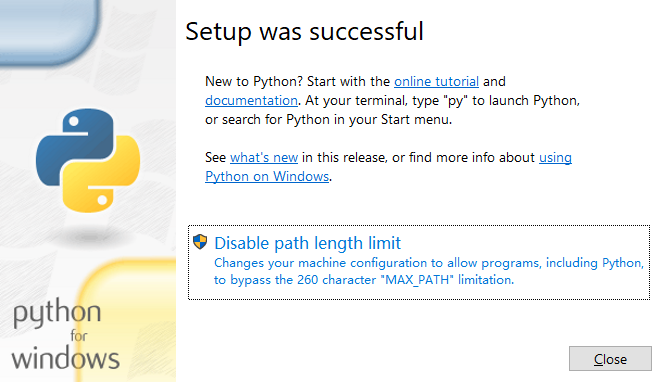

出现如下界面,说明安装过程已经结束。

安装是安装上了,那么如何验证呢?

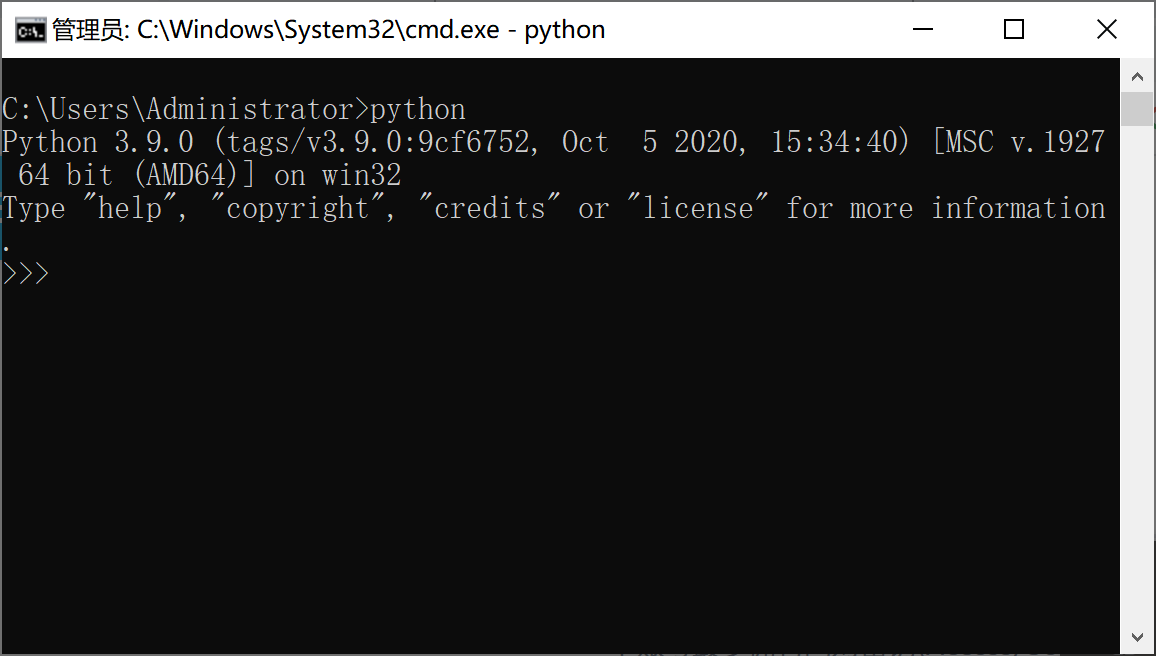

使用 windows 搜索 cmd,选择 命令提示符 (我们把这个称之为你的终端)

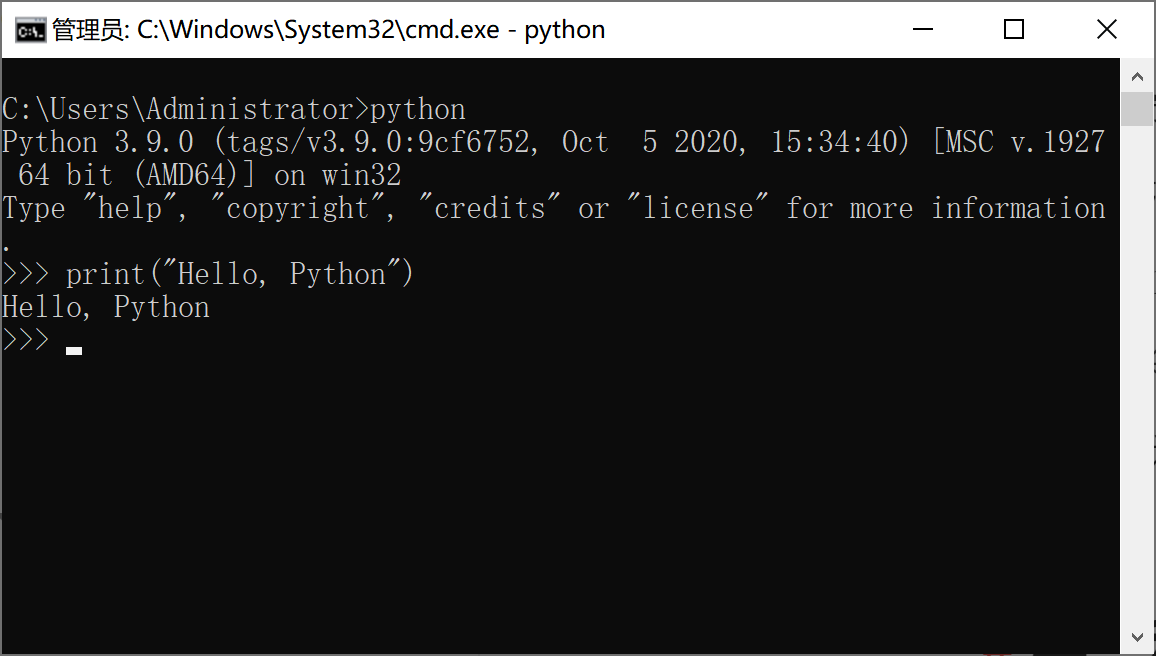

然后敲入 python ,若出现如下界面,则说明 Python 已经成功安装到你的机器上。

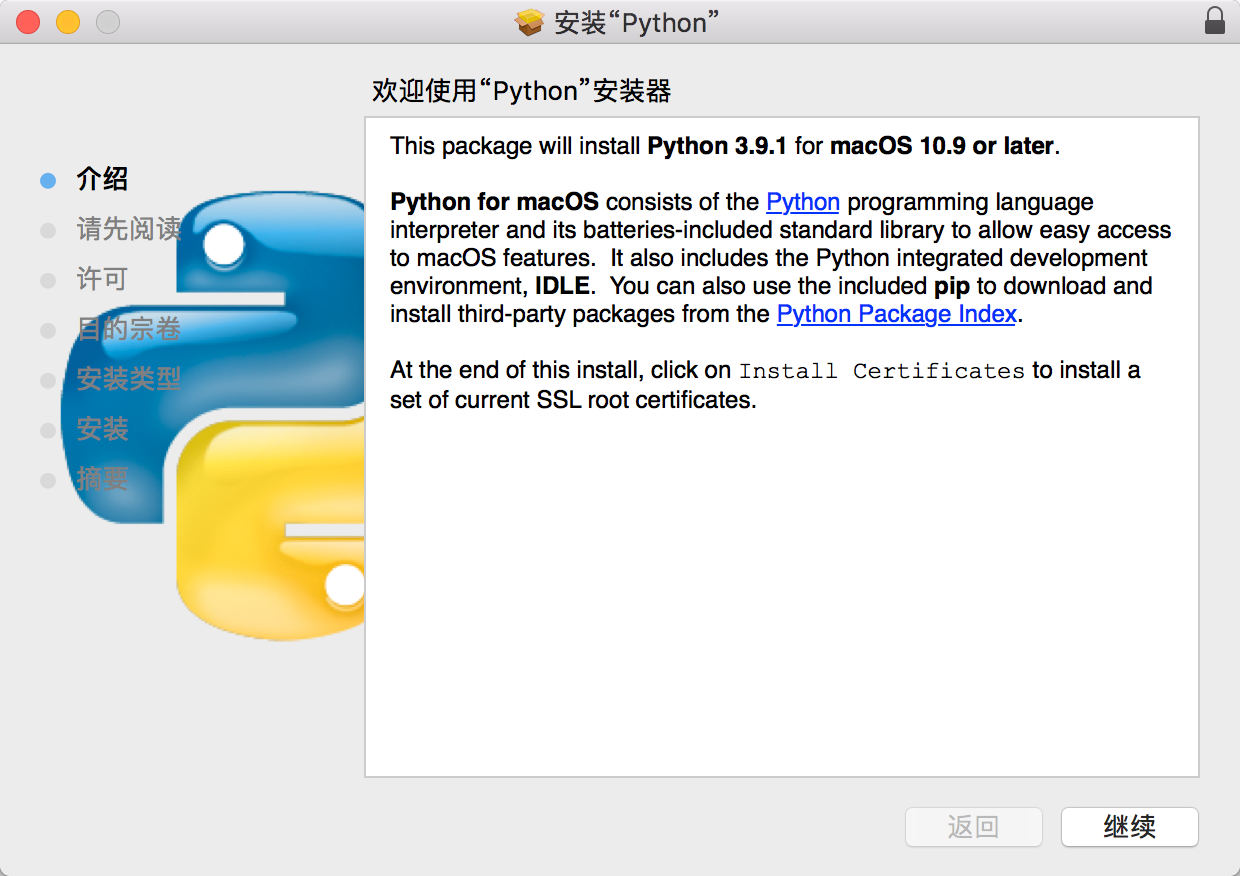

3. Mac 安装

下载到本地后,双击打开开始安装

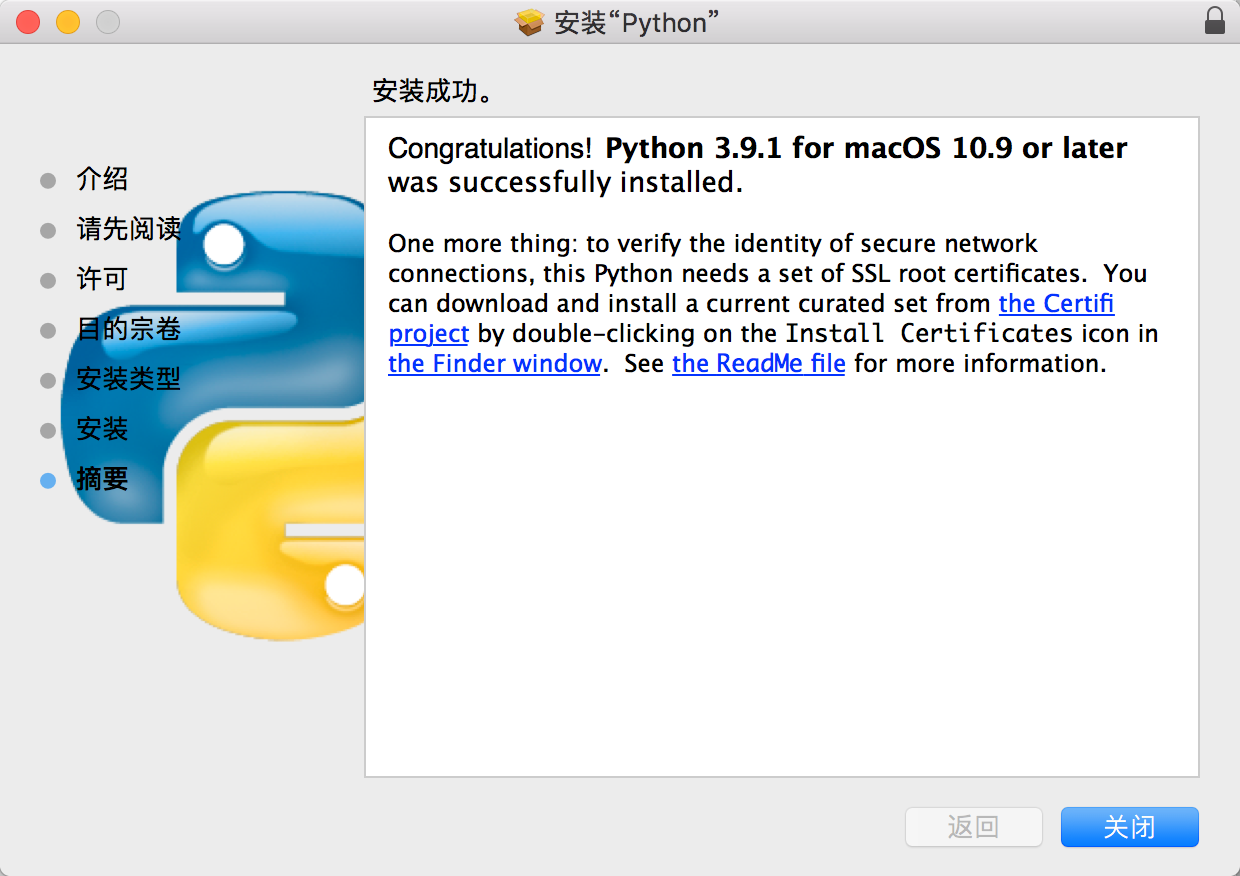

出现如下界面,一直点继续

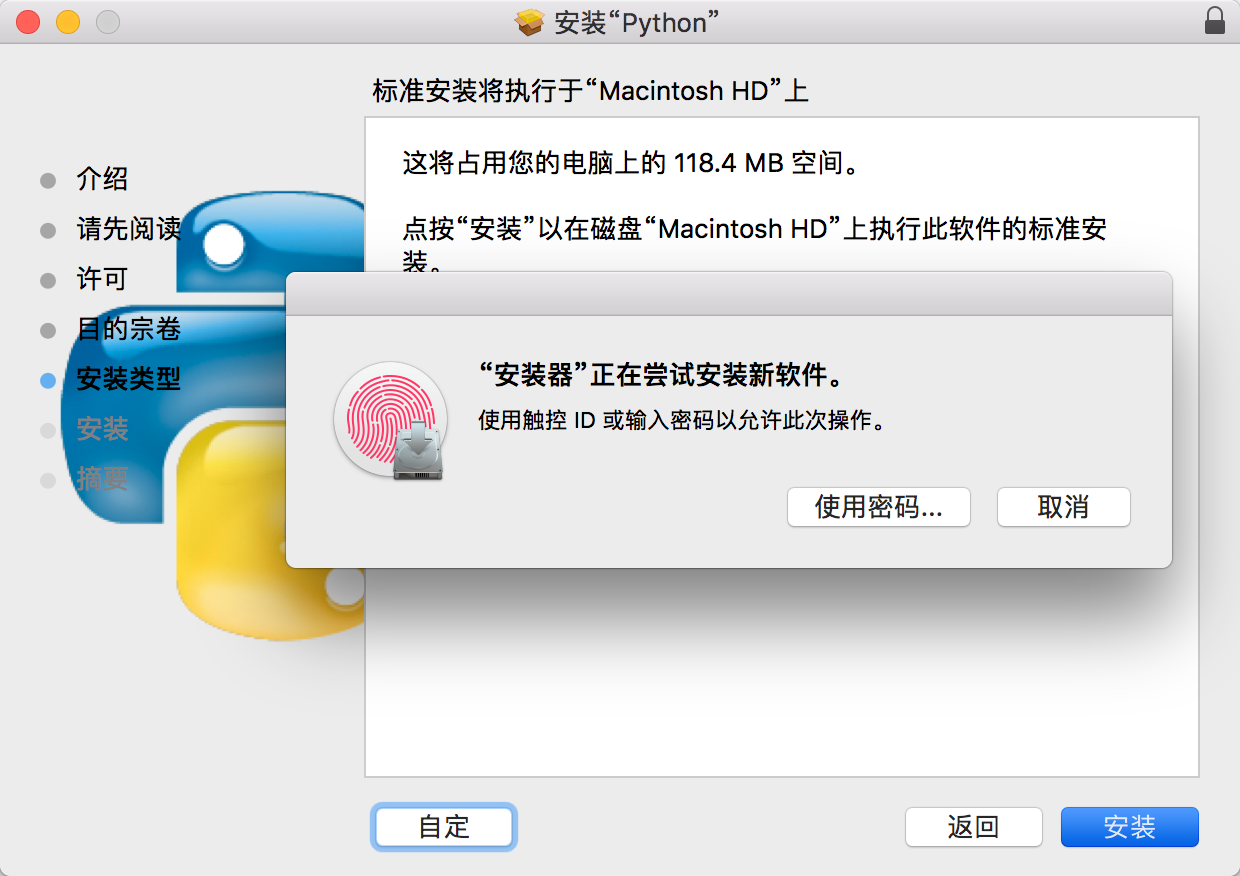

直到出现如下界面,输入密码开始安装

安装的速度非常地快,大概在一分钟左右

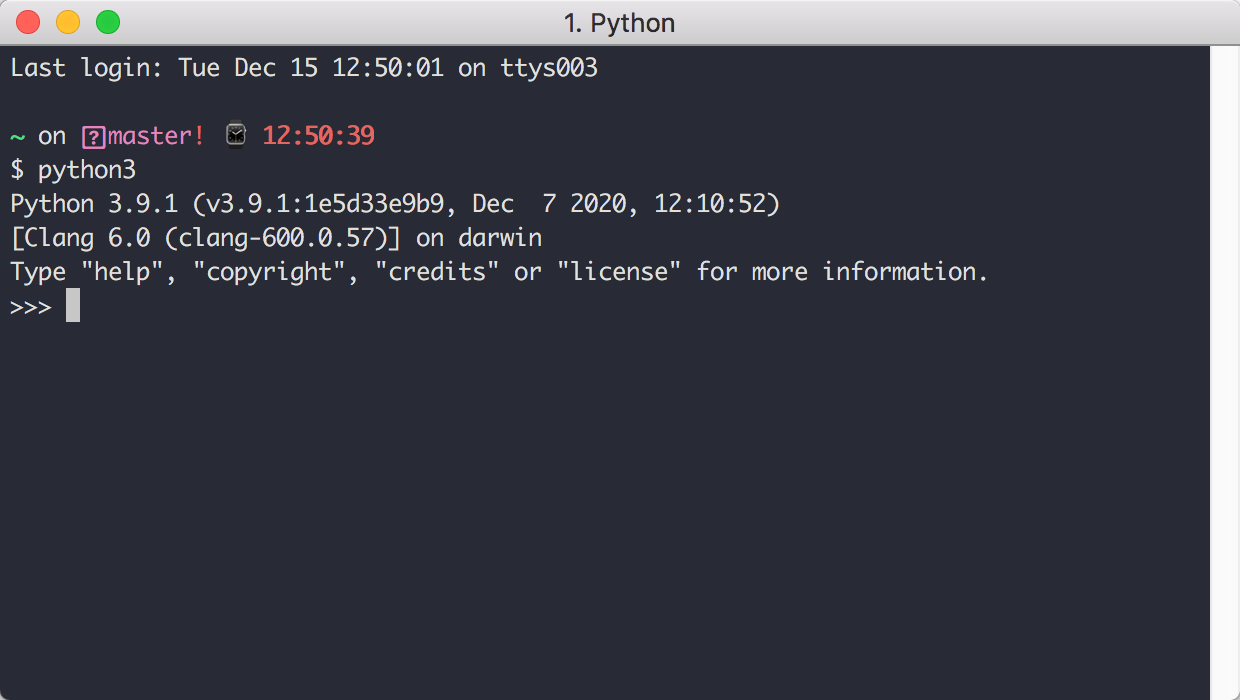

打开Terminal 或者 iTerm(同样我们把这个称之为你的终端),输入 Python 3 ,如果进入如下界面,说明 Python3 已经安装完成。

1.2 【环境】Python 开发环境的搭建

理论上只需要你安装了 CPython 解释器后,就可以开始写 Python 代码了。为了让你的在写代码时,有一个更加友好的编码体验。就有人开发了一堆的编辑器。

这些编辑器,具有代码高亮,代码提示自动补全的各种功能,如果没有这些编辑器,我想你没两天就会放弃编程这条路了。

因此在开始学习使用 Python 写代码时,首先要教大家搭建一个舒适的开发环境。

在这里我推荐大家使用 PyCharm 这个软件,它不只是一个简单编辑器,而是一个由 Jetbrain 公司为 Python 专门开发的 Python 语言集成开发环境。

也许你还不知道 Jetbrain ,我来简要介绍一下,Jetbrain 是一家专业的 IDE (Integrated Development Environment )生产商,只要是市面上主流的编程语言,Jetbrain 都有相应的产品。

比如:Python 对应 PyCharm ,Golang 对应 Goland,Java 对应 IntelliJ IDEA,C 语言对应 Clion 等等。

在这些众多的 IDE 中,有一些提供了多种版本:教育版、社区版 和 专业版。

PyCharm Edu is based on PyCharm Community Edition and comprises all its features, making it just perfectly suitable for writing professional projects with Python.

教育版:教育版是免费的,具备社区版的所有功能,除此之外,还提供有一个教学功能,因此它更适合学生。老师可以用它创建教学,学生可以通过他完成教学任务。

社区版:就是阉割版的专业版,它也是免费的,如果你并不需要使用专业版才有那些功能,可以选择社区版。

专业版:提供所有 PyCharm 的功能,虽然是收费的,但是可以试用一个月。

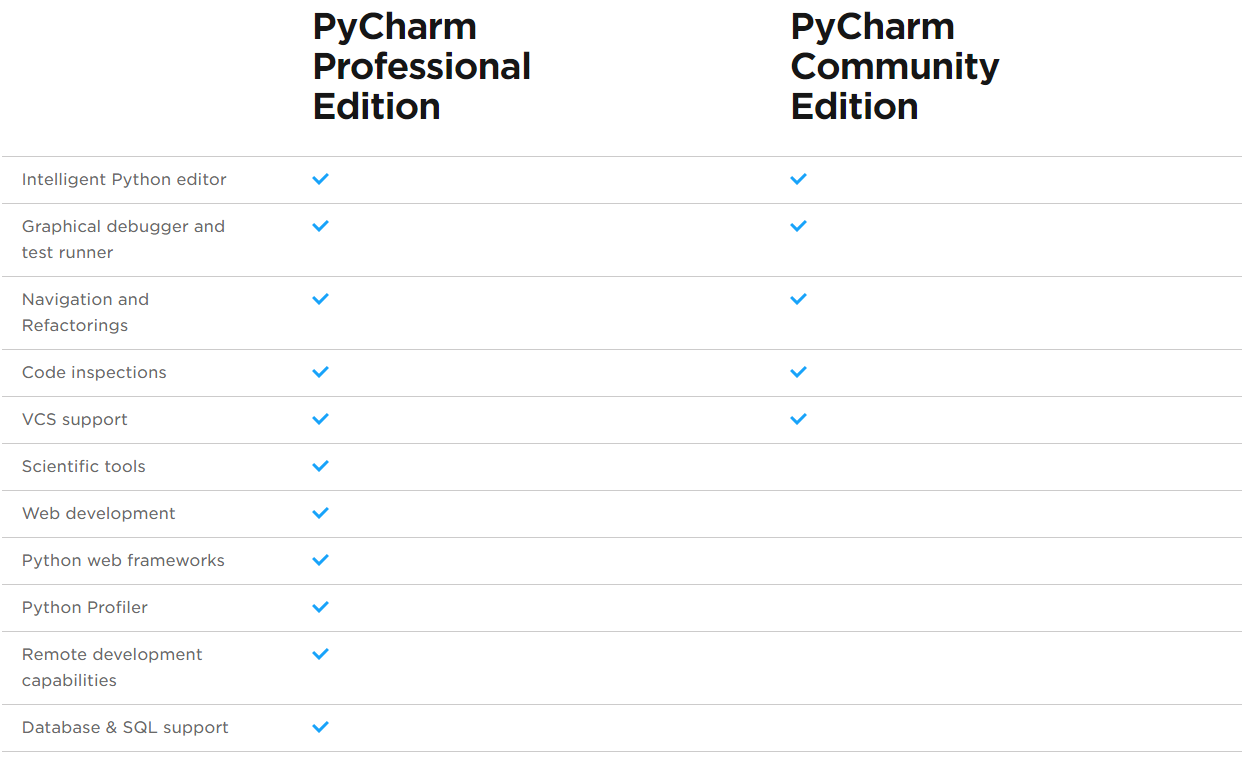

社区版和专业版在功能上有哪些区别呢?你可以看下面这个表格。

可以看出专业版比社区版多了 科学工具、WEB 开发、Python Web 框架、Python 代码分析、远程开发调试、数据库支持。

社区版的功能有限,有些非常好用的功能只有专业版才有,比如 远程调试。

如果你想使用到专业版,那有什么办法呢?

- 有钱的就是大爷,付费购买。

- 穷人自有穷活法,每次试用一个月,试用期到,卸载干净,再来一次。

- 利用学生与教师的特权,可申请免费使用

- 若你有开源项目,也可以申请免费使用

- 用一些

非寻常手段(也就是破解)来实现。

破解的方法,其实还分很多种:

- 可以使用注册服务器的方式,优点是非常方便,缺点是过一段时间就有可能失效,不稳定。

- 还可以使用破解补丁的方式,优点是永久破解(使用期限到 2099 或者 2100年,某种意义上算是永久了),缺点是对于最新版的 PyCharm 你可能找不到相应的破解补丁。如果要使用这种方法,就意味着你得使用旧版的 PyCharm 。

- 使用绿色免安装的 PyCharm 安装包,其实原理和第二种一样,这一种只是别人帮你破解好,你直接用而已。只适用于 Windows 。

那么这么多版本,该怎么选择呢?

一般来说:

- 如果你是学生,那么可以直接向 Jetbrain 免费申请专业版。

- 如果你是新手,直接安装社区版就行了,功能已经够用了。

- 如果你想使用更多好用的 专业版功能,那么花钱去购买吧。

如果你暂时付不起购买费用,可以加下面微信,我这有 绿色免安装的专业版,对,就是那种连安装都不用安装的 专业版。

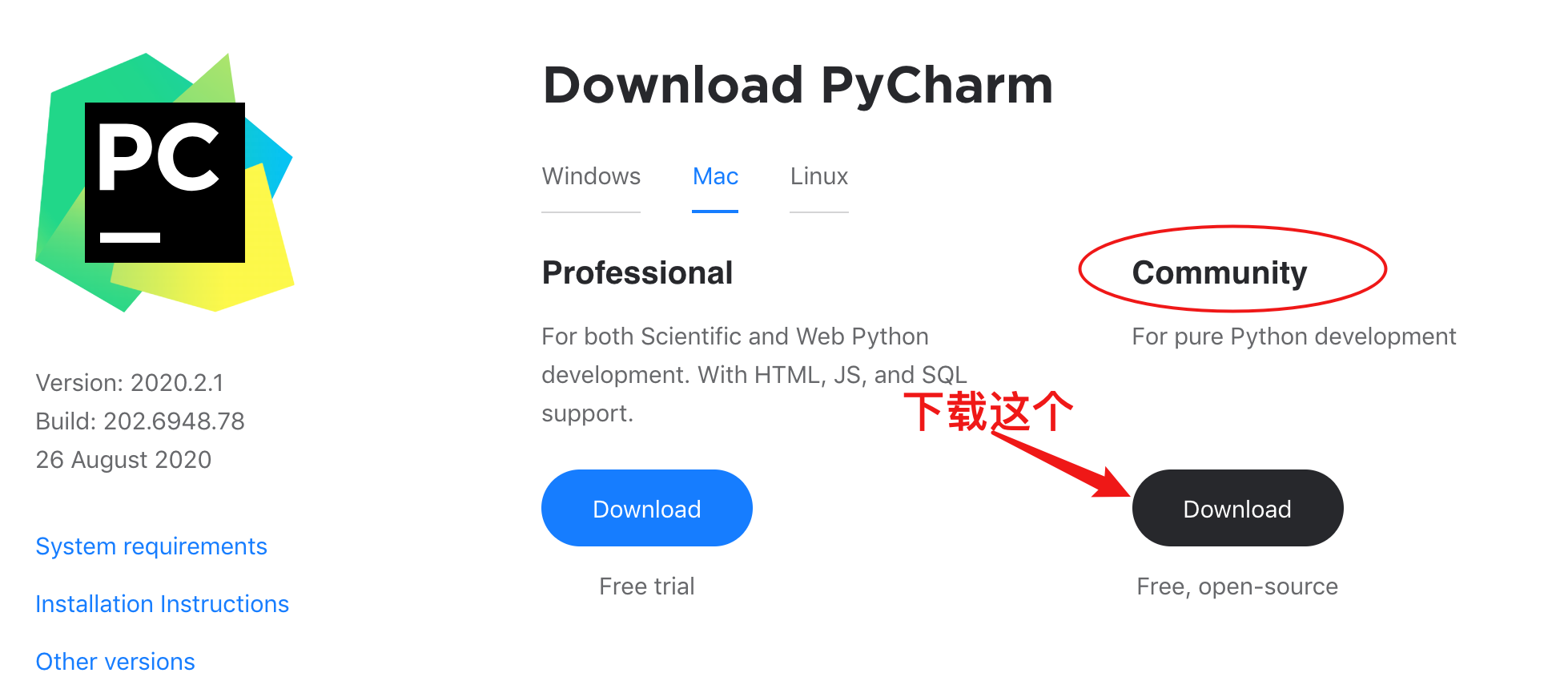

1. 下载链接

PyCharm for Windows :https://www.jetbrains.com/pycharm/download/#section=windows

PyCharm for Mac :https://www.jetbrains.com/pycharm/download/#section=mac

PyCharm for Linux :https://www.jetbrains.com/pycharm/download/#section=linux

2. 安装步骤

下载完成后,双击 exe 文件

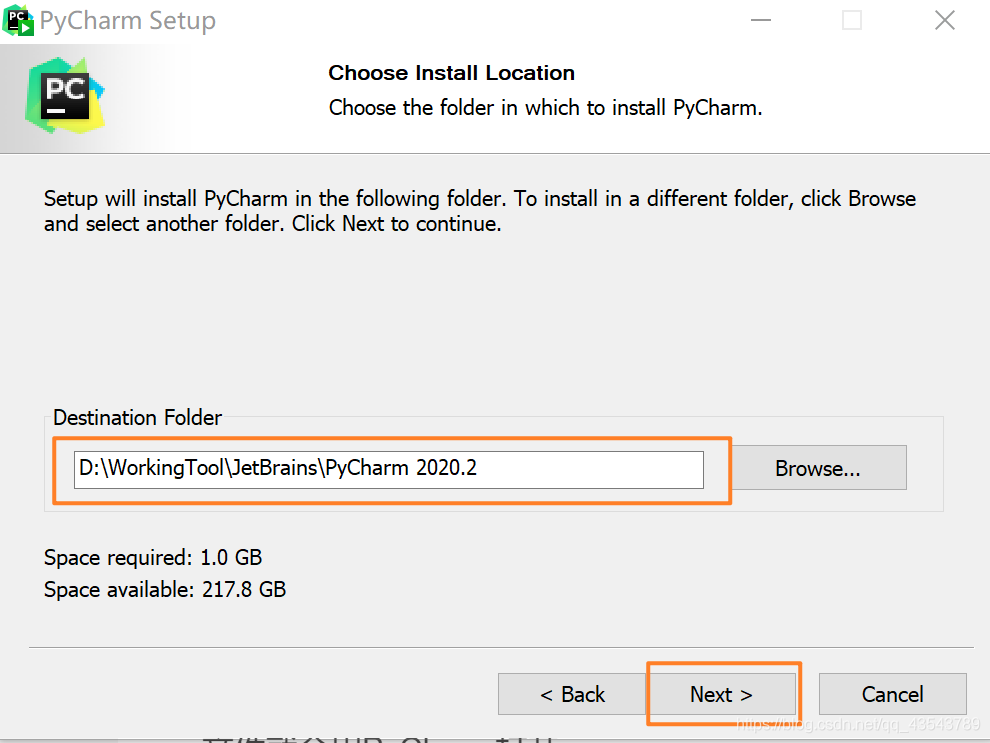

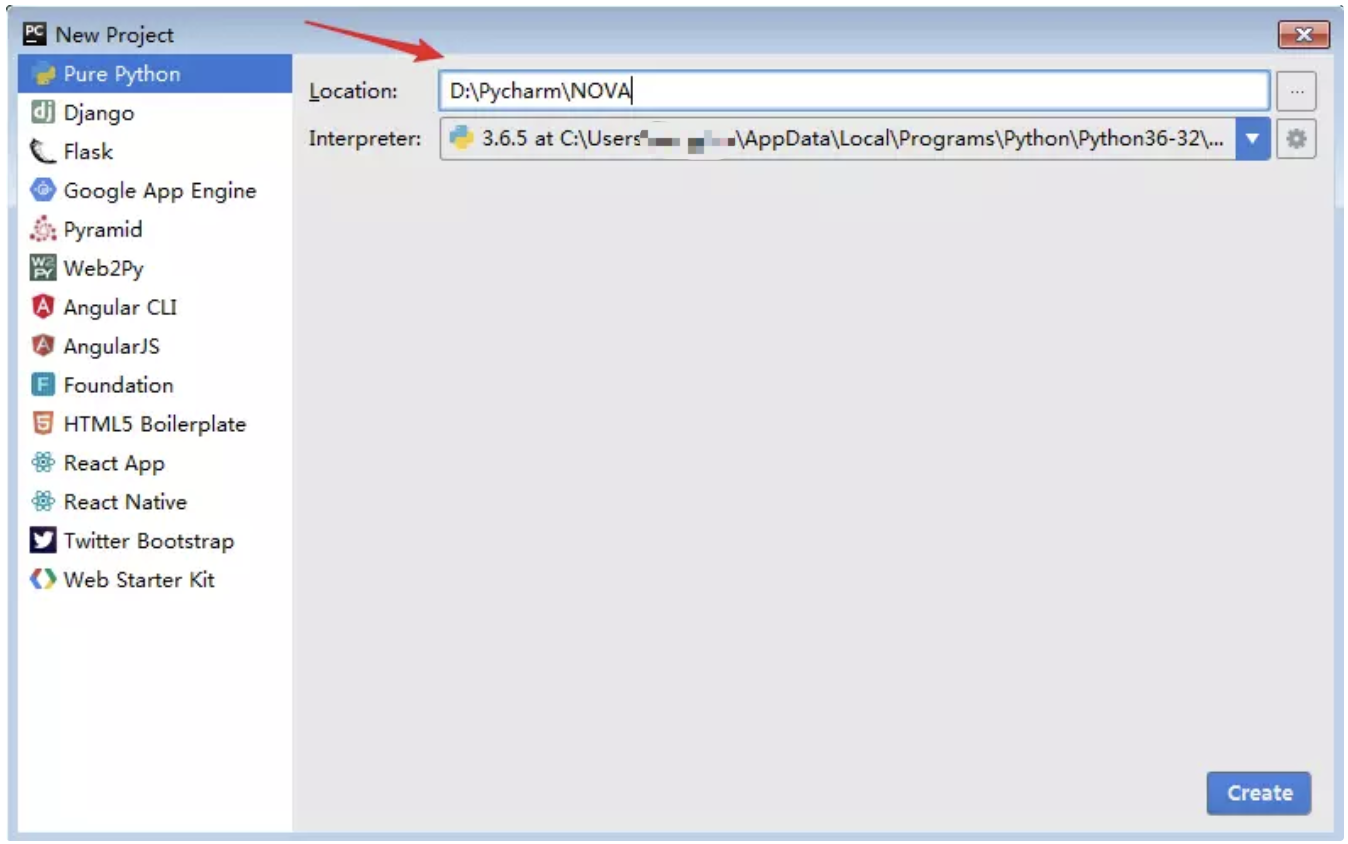

选择安装目录,Pycharm需要的内存较多,建议将其安装在D盘或者E盘,不建议放在系统盘C盘:

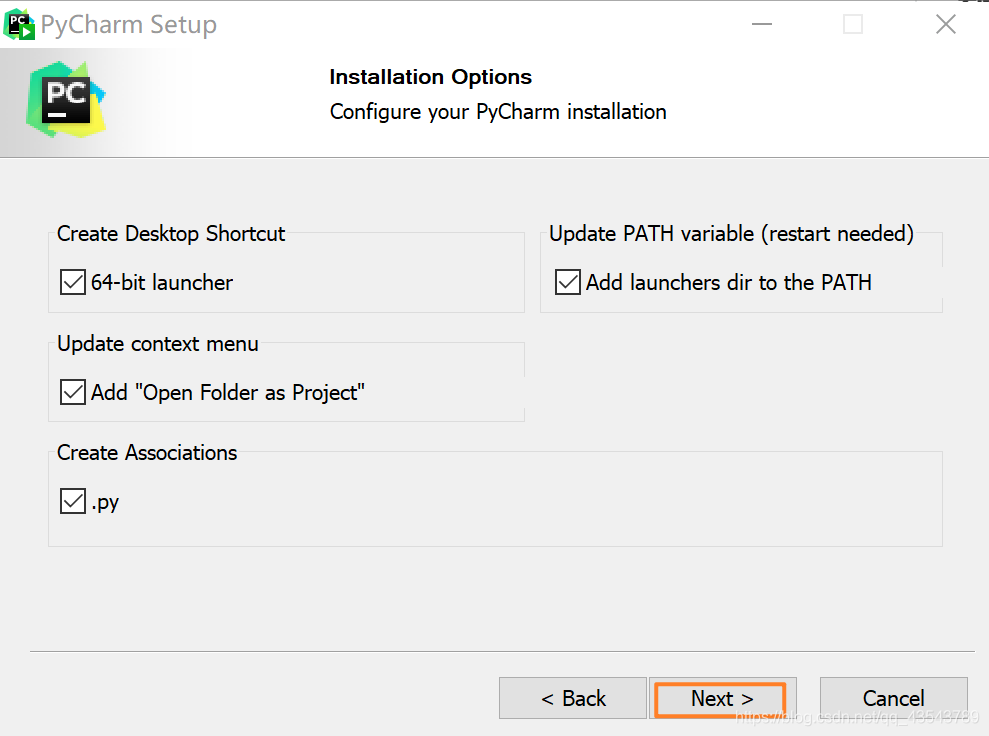

选好路径后,点击 Next ,创建桌面快捷方式等一系列选项参照下图勾选!

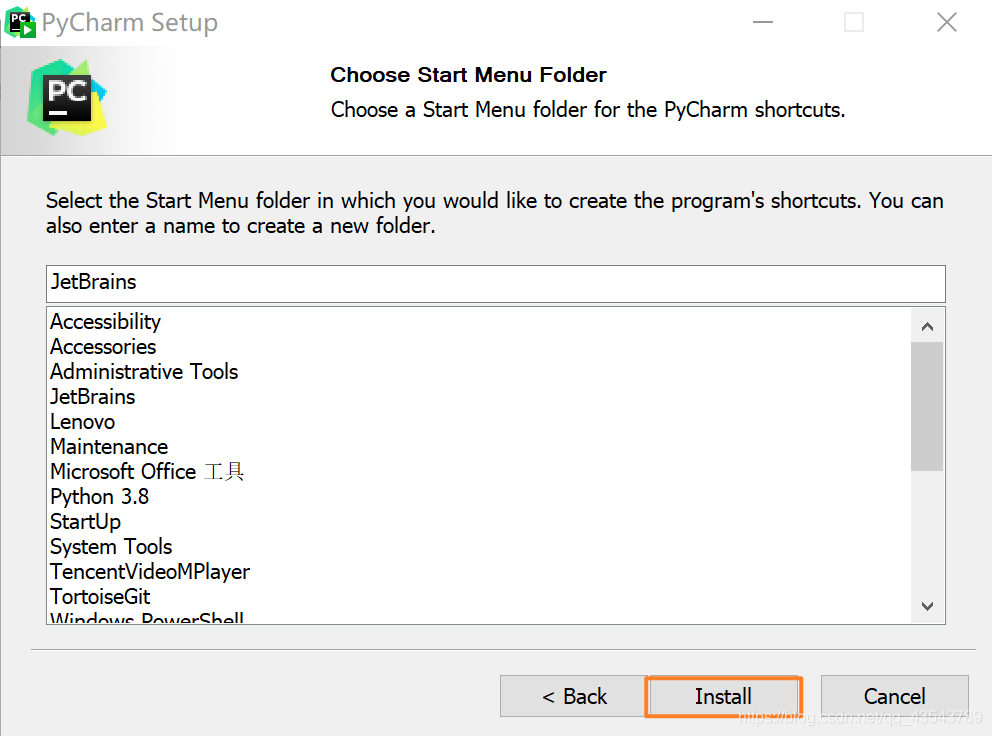

最后默认安装即可,直接点击Install。

7、耐心的等待两分钟左右。

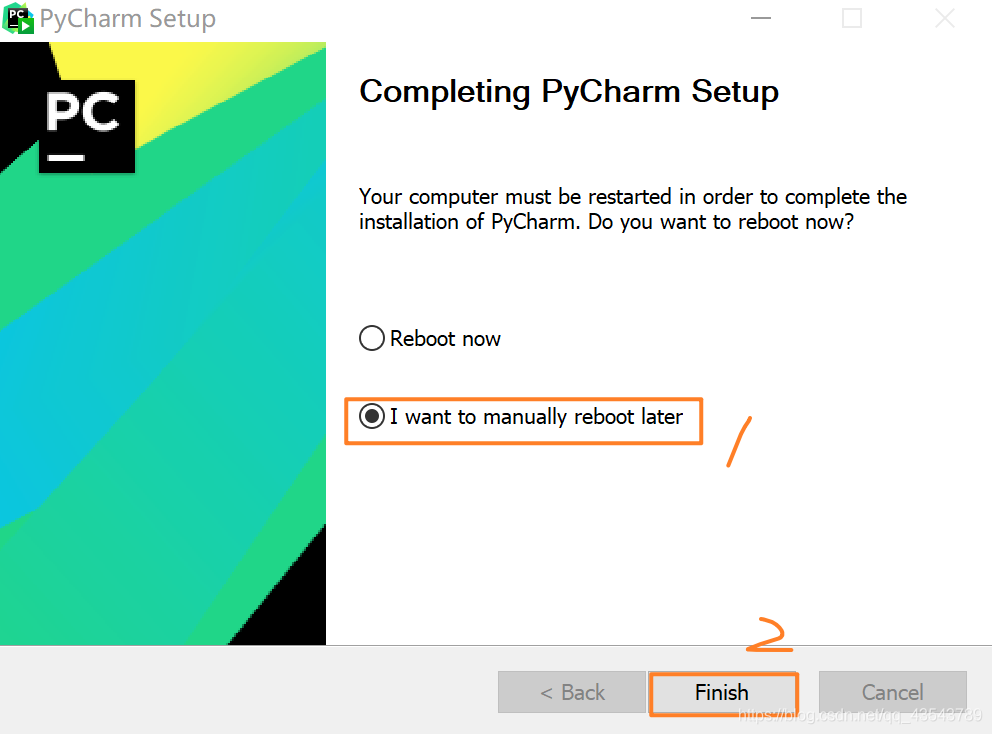

之后就会得到下面的安装完成的界面

点击Finish,Pycharm安装完成。

接下来对Pycharm进行配置,双击运行桌面上的Pycharm图标,进入下图界面:

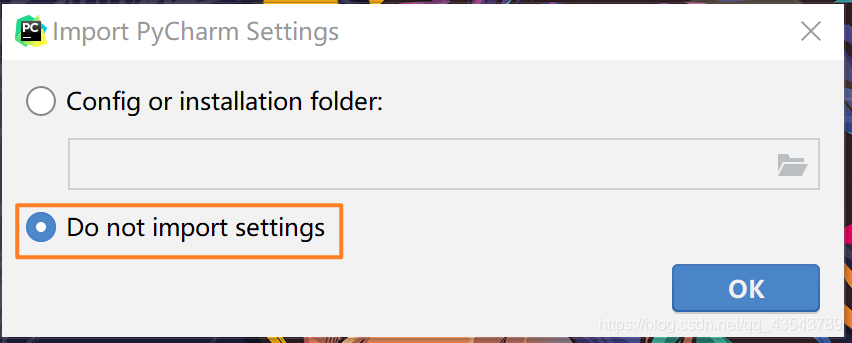

选择Do not import settings,之后选择OK,进入下一步。

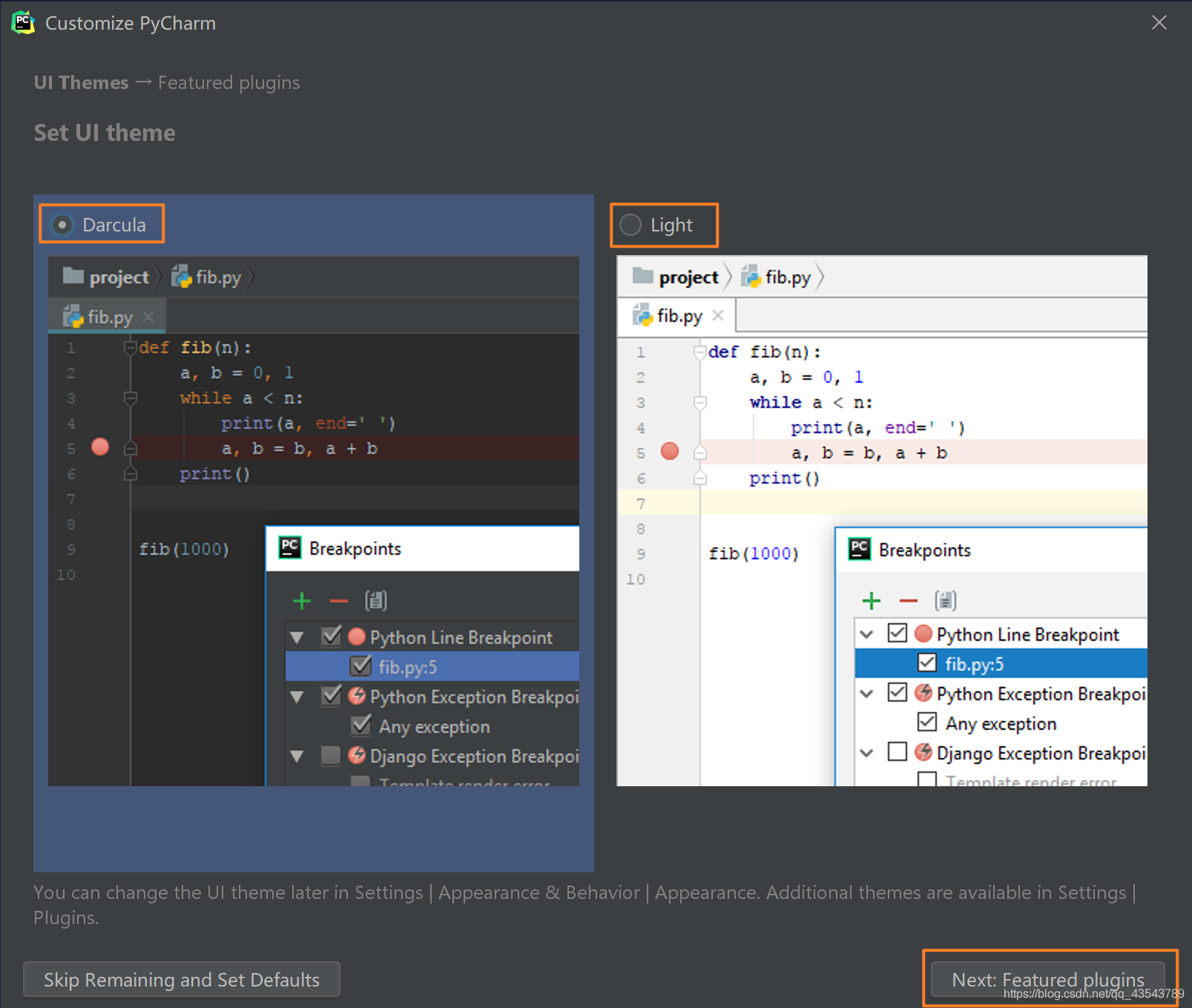

下面是选择主题

-> 这里默认选择黑色(左边黑色,右边白色)

-> 点击Next:Featured plugins

建议选择Darcula主题,该主题更有利于保护眼睛。

一切配置完成后,就会进入 PyCharm 的主界面。

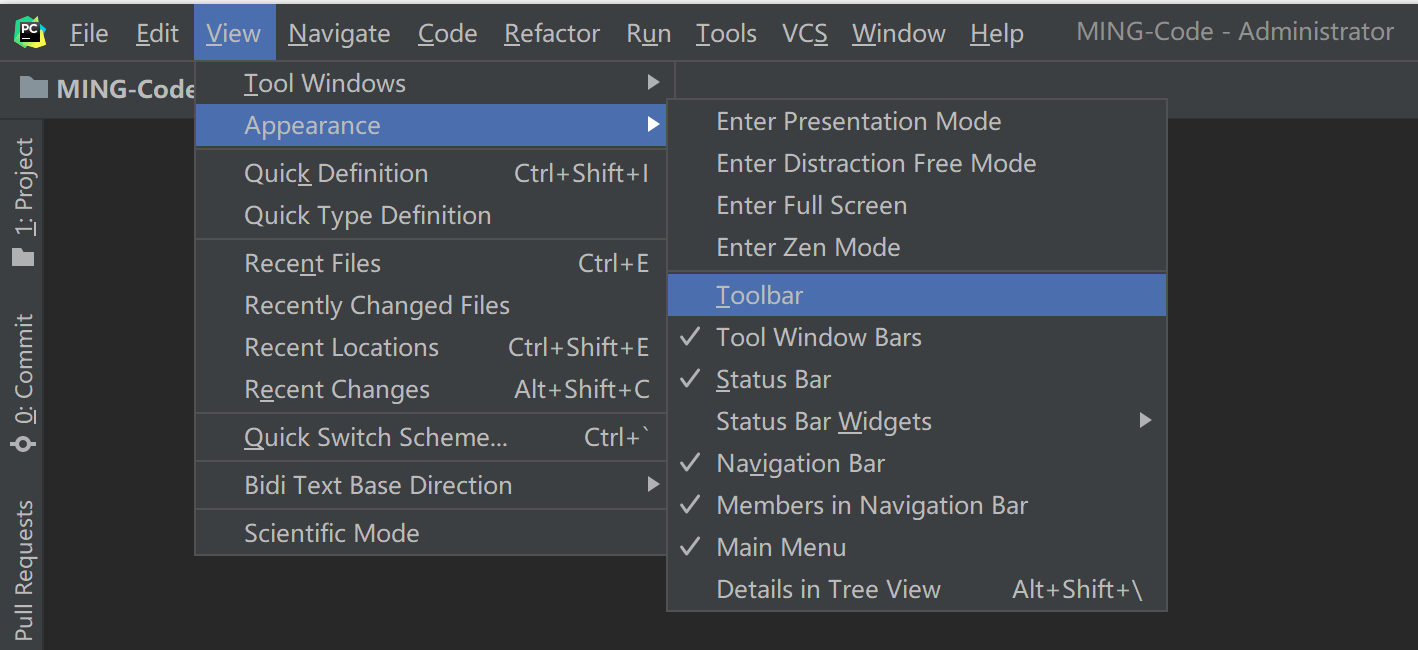

首先,点击 View -> Appearance 勾上 Toolbar ,来调出工具栏,个人认为这个工具栏对于新手非常有用,使用频率很高。

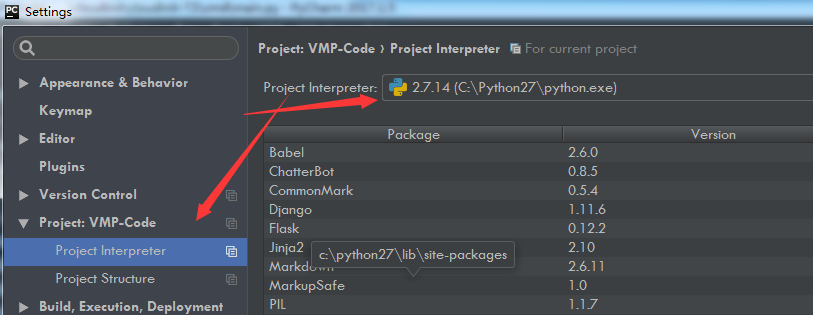

再然后,应该告诉 PyCharm 你的 CPython 解释器在哪里?不然后面要执行 Python 代码的时候,都不知道去哪里找。

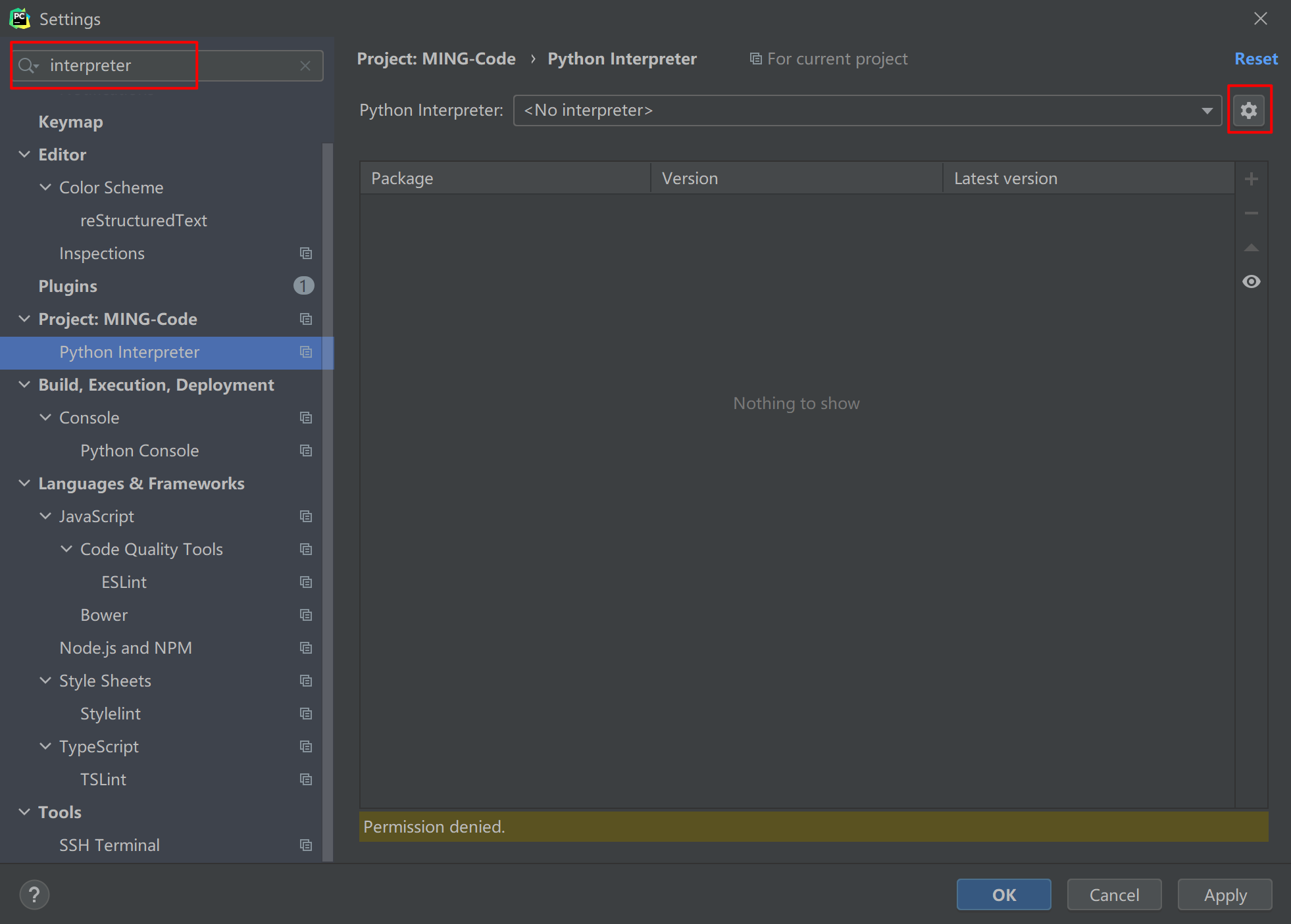

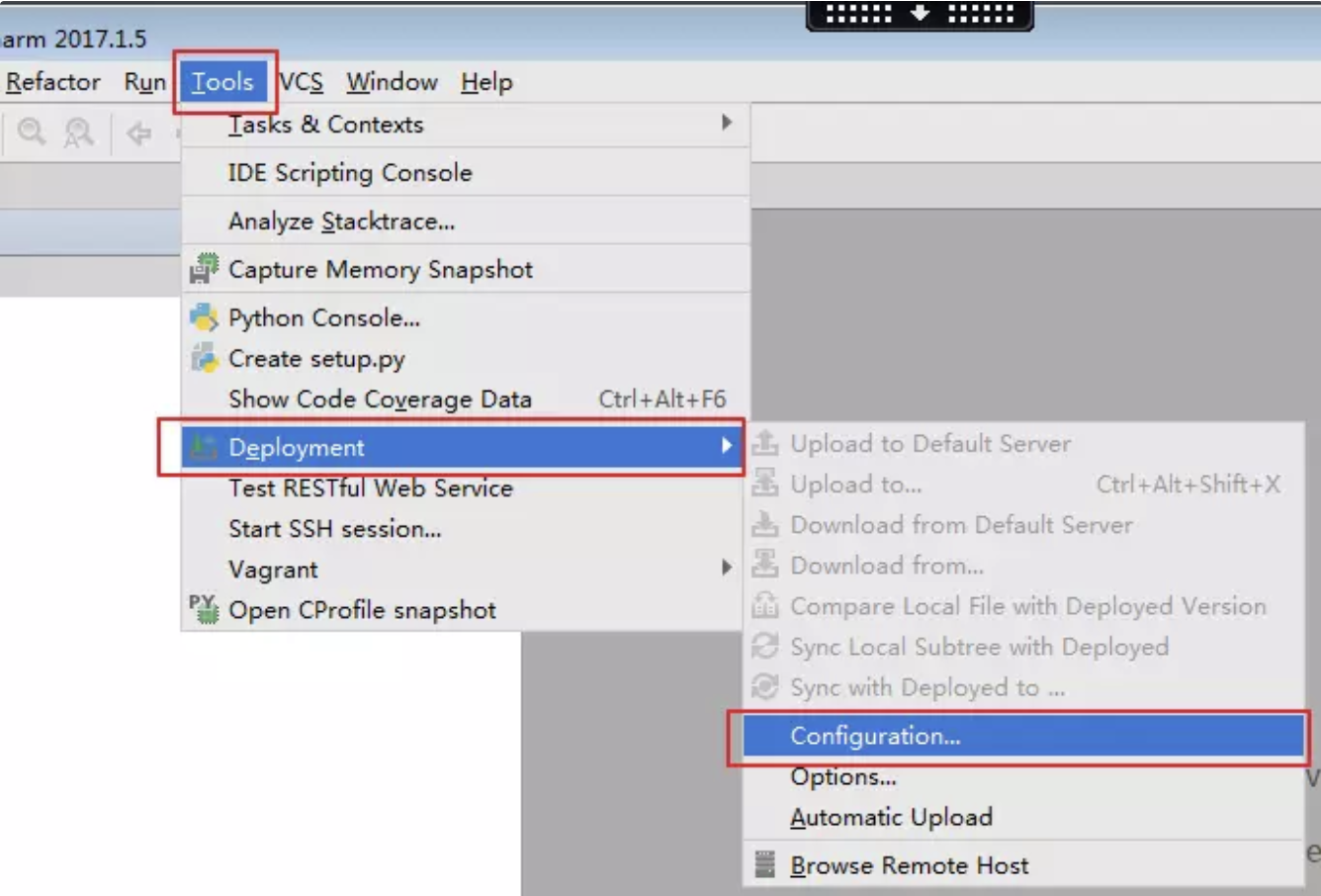

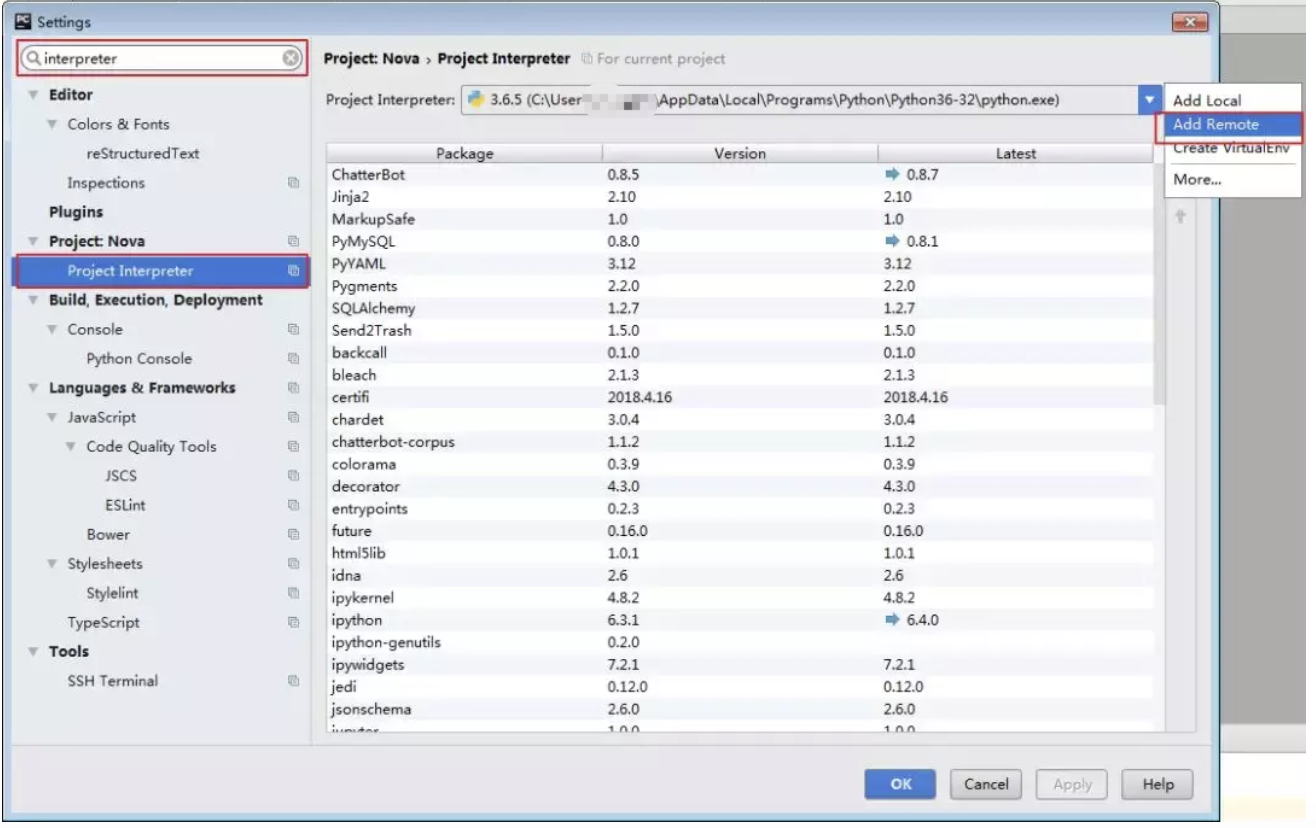

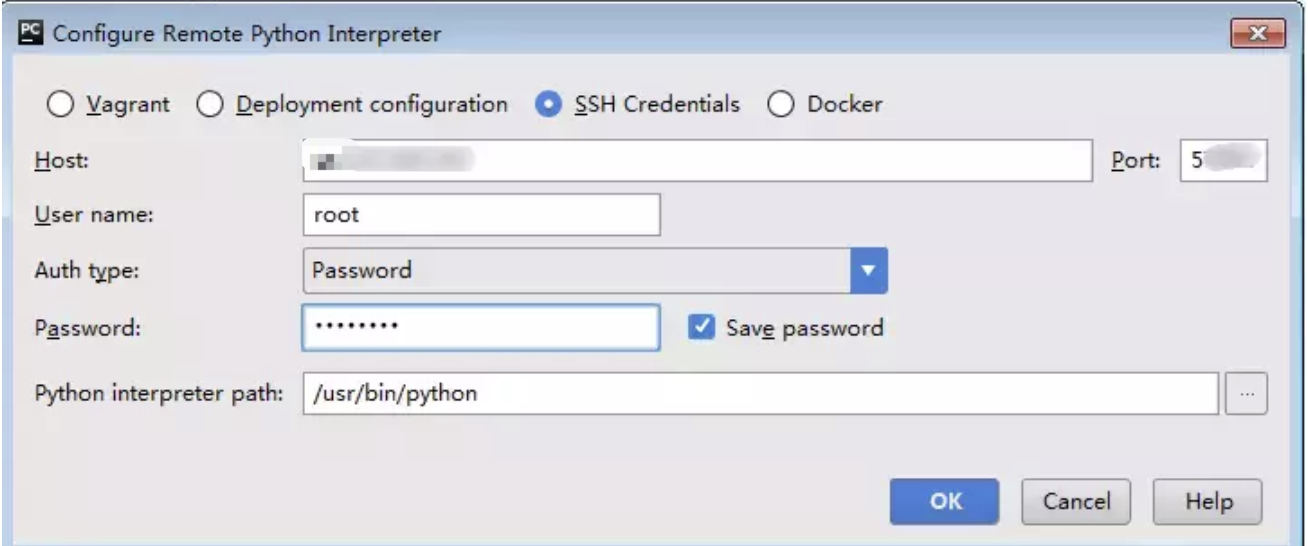

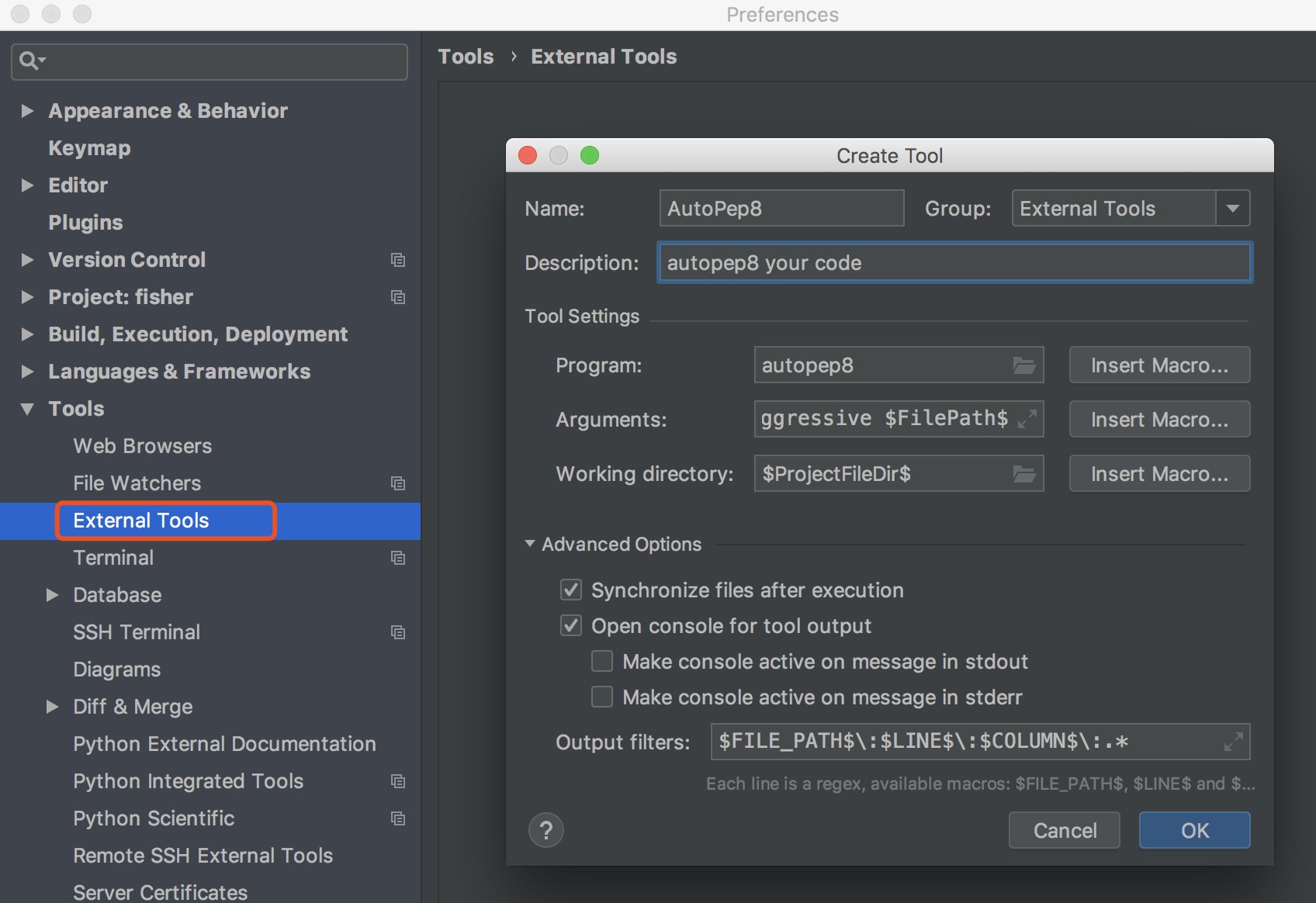

点击 File -> Settings ,就会出现如下界面,在搜索框输入 interpreter ,点击右上角的 Add

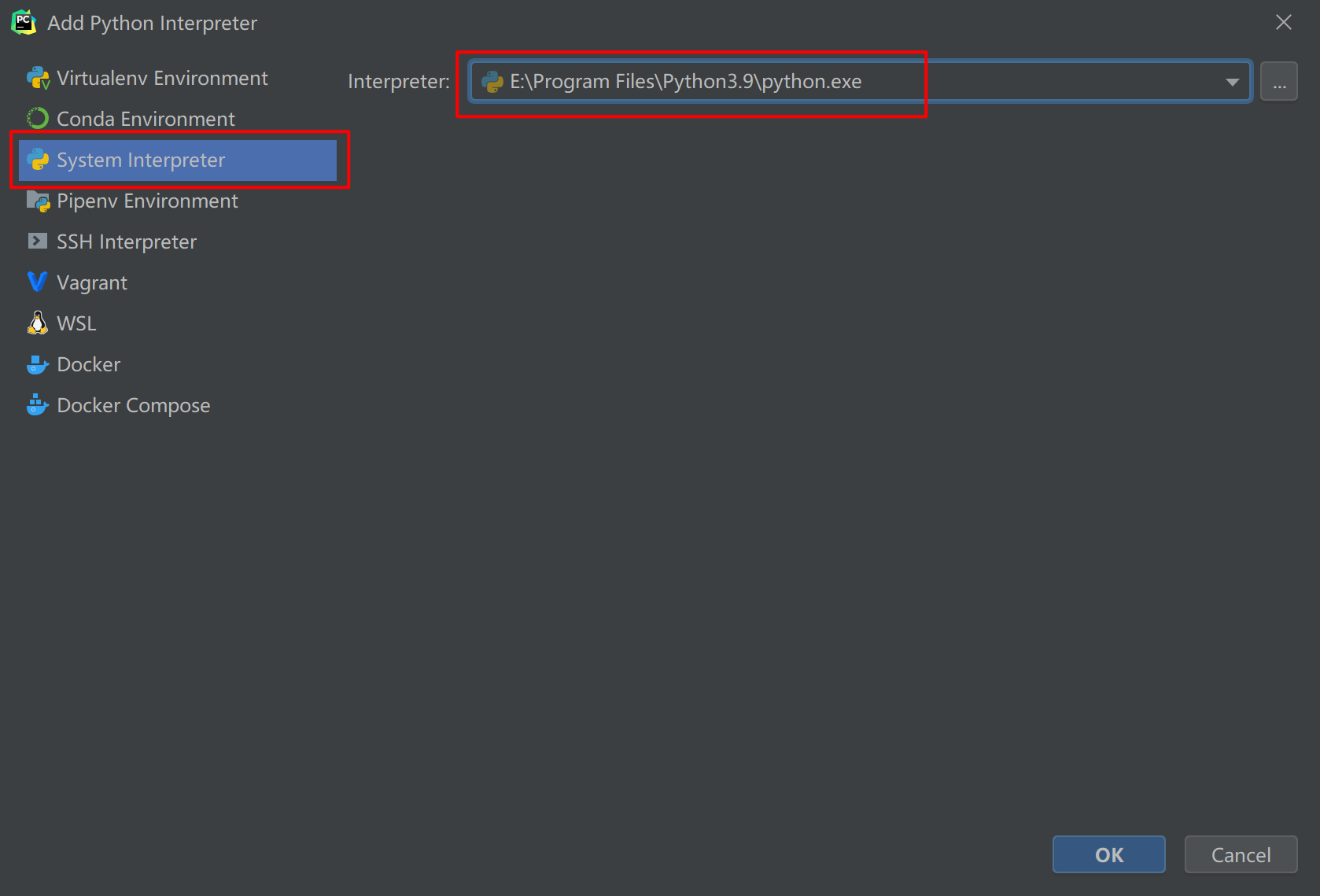

跳到如下界面,再选择 System Interpreter ,然后右边选择你在上一节中安装 CPython 的路径。

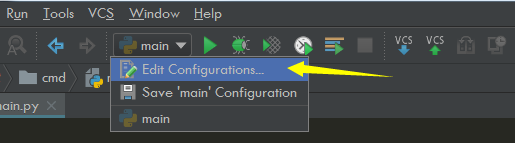

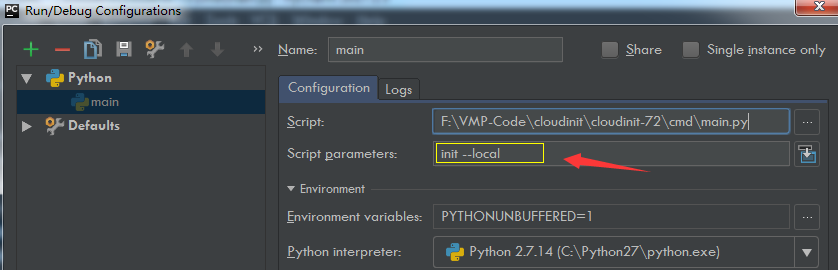

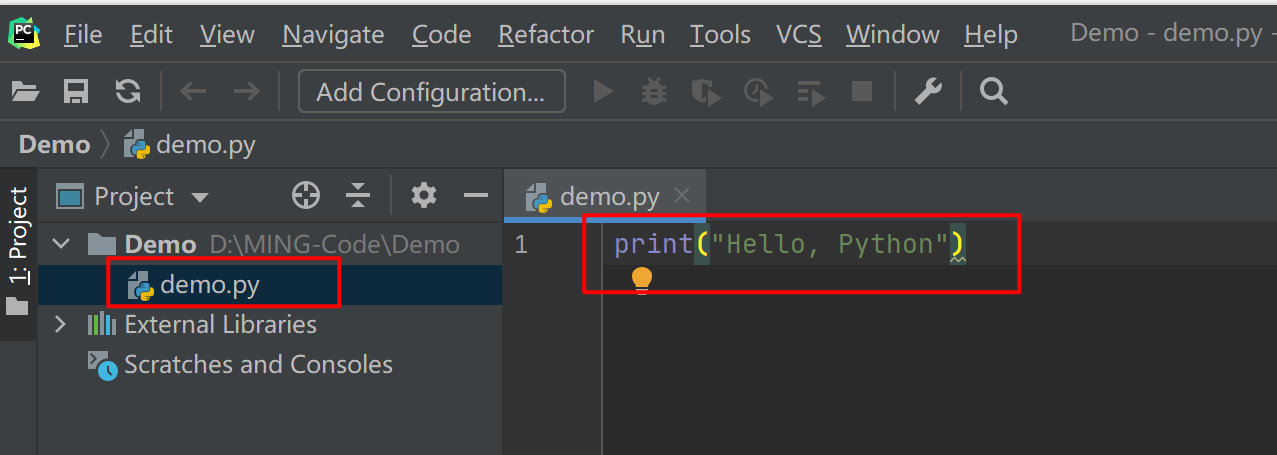

然后在文件夹下,新建一个 demo.py 的文件,并写入如下代码,然后再点击上面的 Add Configuration 配置脚本运行的参数

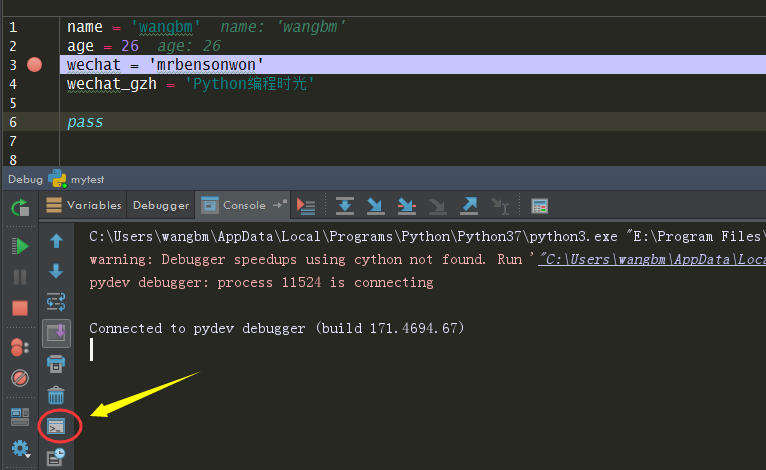

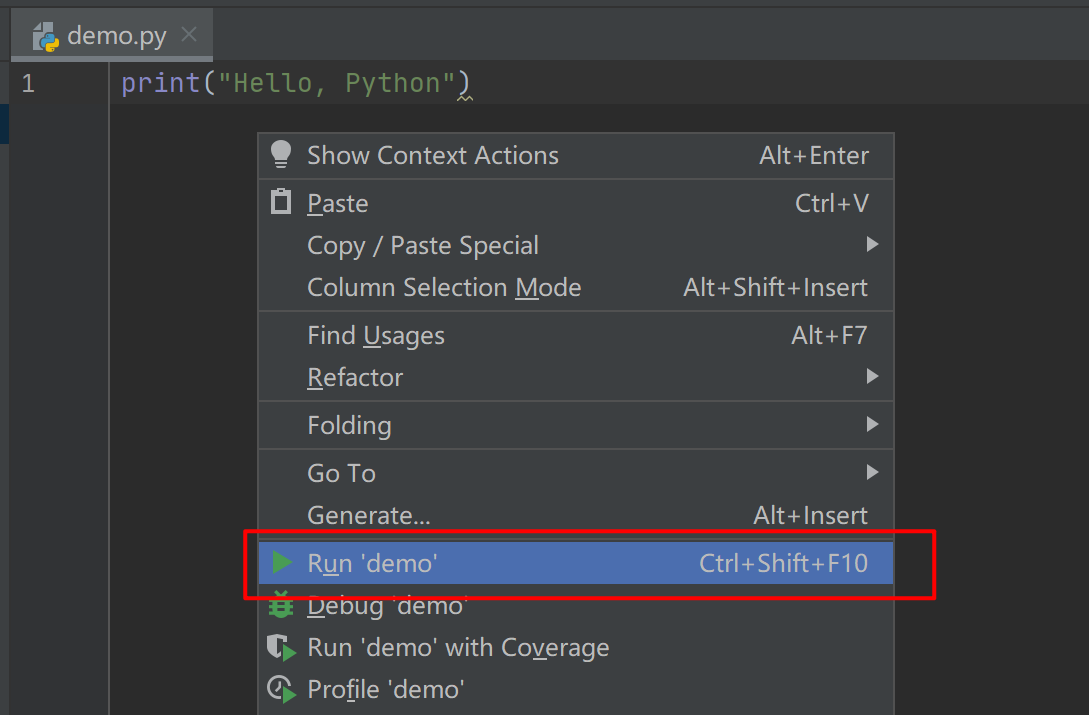

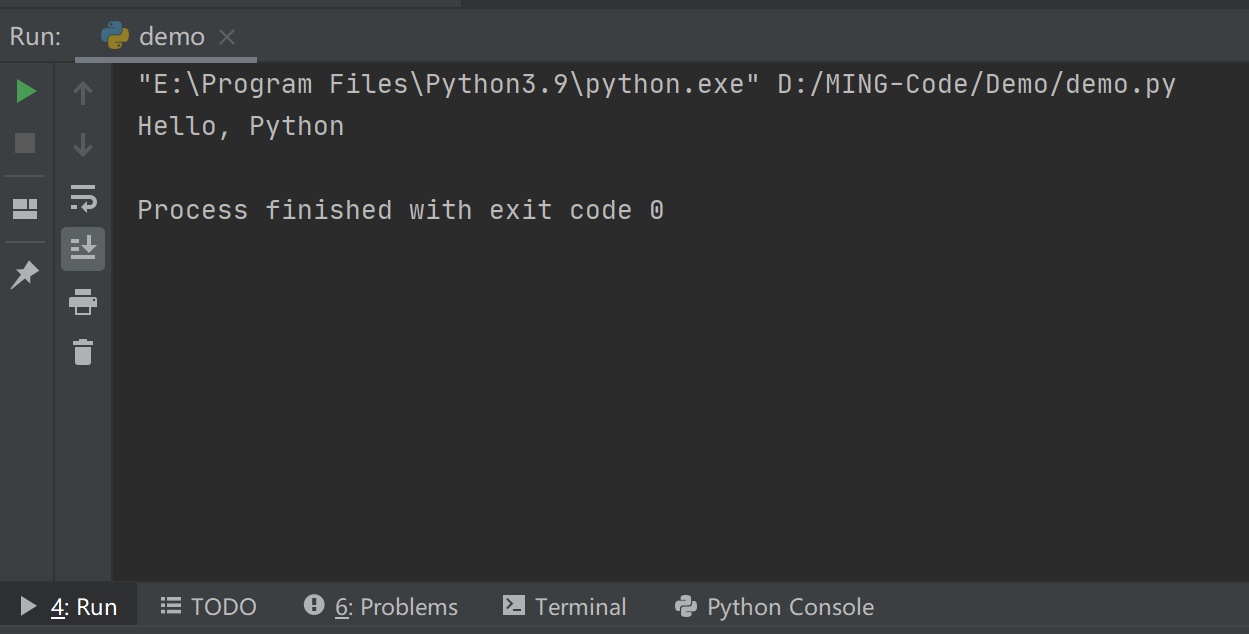

接下来,我们要在 PyCharm 中运行这个 demo.py 这个脚本了。右键然后选择 Run 'demo' ,或者直接按住快捷键:Ctrl+Shift+F10

运行后,在下面就会弹出一个 Run 窗口,你在执行 Python 脚本时,所有的输出内容,都会出现在这里。

至此, PyCharm 这个非常好用的集成开发环境就配置完成了,后面我们就要正式开始接触代码了。

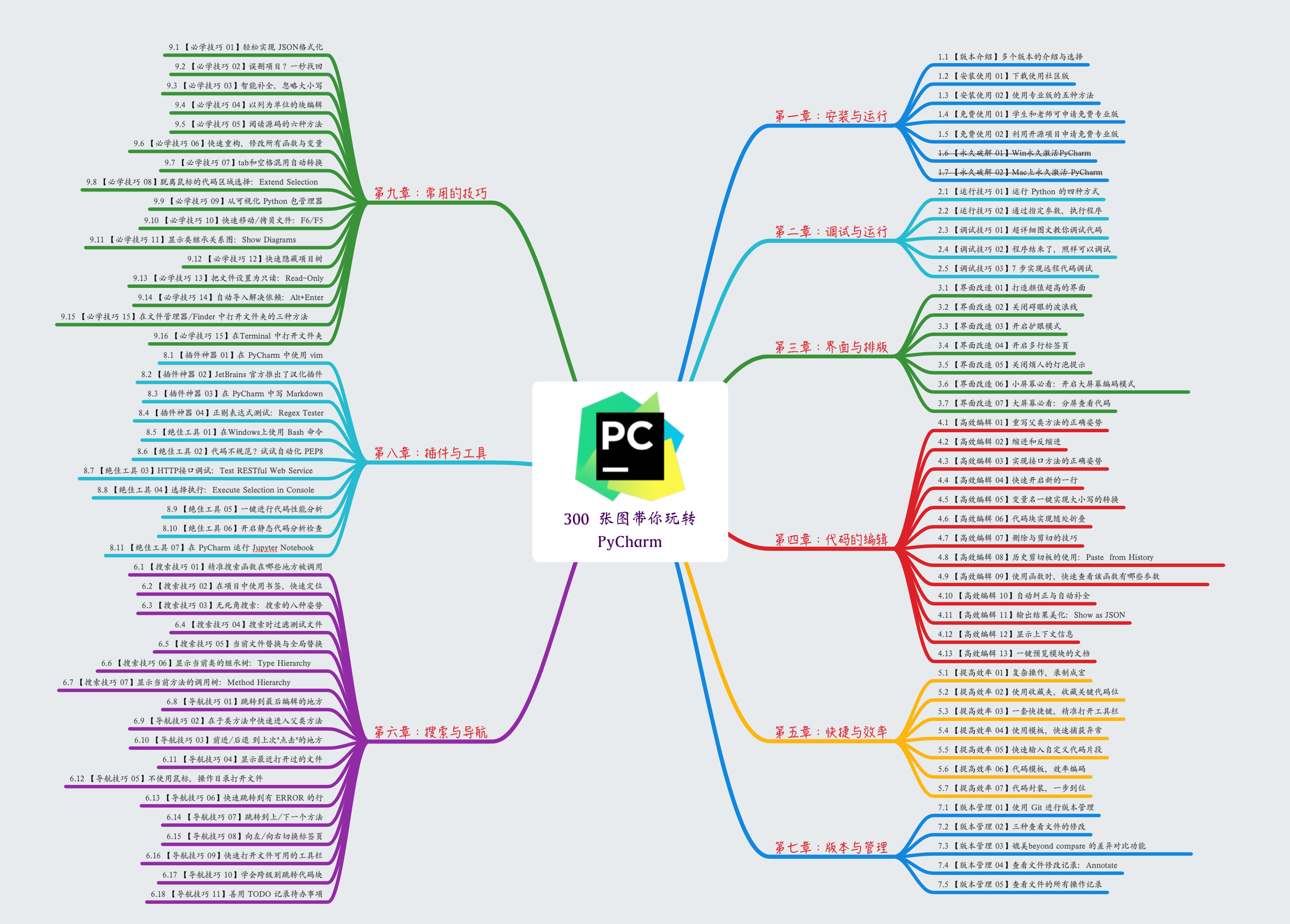

另外,关于 PyCharm 的使用,我花了两个月的时间,整理了一份非常实用且全面的 《PyCharm 中文指南》,点击这个链接,即可跳转学习:https://pycharm.iswbm.com/

1.3 【基础】两种运行 Python 程序方法

前两节我们安装好了 CPython 解释器,有了解释器,就可以运行 Python 程序了。

Python 程序的执行分为两种:

使用Python Console 界面上执行 Python 语句

使用命令行执行

.py后缀的脚本文件

下面分别对这两种方法进行演示。

1. 第一种方法

首先打开你的终端,直接输入 python3 回车,然后输入 print("Hello, World"),就时候就会在屏幕上打印出 Hello, World 这几个字符。print 是 Python 的一个函数,通过它可以把你内容输出到终端屏幕上。这是我们写的第一行 Python 代码,调用的第一个 Python 函数,也是第一个 Python 程序。

2. 第二种方法

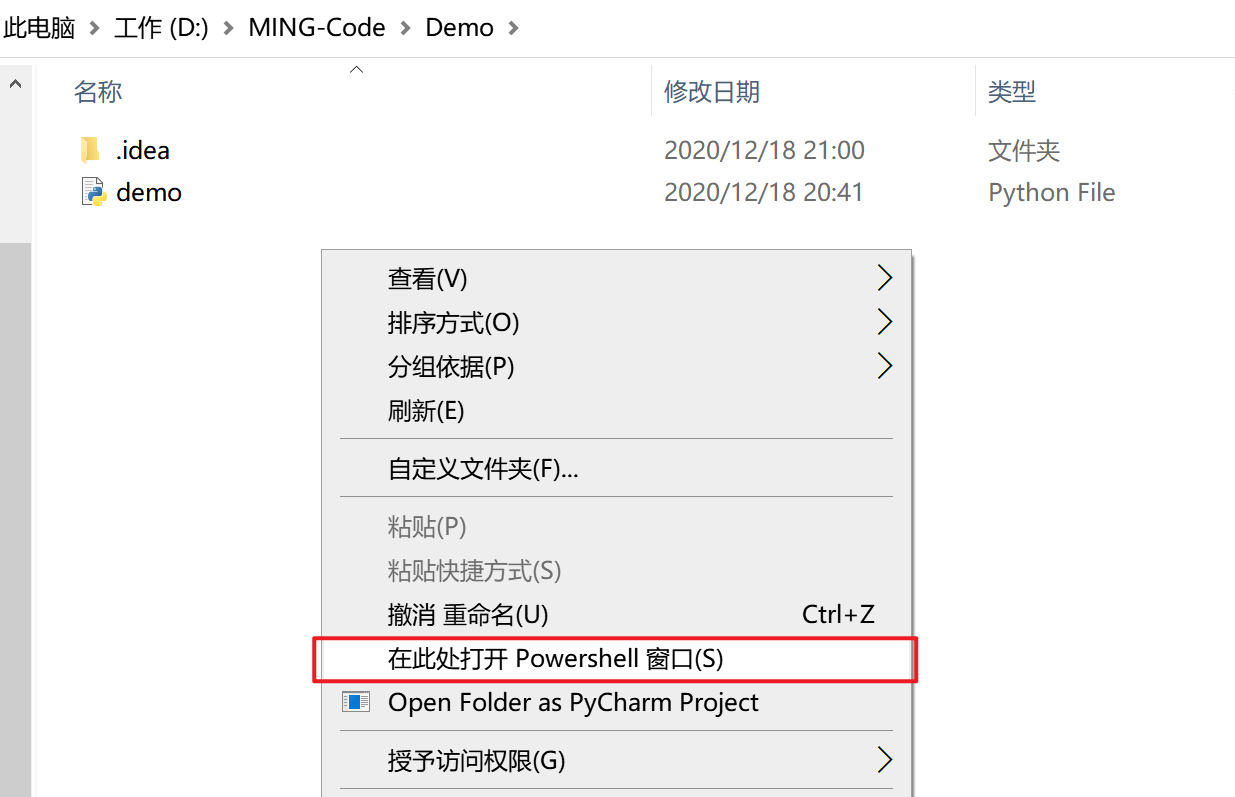

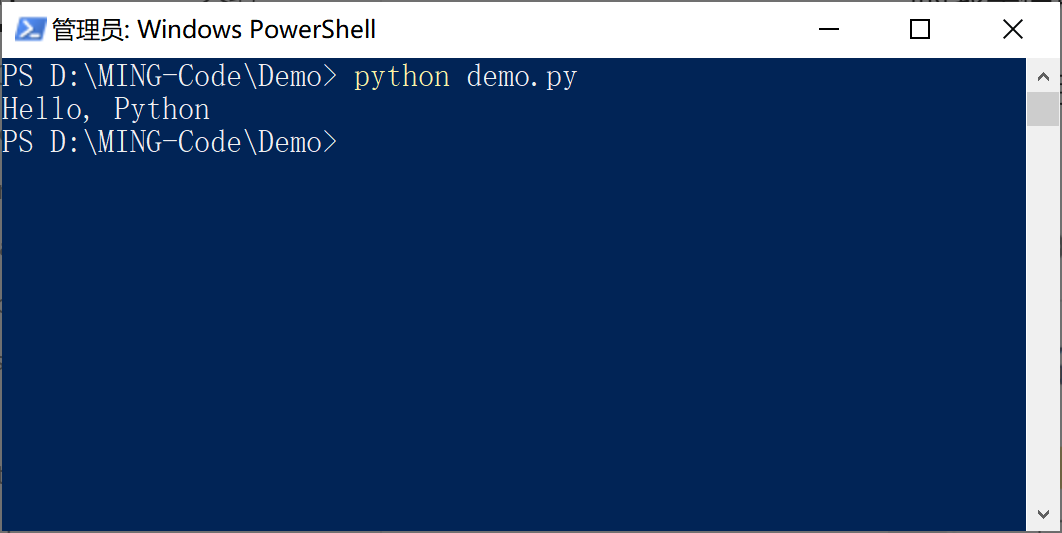

还记得我们在上一节中新建了个 Python 脚本文件 demo.py 吗?

当时我是使用 PyCharm 直接执行的,隐藏了一些运行细节,如果我不想通过 PyCharm 来执行脚本,有什么办法呢?

首先先进入脚本所在的文件夹,然后按住 Shift 和 右键,再点击如图位置打开 PowerShell

然后在 PowerShell 中输入 python dmeo.py,就可以执行这个 python 脚本啦。

以上介绍了两种最原始的 Python 程序的执行方式。

3. 重要提示

- 在后面学习 Python 基础的时候,我在演示案例的时候,都会使用第一种方法(代码框里最前面会有

>>>标识),请你注意,后面不再提及。 - 实际上不管你使用哪个编辑器和 IDE 执行 Python 文件,它们的本质都是采用的第二种方法,因此这里很有必要向你介绍。

第二章:数据类型

2.1 【基础】常量与变量

变量:在程序运行过程中,值会发生变化的量

常量:在程序运行过程中,值不会发生变化的量

无论是变量还是常量,在创建时都会在内存中开辟一块空间,用于保存它的值。

1. 变量不需要声明类型

Python 的变量和常量不需要事先声明类型,这是根据Python的动态语言特性而来。

例如下面的 age 和 name 两个变量,在使用前没有进行任何的诸如 age int 和 name string 的类型声明,而这在一些静态语言中,比如 JAVA 和 Golang 中是必须的。

1 | |

2. 赋值与比较

Python 中 用 = 号来给变量赋值,比如下面这个表达式,age 这个变量的值就是 18

1 | |

与之相似的,新手会容易混淆的是 两个等号 == ,它表示的是比较两个值是否相等,如果相等返回 True,如果不相等返回 False

1 | |

3. 先创建再使用

每个变量在使用前都必须赋值,变量赋值以后才会被创建。

新的变量通过赋值的动作,创建并开辟内存空间,保存值。

如果没有赋值而直接使用,会抛出变量未定义的异常。例如:

1 | |

4. 赋值的方式

赋值的两种方式

第一种:单个直接赋值

1 | |

第二种:多个批量赋值

1 | |

第三种:先计算再赋值

1 | |

第四种:分别赋值

1 | |

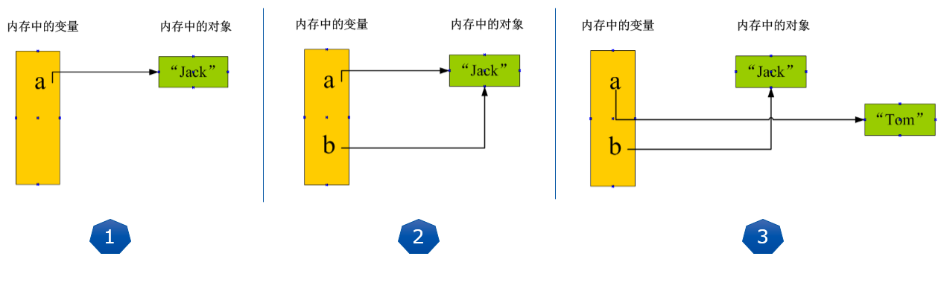

5. 理解赋值的背后

理解变量在计算机内存中的表示也非常重要。

当我们写:a = "Jack" 时,Python解释器干了两件事情:

在内存中创建了一个

'Jack'的字符串对象;在内存中创建了一个名为a的变量,并把它指向

'Jack'。

而当你把一个变量a赋值给另一个变量b,这个操作实际上是将变量b指向变量a所指向的数据,例如下面的代码:

1 | |

通过 id() 可以查看变量值的内存地址,打印出来的 a 和 b的内存地址是一样的,因此二者其实是一个数据。

但如果继续对 a 进行赋值其他值, 会发现 a 的内存地址变了,而 b 的并没有变

1 | |

请牢记:Python中的一切都是对象,变量是对象的引用!:

- 执行a = ‘Jack’,解释器创建字符串‘Jack’对象和变量a,并把a指向‘Jack’对象;

- 执行b = a,解释器创建变量b,并且将其指向变量a指向的字符串‘Jack’对象;

- 执行a = ‘Tom’,解释器创建字符串‘Tom’对象,并把a改为指向‘Tom’对象,与b无关。

6. 简单介绍常量

说完变量,还要说下常量。

常量就是不变的变量,比如常用的数学常数圆周率就是一个常量。在Python中,通常用全部大写的变量名表示常量:

1 | |

但事实上,从Python语法角度看,PI仍然是一个变量,因为Python根本没有任何机制保证PI不会被改变。你完全可以给PI赋值为10,不会弹出任何错误。所以,用全部大写的变量名表示常量只是一个习惯上的用法。

常量通常放置在代码的最上部,并作为全局使用。

2.2 【基础】字符串类型

1. 如何定义字符串?

字符串是Python中最常用的数据类型之一。

使用单引号或双引号来创建字符串,使用三引号创建多行字符串。字符串要么使用两个单引号,要么两个双引号,不能一单一双!Python不支持单字符类型,单字符在Python中也是作为一个字符串使用。

以下四种写法是等价的

1 | |

如果一个字符串里,要有引号,那么最好和外部包裹的引号类型不同,比如

- 外层使用单引号,那么里层使用双引号

1 | |

- 外层使用双引号,那么里层使用单引号

1 | |

若想使用一样的符号呢?那字符串里的引号前记得加转义符号:\

1 | |

2. 常用的方法

字符串对象本身自带了许多非常实用的方法,考虑到新手的接受程序,在这里也没必要一一给你介绍。

本篇文章只会为你介绍最常用的那些方法,而剩下的你只要在需要的时候去过一下文档就 OK了。

去除首尾空格

1 | |

判断字符串是否以某字符串开头

1 | |

判断字符串是否以某字符串结尾

1 | |

格式化字符串:格式化字符串非常重要,在后面的章节中我有非常详细的讲解,这里你简单了解即可

1 | |

分割字符串:以逗号为分割符分割字符串

1 | |

表示数字的时候,有时我们还会用八进制或十六进制来表示:

十六进制:用0x前缀和0-9,a-f表示,例如:0xff00,0xa5b4c3d2。

八进制:用0o前缀和0-7表示,例如0o12

1 | |

2. 浮点数(Float)

浮点数也就是小数,如1.23,3.14,-9.01,等等。

1 | |

之所以称为浮点数,是因为按照科学记数法表示时,一个浮点数的小数点位置是可变的,比如,1.23x10^9和12.3x10^8是完全相等的。浮点数可以用数学写法,如1.23,3.14,-9.01,等等。但是对于很大或很小的浮点数,就必须用科学计数法表示,把10用e替代,1.23x109就是1.23e9,或者12.3e8,0.000012可以写成1.2e-5,等等。

1 | |

3. 复数(Complex)

复数由实数部分和虚数部分构成,可以用a + bj,或者 complex(a,b) 表示,复数的实部a和虚部b都是浮点型。关于复数,不做科学计算或其它特殊需要,通常很难遇到,这里不做过多解释。

1 | |

4. 常用方法

两数运算

两数相加减

1 | |

两数相乘除

1 | |

取模取余

1 | |

计算绝对值

1 | |

数值直接取整

1 | |

数值四舍五入

1 | |

2.4 【基础】布尔值:真与假

1. 什么是布尔值

但在Python语言中,布尔类型只有两个值

True:表示真值False:表示假值

请注意,首字母要大写,不能是其它花式变型。

所有的计算结果,判断表达式调用返回值是True或者False的过程都可以称为布尔运算,例如比较运算。

布尔值通常用来判断条件是否成立。

1 | |

在 Python Shell 的模式下,很容易看出表达式返回的是真值还是假值。

1 | |

2. 布尔类型的转换

Python内置的 bool() 函数可以用来测试一个表达式的布尔值结果。

1 | |

看完上面的例子,可以总结出

下面这些值经过 bool 转换后是假值:

- 0、0.0、-0.0

- None:这个后面会讲到

- 空字符串、空列表、空元组、空字典

而这些会转换成真值

- -1、1或者其他非0数值

- 所有非空字符串,包括

"False" - 所有非空字典、非空列表、非空集合,非空元组

3. 布尔运算

布尔类型可以进行 and、or和 not运算。

and 运算是与运算,只有所有都为True,and运算的结果才是True:

1 | |

or运算是或运算,只要其中有一个为True,or运算结果就是True:

1 | |

not运算是非运算,它是单目运算符,把True变成False,False变成True:

1 | |

再开下脑洞,布尔类型还能做别的运算吗?试试就知道了!

1 | |

真的可以!比较运算,四则运算都没有问题。并且在做四则运算的时候,明显把True看做1,False看做0。往往是我们不知道的细节,有时候给我们带来巨大的困扰和疑惑。更多的运算种类支持,请大家自行测试。

4. 空值:None

空值不是布尔类型,严格的来说放在这里是不合适的,只不过和布尔关系比较紧密。

空值是Python里一个特殊的值,用None表示(首字母大写)。None不能理解为 0,因为0是整数类型,而None是一个特殊的值。

None也不是布尔类型,而是NoneType。

1 | |

2.5 【基础】学会输入与输出

无论是从我们一开始的“hello world”,还是前面章节的里各种例子,基本都是些“自说自话”,展示类的代码片段。只有能够接收用户输入,根据输入动态生成结果,并输出到屏幕上展示出来,才算一个较为完整,起码是有那么点乐趣或者说成就的简单程序。

1. input 输入函数

input函数:获取用户输入,保存成一个字符串。重要的话,说两遍,input函数的返回值是一个字符串类型。哪怕你输入的是个数字1,返回给你的只会是字符串“1”,而不是 整数1。下面是一些简单的展示例子:

1 | |

第一个例子中,inp = input("please input your name: "),input函数里可以提供一个字符串,用来给用户进行输入提示。input函数的返回值赋值给inp这个变量后,inp里就保存了用户输入的值。

type() 是Python内置的函数之一,非常有用,用于查看对象的数据类型。例子中的 name 是一个str字符串类型,这验证了我们前面说的话。

如果你想要输入的是数值,那么需要你手动使用 int() 函数转一下类型

1 | |

有时候可能输入两边会多敲入几个空格,这时候可以使用 strip() 函数去除首尾空格

1 | |

有时候用户输入的内容会不符合程序的预期,比如我想要获取年龄,那输入必然是全数字,而不能是其他非数值,这时候就可以使用 isdigit 函数进行判断

1 | |

input函数有时可以巧妙地用于阻塞或暂停程序

1 | |

此时的input函数不会将输入保存下来,只是用作暂停程序动作。

2. print 输入函数

print函数我们其实已经不陌生了,前前后后也用了不少次,多少有点经验,明白点它的用法了。

print函数用于将内容格式化显示在标准输出上,主要指的是屏幕显示器。

print可以接受多个字符串,字符串类型的变量或者可print的对象。每个字符串用逗号“,”隔开,连成一串输出。print会依次打印每个字符串,同时,每遇到一个逗号“,”就输出一个空格。

1 | |

对于形如print(a+"a"+b)的语句,其实是先计算a+"a"+b的值,然后再通过print打印它。print()会自动执行内部的语句,输出想要的结果。再看一个例子:

1 | |

我们看一下print函数的原型:print(self, *args, sep=' ', end='\n', file=None)

sep参数: 分隔的符号,默认是一个空格;

end参数: 打印后的结束方式,默认为换行符\n。如果,设置end='',则可以不换行,让print在一行内连续打印。活用print的参数,可以实现灵活的打印控制。

1 | |

2.6 【基础】字符串格式化

格式化输出,主要有三种方式

- 使用 % 进行格式化

- 使用 format 函数进行格式化

- 使用 f-string 进行格式化

由于这三种格式化的内容都非常的多,这里仅为了你看本教程后面的内容,我只介绍最常用的几种

第一种方法:使用 %

%s 表示这个位置接的是一个字符串变量

%d 表示这个位置接的是一个整型变量

前面有多少个 %,后面就要有多少个变量,一一对应,多个变量要括号括起来

1 | |

更多的格式化式符号,可以参考这张表

第二种方法:使用 format

在字符串中,使用 {} 进行占位,然后在字符串后跟上 .format() 函数,这个函数的参数就是我们要往字符串中填充的变量。

format 函数会依次填充,比如第一个 {} 会取到第一个参数 name,第二个 {} 会取到第二个参数 age

1 | |

然后如果变量值比较多的话,这样往往会看错乱掉。你可以改成使用索引

1 | |

甚至还可以直接用变量名进行替代

1 | |

更多 format 函数的用法,可详读我另一篇文章:Python强大的格式化format

第三种方法:使用 f-string

这种方法是 Python 3.6 才支持的写法,只要你在字符串前面加一个 f,开启 f-string ,就可以在字符中写入变量。

直接看案例了

1 | |

2.6 【基础】运算符(超全整理)

0. 什么是运算符?

本章节主要说明Python的运算符。举个简单的例子 4 +5 = 9 。 例子中,4和5被称为操作数,”+”号为运算符。

Python语言支持以下类型的运算符:

- 算术运算符

- 比较(关系)运算符

- 赋值运算符

- 逻辑运算符

- 位运算符

- 成员运算符

- 身份运算符

- 运算符优先级

接下来让我们一个个来学习Python的运算符。

1. Python算术运算符

以下假设变量a为10,变量b为20:

| 运算符 | 描述 | 实例 |

|---|---|---|

| + | 加 - 两个对象相加 | a + b 输出结果 30 |

| - | 减 - 得到负数或是一个数减去另一个数 | a - b 输出结果 -10 |

| * | 乘 - 两个数相乘或是返回一个被重复若干次的字符串 | a * b 输出结果 200 |

| / | 除 - x除以y | b / a 输出结果 2 |

| % | 取模 - 返回除法的余数 | b % a 输出结果 0 |

| ** | 幂 - 返回x的y次幂 | a**b 为10的20次方, 输出结果 100000000000000000000 |

| // | 取整除 - 返回商的整数部分 | 9//2 输出结果 4 , 9.0//2.0 输出结果 4.0 |

以下实例演示了Python所有算术运算符的操作

两数相加减

1 | |

两数相乘除

1 | |

取模取余

1 | |

2. Python比较运算符

以下假设变量a为10,变量b为20:

| 运算符 | 描述 | 实例 |

|---|---|---|

| == | 等于 - 比较对象是否相等 | (a == b) 返回 False。 |

| != | 不等于 - 比较两个对象是否不相等 | (a != b) 返回 true. |

| > | 大于 - 返回x是否大于y | (a > b) 返回 False。 |

| < | 小于 - 返回x是否小于y。所有比较运算符返回1表示真,返回0表示假。这分别与特殊的变量True和False等价。注意,这些变量名的大写。 | (a < b) 返回 true。 |

| >= | 大于等于 - 返回x是否大于等于y。 | (a >= b) 返回 False。 |

| <= | 小于等于 - 返回x是否小于等于y。 | (a <= b) 返回 true。 |

以下实例演示了Python所有比较运算符的操作:

判断两数是否相等

1 | |

判断 a 是否大于 b

1 | |

3. Python赋值运算符

以下假设变量a为10,变量b为20:

| 运算符 | 描述 | 实例 |

|---|---|---|

| = | 简单的赋值运算符 | c = a + b 将 a + b 的运算结果赋值为 c |

| += | 加法赋值运算符 | c += a 等效于 c = c + a |

| -= | 减法赋值运算符 | c -= a 等效于 c = c - a |

| *= | 乘法赋值运算符 | c *= a 等效于 c = c * a |

| /= | 除法赋值运算符 | c /= a 等效于 c = c / a |

| %= | 取模赋值运算符 | c %= a 等效于 c = c % a |

| **= | 幂赋值运算符 | c **= a 等效于 c = c ** a |

| //= | 取整除赋值运算符 | c //= a 等效于 c = c // a |

以下实例演示了Python所有赋值运算符的操作:

这里只以加减为例,其它的同理

1 | |

4. Python位运算符

按位运算符是把数字看作二进制来进行计算的。Python中的按位运算法则如下:

| 运算符 | 描述 | 实例 |

|---|---|---|

| & | 按位与运算符 | (a & b) 输出结果 12 ,二进制解释: 0000 1100 |

| | | 按位或运算符 | (a | b) 输出结果 61 ,二进制解释: 0011 1101 |

| ^ | 按位异或运算符 | (a ^ b) 输出结果 49 ,二进制解释: 0011 0001 |

| ~ | 按位取反运算符 | (~a ) 输出结果 -61 ,二进制解释: 1100 0011, 在一个有符号二进制数的补码形式。 |

| << | 左移动运算符 | a << 2 输出结果 240 ,二进制解释: 1111 0000 |

| >> | 右移动运算符 | a >> 2 输出结果 15 ,二进制解释: 0000 1111 |

以下实例演示了Python所有位运算符的操作:

与运算

1 | |

或运算

1 | |

异或运算

1 | |

取反运算

1 | |

左移动运算符

1 | |

右移动运算符

1 | |

5. Python逻辑运算符

Python语言支持逻辑运算符,以下假设变量 a 为 10, b为 20:

| 运算符 | 逻辑表达式 | 描述 | 实例 |

|---|---|---|---|

| and | x and y | 布尔”与” - 如果 x 为 False,x and y 返回 False,否则它返回 y 的计算值。 | (a and b) 返回 20。 |

| or | x or y | 布尔”或” - 如果 x 是非 0,它返回 x 的值,否则它返回 y 的计算值。 | (a or b) 返回 10。 |

| not | not x | 布尔”非” - 如果 x 为 True,返回 False 。如果 x 为 False,它返回 True。 | not(a and b) 返回 False |

以上实例输出结果:

and:必须都为True,才能返回True,否则返回False

1 | |

or:只要有一个为True,就返回True,其他返回False

1 | |

not:与原值取反

1 | |

6. Python成员运算符

除了以上的一些运算符之外,Python还支持成员运算符,测试实例中包含了一系列的成员,包括字符串,列表或元组。

| 运算符 | 描述 | 实例 |

|---|---|---|

| in | 如果在指定的序列中找到值返回True,否则返回False。 | x 在 y序列中 , 如果x在y序列中返回True。 |

| not in | 如果在指定的序列中没有找到值返回True,否则返回False。 | x 不在 y序列中 , 如果x不在y序列中返回True。 |

以下实例演示了Python所有成员运算符的操作:

1 | |

7. Python身份运算符

身份运算符用于比较两个对象的存储单元

| 运算符 | 描述 | 实例 |

|---|---|---|

| is | is是判断两个标识符是不是引用自一个对象 | x is y, 如果 id(x) 等于 id(y) , is 返回结果 1 |

| is not | is not是判断两个标识符是不是引用自不同对象 | x is not y, 如果 id(x) 不等于 id(y). is not 返回结果 1 |

以下实例演示了Python所有身份运算符的操作:

1 | |

8. Python运算符优先级

以下表格列出了从最高到最低优先级的所有运算符:

| 运算符 | 描述 |

|---|---|

| ** | 指数 (最高优先级) |

| ~ + - | 按位翻转, 一元加号和减号 (最后两个的方法名为 +@ 和 -@) |

| * / % // | 乘,除,取模和取整除 |

| + - | 加法减法 |

| >> << | 右移,左移运算符 |

| & | 位 ‘AND’ |

| ^ | | 位运算符 |

| <= < > >= | 比较运算符 |

| <> == != | 等于运算符 |

| = %= /= //= -= += *= **= | 赋值运算符 |

| is is not | 身份运算符 |

| in not in | 成员运算符 |

| not or and | 逻辑运算符 |

以下实例演示了Python运算符优先级的操作:

1 | |

计算顺序是

- 30*2 = 60

- 60/5 = 12.0

- 20 + 12.0 = 32.0

第三章:数据结构

3.1 【基础】列表

列表(英文名 list),是由一系列元素按顺序进行排列而成的容器。

这里面有两个重点:

- 元素:没有要求同一类型,所以可以是任意类型。

- 顺序:按顺序排列而成,说明列表是有序的。

在接下来的例子中,我会向你演示,列表的一些特性和常用的方法。

1. 创建列表

创建列表有两种方法

第一种方法:先创建空列表实例,再往实例中添加元素

1 | |

第二种方法:直接定义列表,并填充元素。

1 | |

很明显,第二种最简单直接,容易理解。并且经过测试,第二种的效率也比第一种的要高。因此推荐新手使用第二种。

2. 增删改查

增删改查:是 新增元素、删除元素、修改元素、查看元素的简写。

由于,内容比较简单,让我们直接看演示

查看元素

使用 [i] 的方式查看第 i+1 个元素。例如 x 的起始值为 0 ,代表第一个元素。

1 | |

使用 index 方法,查看第一个值为 x 的索引。

1 | |

使用 count 方法,查看该列表中有几个值为 x

1 | |

使用内置函数 len(),可以查看该列表中有几个值

1 | |

新增元素

使用列表的 append 、insert、和 extend 方法

- append 方法:将元素插入在列表的最后一个位置

1 | |

- insert 方法:将元素插入在列表的指定的位置

1 | |

- extend:将一个新的列表直接连接在旧的列表后面

1 | |

修改元素

直接使用 list[x]=new_item 的方法直接替换

1 | |

删除元素

使用 pop ,remove 、clear 方法或者 del 语句删除元素

- pop 方法:删除指定位置的元素。默认删除最后一个元素,并返回

1 | |

- remove:删除第一个值为 x 的元素。

1 | |

- clear 方法:把所有的元素清空

1 | |

- del 语句:清空列表,还有另一种方法

1 | |

使用 del 语句,还可以删除某一个或者某几个连续的元素。

1 | |

3. 列表反转

列表反转有两种方法

第一种方法:使用自带的 reverse 方法

1 | |

第二种方法:使用切片的方法

1 | |

这两种方法,区别在于:

- reverse 方法是原地反转,作用在原对象上

- 切片反转是返回一个新对象,原对象不改变

4. 列表排序

列表的排序同样有两种方法:

第一种方法:列表对象内置了 sort 方法,可方便我们对元素进行排序。

1 | |

第二种方法:Python 有个内置的 sorted 函数,它不仅可用作列表的排序,后面我们还会学到 字典 等其他数据结构的排序也会用到它。

1 | |

不管用哪种方法,都要保证列表内的元素俩俩是可比较的。

比如,数值和数值是可比较的,字符串和字符串之间是可比较的。

但是数值和字符串是不可比较的,示例如下

1 | |

除了上面介绍的俩种之外,其实利用 sort 函数还可以实现自定义排序,这部分内容对于新手来说学习起来稍有点难度,且用到的场景也不多,因此这边我就不介绍啦。

3.2 【基础】元组

元组(英文名 tuple),和列表非常的相似,它也是由一系列元素按顺序进行排列而成的容器。

不同的是,元组是不可变的,而列表是可变的。

1. 创建元组

创建元组有三种方法

第一种方法:直接使用 圆括号 将所有的元素进行包围。这有别于创建列表时使用的是中括号:[]

1 | |

第二种方法:有时候,创建元组时,圆括号可有可无的。

1 | |

第三种方法:使用元组推导式,由于元组是不可变的,所以生成一个生成器对象。这一种对于新手来说可能会比较难以理解,我会放在后面专门进行讲解,这里先作了解,新手可直接跳过。

1 | |

上面三种方法介绍完毕~

你以为就这么简单?

当你在创建只有一个元素的元组时,你有可能会这样子创建

1 | |

却发现,创建出来的并不是 tuple,而是一个 int 对象。

此时千万要记住,当你创建只包含一个元素的元组时,要在第一个元素后面加一个逗号

1 | |

另外,创建空元组可以这样

1 | |

2. 增删改查

最前面我们说过,元组是不可变的。因此,你想对元组进行修改的行为都是不被允许的。

呐,看一下示例,查看元素可以,但是修改元素和删除元素都报错了。

1 | |

新增元素呢?当然同样也是不支持的,这里不再演示。

3. 元组与列表的转换

虽然元组可能看起来与列表很像,但它们通常是在不同的场景被使用,并且有着不同的用途。

元组是 immutable (不可变的),其序列通常包含不同种类的元素,并且通过解包或者索引来访问(如果是 namedtuples 的话甚至还可以通过属性访问)。

列表是 mutable (可变的),并且列表中的元素一般是同种类型的,并且通过迭代访问。

那有办法可以实现二者的转换吗?

当然有,而且非常简单。

将元组转成列表

1 | |

将列表转成元组

1 | |

3.3 【基础】字典

字典(英文名 dict),它是由一系列的键值(key-value)对组合而成的数据结构。

字典中的每个键都与一个值相关联,其中

- 键,必须是可 hash 的值,如字符串,数值等

- 值,则可以是任意对象

1. 创建字典

创建一个字典有三种方法

第一种方法:先使用 dict() 创建空字典实例,再往实例中添加元素

1 | |

第二种方法:直接使用 {} 定义字典,并填充元素。

1 | |

第三种方法:使用 dict() 构造函数可以直接从键值对序列里创建字典。

1 | |

第四种方法:使用字典推导式,这一种对于新手来说可能会比较难以理解,我会放在后面专门进行讲解,这里先作了解,新手可直接跳过。

1 | |

2. 增删改查

增删改查:是 新增元素、删除元素、修改元素、查看元素的简写。

由于,内容比较简单,让我们直接看演示

查看元素

查看或者访问元素,直接使用 dict[key] 的方式就可以

1 | |

但这种方法,在 key 不存在时会报 KeyValue 的异常

1 | |

所以更好的查看获取值的方法是使用 get() 函数,当不存在 gender 的key时,默认返回 male

1 | |

新增元素

新增元素,直接使用 dict[key] = value 就可以

1 | |

修改元素

修改元素,直接使用 dict[key] = new_value 就可以

1 | |

删除元素

删除元素,有三种方法

第一种方法:使用 pop 函数

1 | |

第二种方法:使用 del 函数

1 | |

3. 重要方法

判断key是否存在

在 Python 2 中的字典对象有一个 has_key 函数,可以用来判断一个 key 是否在该字典中

1 | |

但是这个方法在 Python 3 中已经取消了,原因是有一种更简单直观的方法,那就是使用 in 和 not in 来判断。

1 | |

设置默认值

要给某个 key 设置默认值,最简单的方法

1 | |

实际上有个更简单的方法

1 | |

3.4 【基础】集合

集合(英文名 set),它是一个无序的不重复元素序列。

这里面有两个重点:

- 无序,

- 不重复

1. 创建集合

集合的创建有两种方法

第一种方法:使用 花括号 {} 直接创建,创建的时候,{} 可以包含有重要的元素,但是创建完后,集合会去重,只留第一个。

1 | |

第二种方法:使用 set() 方法进行创建,当 set() 函数不接任何参数时,创建的是空集合,如果不创建空集合,可以传入一个列表。

1 | |

2. 增删改查

增加元素

使用 add 函数可以往集合中传入函数

1 | |

另外,还可以使用 update 函数,来往集合中添加元素,update 函数后可接集合,列表,元组,字典等。

这是接集合的例子

1 | |

删除元素

使用 remove 函数可以删除集合中的元素

1 | |

使用 remove 函数,如果对应的元素不存在,是会报错的。

1 | |

对于这种情况,你可以使用 discard 函数,存在元素则移除,不存在也不会报错。

1 | |

此外,还有一个 pop 函数,用于从集合中随机删除元素,和列表、字典的 pop 不一样,这里的 pop 不能加任何的参数。

1 | |

最后,还要介绍一个 clear 函数,它用于清空集合的元素。

1 | |

修改元素

文章开头处,已经说明了集合是 无序 的,因此集合是没有索引的。

既然没有索引,修改也无从谈起。

记住:集合只有添加元素、删除元素。

查询元素

同上,没有顺序,也就没有索引,没有索引,查询也无从谈起。

但是我们可以查看集合的其他内容

比如,查看集合的长度

1 | |

3. 集合运算

求合集

将两个集合进行合并并去重,可以使用 union 函数,下面的示例中,由于 Huawei 是重复的元素,只会保留一个。

1 | |

另外还可以使用 | 的操作符

1 | |

求差集

要找出存在集合 A 但是不存在 集合 B 的元素,就是对两个集合求差集。

可以使用 difference 函数,下面的示例中, Apple 在 aset 中存在,但在 bset 中不存在。

1 | |

另外还可以使用 - 的操作符,更加直观

1 | |

求交集

要找出存在集合 A 并且存在集合 B 的元素,就是对两个集合求交集。

可以使用 intersection 函数

1 | |

和 intersection 相似的还有一个 intersection_update 函数,它们的区别是,intersection_update 会原地更新在 aset 上,而不是会回交集。

1 | |

另外还可以使用 & 的操作符

1 | |

求不重合集

如果计算两个集合中不重复的元素集合,可以使用 symmetric_difference 函数

1 | |

和 symmetric_difference 相似的还有一个 symmetric_difference_update 函数,它们的区别是,symmetric_difference_update 会原地更新在 aset 上,而不是直接返回。

1 | |

4. 集合判断

判断是否有某元素

1 | |

判断两集合是否有相同元素

如果两集合有相同元素,则返回 False,如果没有相同元素,则返回 True

1 | |

判断是否是子集

1 | |

2. 是否可迭代?

对 Python 比较熟悉的朋友,肯定知道哪些数据类型是可迭代的,哪些是不可迭代的。

但是对新手来说,可能需要借助一些函数来判别,比如 Python 内置的 collections.abc 模块,这个模块只有在 Python 中才有噢,在这个模块中提供了一个 Iterable 类,可以用 isinstance 来判断。

1 | |

但是这种方法并不是百分百准确(具体下面会说到),最准确的方法,还是应该使用 for 循环。

3. 可迭代协议

可迭代对象内部是如何实现在你对其进行 for 循环时,可以一个一个元素的返回出来呢?

这就要谈到迭代器协议。

第一种场景:如果一个对象内部实现了 __iter__() 方法 ,并返回一个迭代器实例,那么该对象就是可迭代对象

1 | |

第二种场景:假设一个对象没有实现 __iter__() ,Python 解释器 __getitem__() 方法获取元素,如果可行,那么该对象也是一个可迭代对象。

1 | |

此时如果你使用 isinstance(my_list, Iterable) 去判断是否是可迭代,就会返回 False,因为 isinstance 这种方法就是检查对象是否有 __iter__ 方法。这也论证了使用 isinstance(my_list, Iterable) 去判断是否可迭代是不准确的。

4. 什么是迭代器

当你对一个可迭代对象使用 iter 函数后,它会返回一个迭代器对象,对于迭代器对象,我们可以使用 next 函数,去获取元素,每执行一次,获取一次,等到全部获取完毕,会抛出 StopIteration 提示无元素可取。

1 | |

5. 迭代器协议

对比可迭代对象,迭代器的内部只是多了一个函数而已 – __next__()

正因为有了它,我们才可以用 next 来获取元素。

迭代器,是在可迭代的基础上实现的。要创建一个迭代器,我们首先,得有一个可迭代对象。

现在就来看看,如何创建一个可迭代对象,并以可迭代对象为基础创建一个迭代器。

1 | |

3.6 【基础】生成器

1. 什么是生成器?

生成器(英文名 Generator ),是一个可以像迭代器那样使用for循环来获取元素的函数。

生成器的出现(Python 2.2 +),实现了延时计算,从而缓解了在大量数据下内存消耗过猛的问题。

当你在 Python Shell 中敲入一个生成器对象,会直接输出 generator object 提示你这是一个生成器对象

1 | |

2. 如何创建生成器?

使用列表推导式

在上面已经演示过,正常我们使用列表推导式时是下面这样子,使用 [] ,此时生成的是列表。

1 | |

而当你把 [] 换成 () ,返回的就不是列表了,而是一个生成器

1 | |

使用 yield

yield 是什么东西呢? 它相当于我们函数里的 return,但与 return 又有所不同。

- 当一个函数运行到 yield 后,函数的运行会暂停,并且会把 yield 后的值返回出去。

- 若 yield 没有接任何值,则返回 None

- yield 虽然返回了,但是函数并没有结束

请看如下代码,我定义了一个 generator_factory 函数,当我执行 gen = generator_factory() 时,gen 就是一个生成器对象

1 | |

3. 生成器的使用

从一个生成器对象中取出元素,和我们前面学过的通过切片访问列表中的元素不一样,它没有那么直观。

想要从生成器对象中取出元素,只有两种方法:

第一种方法:使用 next 方法一个一个地把元素取出来,如果元素全部取完了,生成器会抛出 StopIteration 的异常。

1 | |

第二种方法:使用 for 循环一个一个地迭代出来

1 | |

4. 生成器的激活

生成器对象,在创建后,并不会执行任何的代码逻辑。

想要从生成器对象中获取元素,那么第一步要触发其运行,在这里称之为激活。

方法有两种:

- 使用

next():上面已经讲过 - 使用

generator.send(None)

还以下面这段代码为例,可以看到 gen.send(None) 相当于执行了 next(gen)

1 | |

5. 生成器的状态

生成器在其生命周期中,会有如下四个状态

GEN_CREATED# 生成器已创建,还未被激活GEN_RUNNING# 解释器正在执行(只有在多线程应用中才能看到这个状态)GEN_SUSPENDED# 在 yield 表达式处暂停GEN_CLOSED# 生成器执行结束

通过下面的示例可以很轻松地理解这一过程(GEN_RUNNING 这个状态只有在多线程中才能观察到,这里就不演示啦)

1 | |

6. 生成器的异常

在最前面,我有定义了一个生成器函数。

1 | |

在没有元素可返回时,我最后抛出了 StopIteration 异常,这是为了满足生成器的协议。

实际上,如果你不手动抛出 StopIteration,在生成器遇到函数 return 时,会我自动抛出 StopIteration。

请看下面代码,我将 raise StopIteration 去掉后,仍然会抛出异常。

1 | |

第四章:控制流程

4.1 【基础】条件语句:if

1. 简单小例子

如果满足条件 A,则执行代码块 a,否则执行代码块 b。类似这样的控制流程语句,称之为条件语句。

它的基本形式是

1 | |

举个最简单的例子

1 | |

2. 多条件语句

如果需要多次判断可以利用 elif,它的基本形式是

1 | |

举个最简单的例子

1 | |

3. 判断的条件

在 Python 中,值可以分为

假值:None、空列表、空集合、空字典,空元组、空字符串、0、False 等真值:非空列表、非空集合、非空字典,非空元组、非空字符串、非 0 数值、True 等

if 和 elif 后面可以接一个表达式(上面已经举例过),也可以接一个对象。

只要这个对象是真假,代码就会进入相应分支,如果为对象为假值,则继续下一判断。

这边随便以 0 和 1 举例

1 | |

4. 多个条件组合

在讲多个条件组合时,先来了解一下 Python 中的逻辑运算符。

以下假设变量 a 为 10, b为 20:

| 运算符 | 逻辑表达式 | 描述 | 实例 |

|---|---|---|---|

| and | x and y | 布尔”与” - 如果 x 为 False,x and y 返回 False,否则它返回 y 的计算值。 | (a and b) 返回 20。 |

| or | x or y | 布尔”或” - 如果 x 是非 0,它返回 x 的值,否则它返回 y 的计算值。 | (a or b) 返回 10。 |

| not | not x | 布尔”非” - 如果 x 为 True,返回 False 。如果 x 为 False,它返回 True。 | not(a and b) 返回 False |

学习完逻辑运算符,就可以开始写多条件语句

- 如果一个 if 条件需要同时满足多个条件,那么可以使用

and或者& - 如果一个 if 条件只需要满足多个条件的其中一个,那么可以使用

or或者| - 如果一个 if 要求不满足某个条件,那么可以使用

not或者!

1 | |

4.2 【基础】循环语句:for

for 循环可以遍历任何序列的项目,如一个列表或者一个字符串。

它的基本语法是

1 | |

1. 普通循环

直接上案例

1 | |

2. 带索引循环

如果想在循环的时候,把索引也取出来,可以加一个 enumerate 函数

1 | |

3. break 中断

正常情况下,我们都需要 for 循环能够全部循环完,但在某些情况下,需要中断循环的执行,中断循环使用的是 break 关键字。

举个例子

1 | |

4. continue 下一循环

在有些循环中,不需要把 for 的循环体内的代码全部执行完毕,这种情况下,可以使用 continue 关键字,直接进入下一循环。

举个例子,下面的循环中当 i 等于 1 时,就直接跳过了循环。

1 | |

5. for - else 循环

其实在 for 循环语句的后面,可以加一个 else 分支,当代码在 for 循环体中正常执行完,自然就会走到 else 分支中。

那么什么叫做 正常执行完 呢?就是只要不通过 break 语句中断的,都算正常执行完。

先以 continue 为例,所有的循环都非常正常,会走到 else 分支

1 | |

再把 continue 改成 break 后,发现不会走到 else 分支

1 | |

4.3 【基础】循环语句:while

while 语句用于循环执行程序,即在某条件下,循环执行某段程序,以处理需要重复处理的相同任务。

其基本形式为:

1 | |

1. 普通的循环

直接上案例

1 | |

运行后,输出结果

1 | |

2. 无限的循环

当 while 后面的条件一直满足且循环体内一直没有 break ,此时 while 就会变成死循环,就是写 while 循环时千万要注意的。

会造成死循环,无非两种情况:

1、 使用 while True,而且循环体内又没有 break 或者 走不到 break

1 | |

2、 使用一个永远都会成立的判断条件,而且循环体内又没有 break 或者 走不到 break

1 | |

3. while - else 语句

和 for 循环一样, while 循环同样可以加一个 else 分支,当代码在 while 循环体中正常执行完,就会走到 else 分支中。

那么什么叫做 正常执行完 呢?就是只要不通过 break 语句中断的,都算正常执行完。

1 | |

如果在循环体内加 break ,就算是异常退出

1 | |

举个例子。

我想找出一个数值列表中为偶数的元素,并组成新列表,通常不用列表推导式,可以这么写

1 | |

一个简单的功能,写的代码倒是不少。

如果使用了列表推导式,那就简洁多了,而且代码还变得更加易读了。

1 | |

2. 字典推导式

字典推导式的基本格式,和 列表推导式相似,只是把 [] 改成了 {},并且组成元素有两个:key 和 value,要用 key_expr: value_expr 表示。

1 | |

举个例子。

我想从一个包含所有学生成绩信息的字典中,找出数学考满分的同学。

1 | |

3. 集合推导式

集合推导式跟列表推导式也是类似的。 唯一的区别在于它使用大括号{},组成元素也只要一个。

基本格式

1 | |

举个例子

我想把一个数值列表里的数进行去重处理

1 | |

4. 生成器推导式

生成器推导式跟列表推导式,非常的像,只是把 [] 换成了 ()

- 列表推导式:生成的是新的列表

- 生成器推导式:生成的是一个生成器

直接上案例了,找出一个数值列表中所有的偶数

1 | |

5. 嵌套推导式

for 循环可以有两层,甚至更多层,同样的,上面所有的推导式,其实都可以写成嵌套的多层推导式。

但建议最多嵌套两层,最多的话,代码就会变得非常难以理解。

举个例子。

我想打印一个乘法表,使用两个for可以这样写

1 | |

输出如下

1 | |

如果使用嵌套的列表推导式,可以这么写

1 | |

第五章:学习函数

5.1 【基础】普通函数创建与调用

函数是一种仅在调用时运行的代码块。您可以将数据(称为参数)传递到函数中,然后由函数可以把数据作为结果返回。

如果将函数比喻成蛋糕店的话,那么函数的参数就是生产蛋糕的原材料,而函数的返回值就是蛋糕成品。

1. 函数的创建

在 Python 中,使用 def 关键字定义函数

1 | |

举个例子,我这边手动实现一个计算两个数平均值的函数,这边这样子写

1 | |

在定义函数的过程中,需要注意以下几点:

- 函数代码块以

def关键词开头,一个空格之后接函数标识符名称和圆括号(),再接个冒号。 - 任何传入的参数必须放在圆括号中间。

- 函数的第一行语句后可以选择性地使用文档字符串—用于存放函数说明。

- 函数内容以冒号起始,并且缩进。

- 使用return,返回值给调用者,并结束函数。return 关键并不是必须要加,可根据实际需要决定是否要写,若不写的话,默认返回None。

- return语句依然在函数体内部,不能回退缩进。直到函数的所有代码写完,才回退缩进,表示函数体结束。

2. 函数的调用

函数编写出来就是给人调用的。要调用一个函数,必须使用函数名后跟圆括号的方式才能调用函数。

调用的同时要根据函数的定义体,提供相应个数和类型的参数,每个参数之间用逗号分隔。

1 | |

4. 函数的返回

函数的返回值,可以是多种多样的,非常灵活:

可以是任意类型的对象,比如字符串,数值,列表,字典等等

1

2def demo_func():

return 10可以是一个表达式,函数会直接运行表达式,然后返回

1

2def get_average(a, b):

return (a + b)/2可以是函数本身,利用这点可以实现递归调用。

1

2

3

4def fact(n):

if n==1:

return 1

return n * fact(n - 1)另外还可以返回多个值

1 | |

- 可以是其他函数,利用这点可以实现装饰器。这部分属于进阶内容,感兴趣可查看另一章节内容:5.6 精通装饰器的八种用法

1

2

3

4def decorator(func):

def wrapper(*args, **kw):

return func()

return wrapper

5.2. 【基础】11个案例讲解函数参数

1. 参数分类

函数,在定义的时候,可以有参数的,也可以没有参数。

从函数定义的角度来看,参数可以分为两种:

必选参数:调用函数时必须要指定的参数,在定义时没有等号可选参数:也叫默认参数,调用函数时可以指定也可以不指定,不指定就默认的参数值来。

例如下面的代码中,a 和 b 属于必选参数, c 和 d 属于可选参数

1 | |

从函数调用的角度来看,参数可以分为两种:

关键字参数:调用时,使用 key=value 形式传参的,这样传递参数就可以不按定义顺序来。位置参数:调用时,不使用关键字参数的 key-value 形式传参,这样传参要注意按照函数定义时参数的顺序来。

1 | |

最后还有一种非常特殊的参数,叫做可变参数。

意思是参数个数可变,可以是 0 个或者任意个,但是传参时不能指定参数名,通常使用 *args 和 **kw 来表示:

*args:接收到的所有按照位置参数方式传递进来的参数,是一个元组类型**kw:接收到的所有按照关键字参数方式传递进来的参数,是一个字典类型

1 | |

输出如下

1 | |

2. 十一个案例

案例一:在下面这个函数中, a 是必选参数,是必须要指定的

1 | |

案例二:在下面这个函数中,b 是可选参数(默认参数),可以指定也可以不指定,不指定的话,默认为10

1 | |

案例三:在下面这个函数中, name 和 age 都是必选参数,在调用指定参数时,如果不使用关键字参数方式传参,需要注意顺序

1 | |

如果参数太多,你不想太花精力去注意顺序,可以使用关键字参数方式传参,在指定参数时附上参数名,比如这样:

1 | |

案例四:在下面这个函数中,args 参数和上面的参数名不太一样,在它前面有一个 *,这就表明了它是一个可变参数,可以接收任意个数的不指定参数名的参数。

1 | |

案例五:在下面这个函数中,kw 参数和上面的 *args 还多了一个 * ,总共两个 ** ,这个意思是 kw 是一个可变关键字参数,可以接收任意个数的带参数名的参数。

1 | |

案例六:在定义时,必选参数一定要在可选参数的前面,不然运行时会报错

1 | |

案例七:在定义时,可变位置参数一定要在可变关键字参数前面,不然运行时也会报错

1 | |

案例八:可变位置参数可以放在必选参数前面,但是在调用时,必选参数必须要指定参数名来传入,否则会报错

1 | |

案例九:可变关键字参数则不一样,可变关键字参数一定得放在最后,下面三个示例中,不管关键字参数后面接位置参数,还是默认参数,还是可变参数,都会报错。

1 | |

案例十:将上面的知识点串起来,四种参数类型可以在一个函数中出现,但一定要注意顺序

1 | |

试着调用这个函数,输出如下:

1 | |

案例十一:使用单独的 *,当你在给后面的位置参数传递时,对你传参的方式有严格要求,你在传参时必须要以关键字参数的方式传参数,要写参数名,不然会报错。

1 | |

3. 传参的坑

函数参数传递的是实际对象的内存地址。如果参数是引用类型的数据类型(列表、字典等),在函数内部修改后,就算没有把修改后的值返回回去,外面的值其实也已经发生了变化。

1 | |

5.3 【基础】匿名函数的使用

匿名函数(英语:anonymous function)是指一类无需定义标识符(函数名)的函数。通俗来说呢,就是它可以让我们的函数,可以不需要函数名。

正常情况下,我们定义一个函数,使用的是 def 关键字,而当你学会使用匿名函数后,替代 def 的是 lambda。

这边使用def 和 lambda 分别举个例子,你很快就能理解。

1 | |

从上面的示例,我们可以看到匿名函数直接运行,省下了很多行的代码,有没有?

接下来,我们的仔细看一下它的用法

带 if/else

1 | |

嵌套函数

1 | |

递归函数

1 | |

或者

1 | |

从以上示例来看,lambda 表达式和常规的函数相比,写法比较怪异,可读性相对较差。除了可以直接运行之外,好像并没有其他较为突出的功能,为什么在今天我们要介绍它呢?

首先我们要知道 lambda 是一个表达式,而不是一个语句。正因为这个特点,我们可以在一些特殊的场景中去使用它。具体是什么场景呢?接下来我们会介绍到几个非常好用的内置函数。

5.4 【基础】必学高阶函数

1. map 函数

map 函数,它接收两个参数,第一个参数是一个函数对象(当然也可以是一个lambda表达式),第二个参数是一个序列。

它可以实现怎样的功能呢,我举个例子你就明白了。

1 | |

可以很清楚地看到,它可以将后面序列中的每一个元素做为参数传入lambda中。

当我们不使用 map 函数时,你也许会这样子写。

1 | |

2. filter 函数

filter 函数,和 map 函数相似。同样也是接收两个参数,一个lambda 表达式,一个序列。它会遍历后面序列中每一个元素,并将其做为参数传入lambda表达式中,当表达式返回 True,则元素会被保留下来,当表达式返回 False ,则元素会被丢弃。

下面这个例子,将过滤出一个列表中小于0的元素。

1 | |

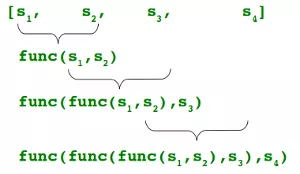

3. reduce 函数

reduce 函数,也是类似的。它的作用是先对序列中的第 1、2 个元素进行操作,得到的结果再与第三个数据用 lambda 函数运算,将其得到的结果再与第四个元素进行运算,以此类推下去直到后面没有元素了。

这边举个例子你也就明白了。

1 | |

它的运算过程分解一下是这样的。

1 | |

4. 注意点

以上几个函数,熟练的掌握它们的写法,可以让我们的代码看起来更加的 Pythonic ,在某一程度上代码看起来更加的简洁。

如果你是新手呢,你需要注意的是,以上示例是在 Python2.x 环境下演示的。而在 Python3.x 中,却有所不同,你可以自己尝试一下。

这里总结一下:

第一点,map 和 filter 函数返回的都不再是一个列表,而是一个迭代器对象。这里以map为例

1 | |

第二点,reduce 不可以直接调用,而是要先导入才能使用,

1 | |

5.5 【基础】反射函数的使用

自省,在我们日常生活中,通常是自我反省的意思。

但在计算机编程中,自省并不是这个意思,它的英文单词是 introspection,表示的是自我检查的行为或能力。

它的内容包括

- 告诉别人,我是谁

- 告诉别人,我能做什么

Python 是一门动态语言,有了自省,就能让程序在运行时能够获知对象的类型以及该对象下有哪些方法等。

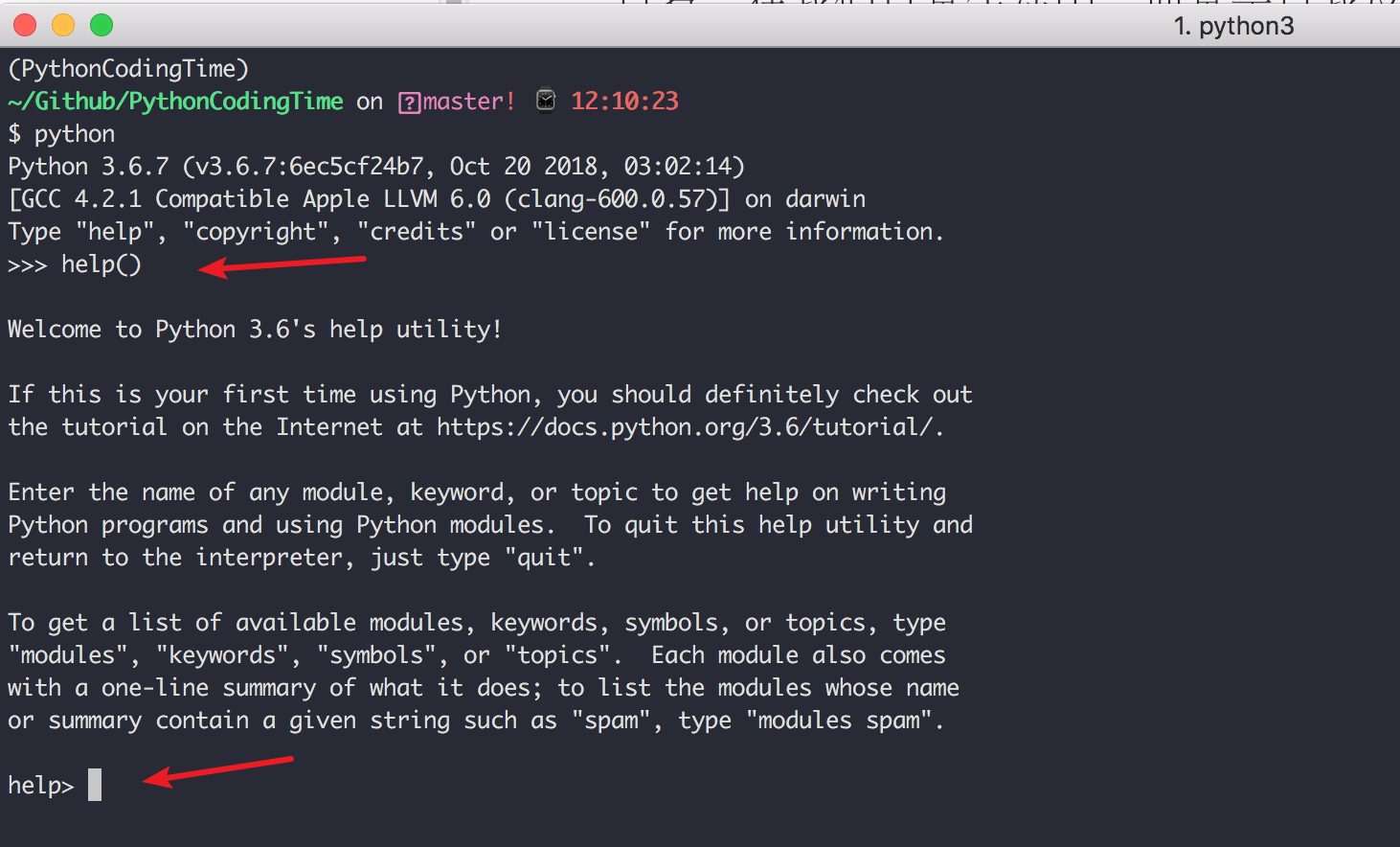

1. 学习 Python 模块的入口

help()

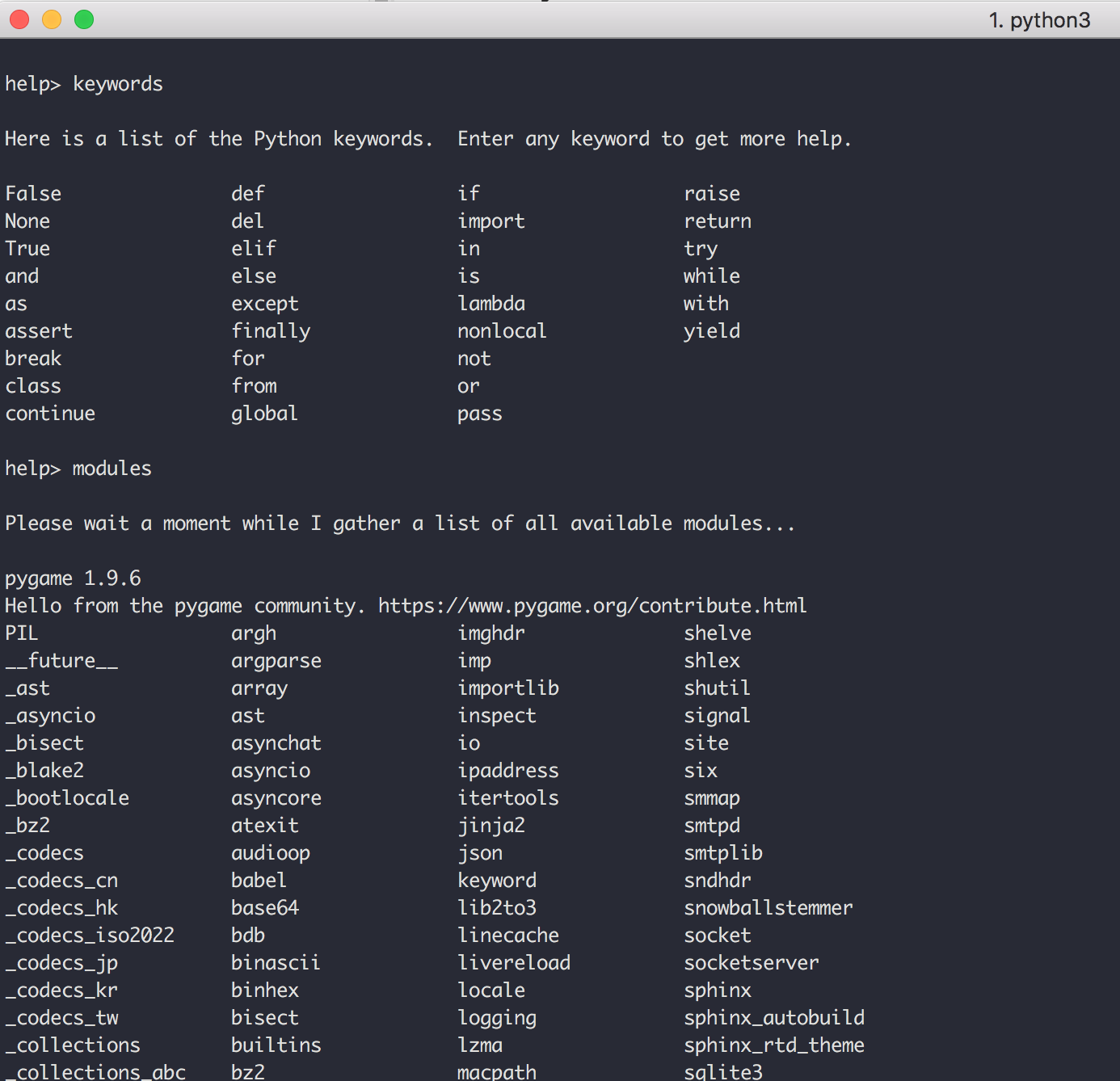

在 console 模式下,输入 help() ,可以看到输出了一段帮助文档,教你如何使用这个 help,当你看到提示符变成了 help> 时,这时候就进入了 help 模式。

此时你可以键入你想要了解的模块、语法等,help 告诉你如何使用。

比如我输入 keywords ,就可以看到 Python 里所有的关键字。再输入 modules 就可以查看 Python 中所有的内置模块。

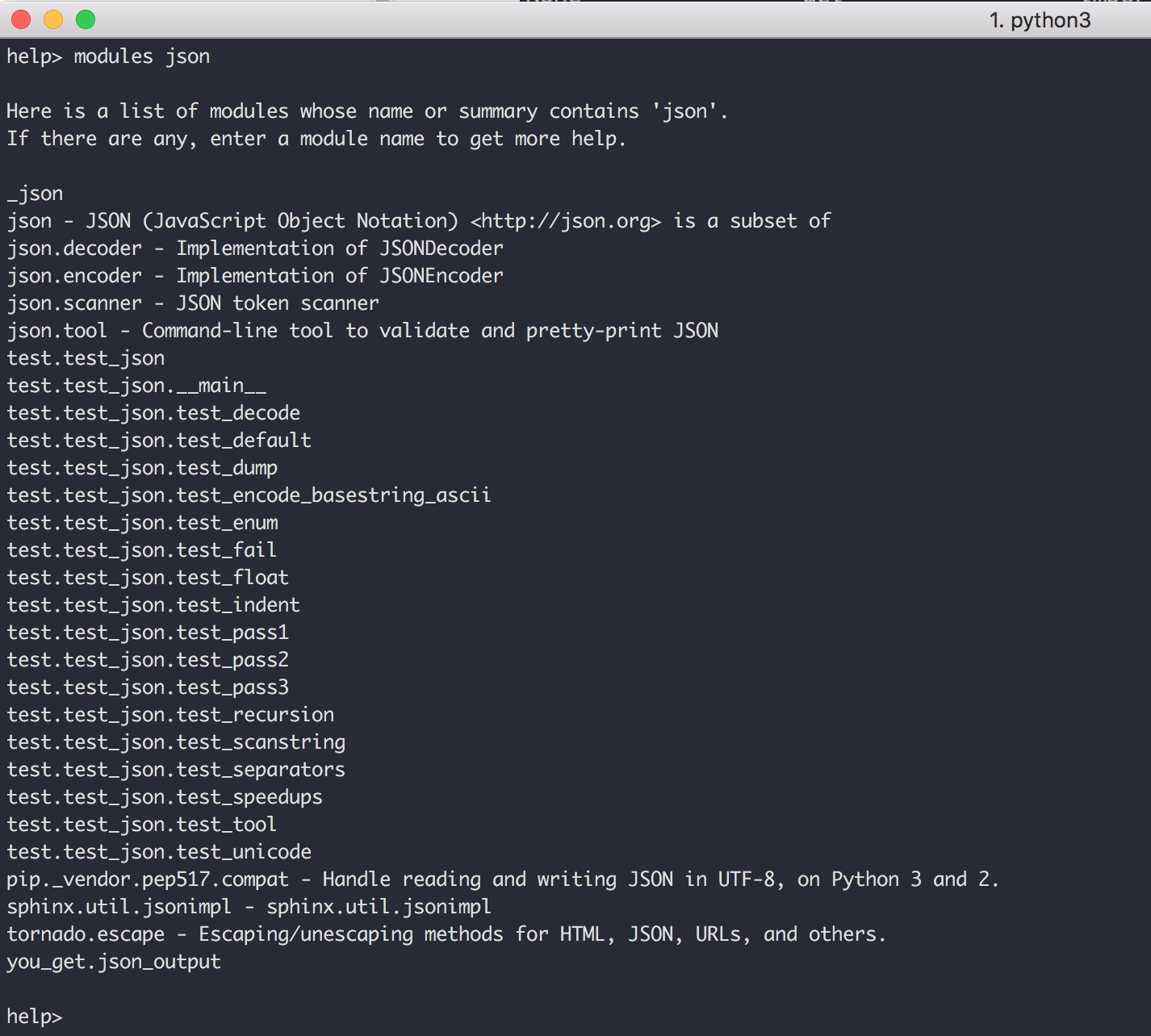

输入 modules + 指定包名,就可以查看这个包下有哪些模块

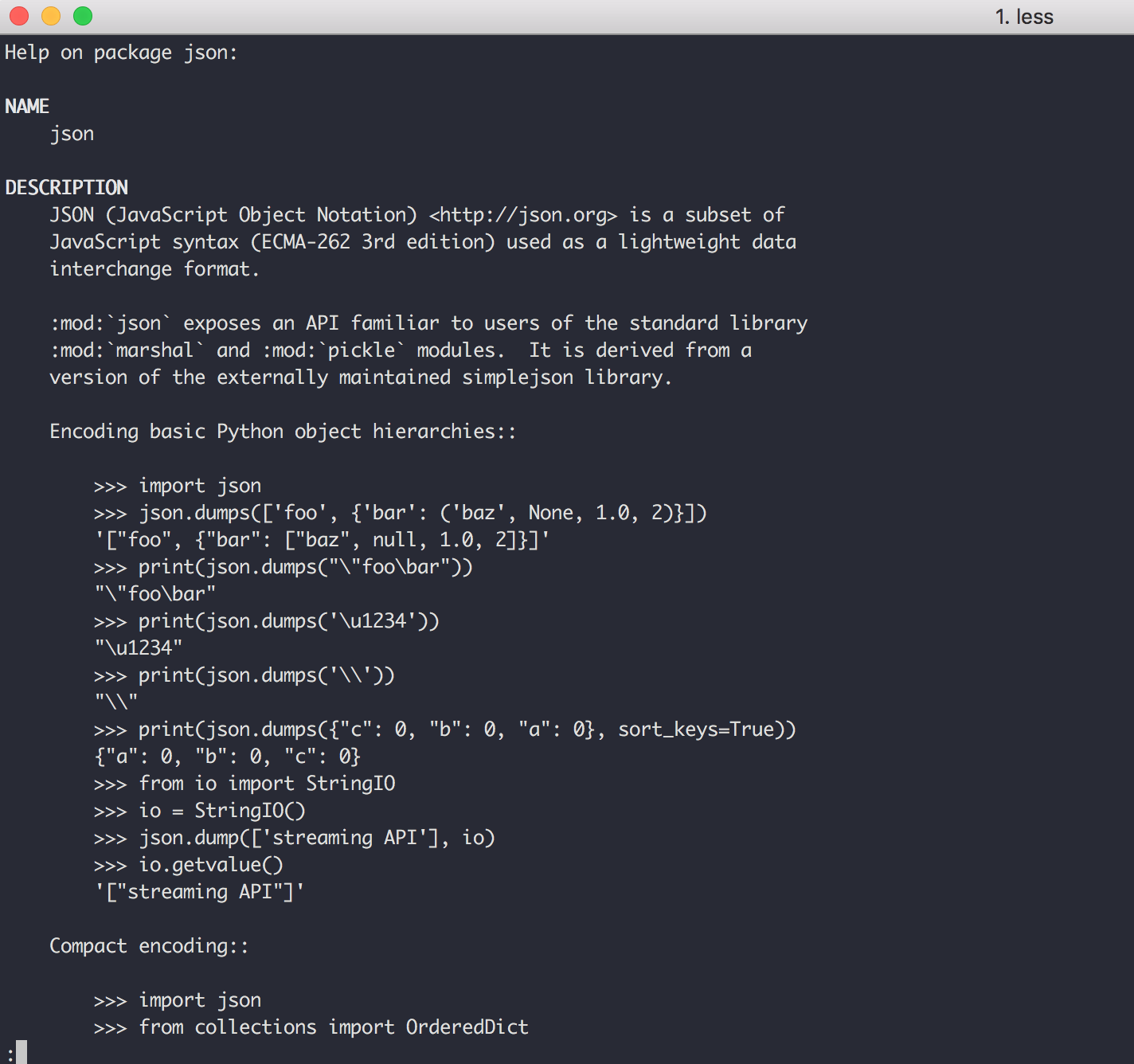

如果你想学习某个包要如何使用,可以直接在 help 模式下输入 包名,就像下面这样,我就可以获得一份 json 的帮助文档。

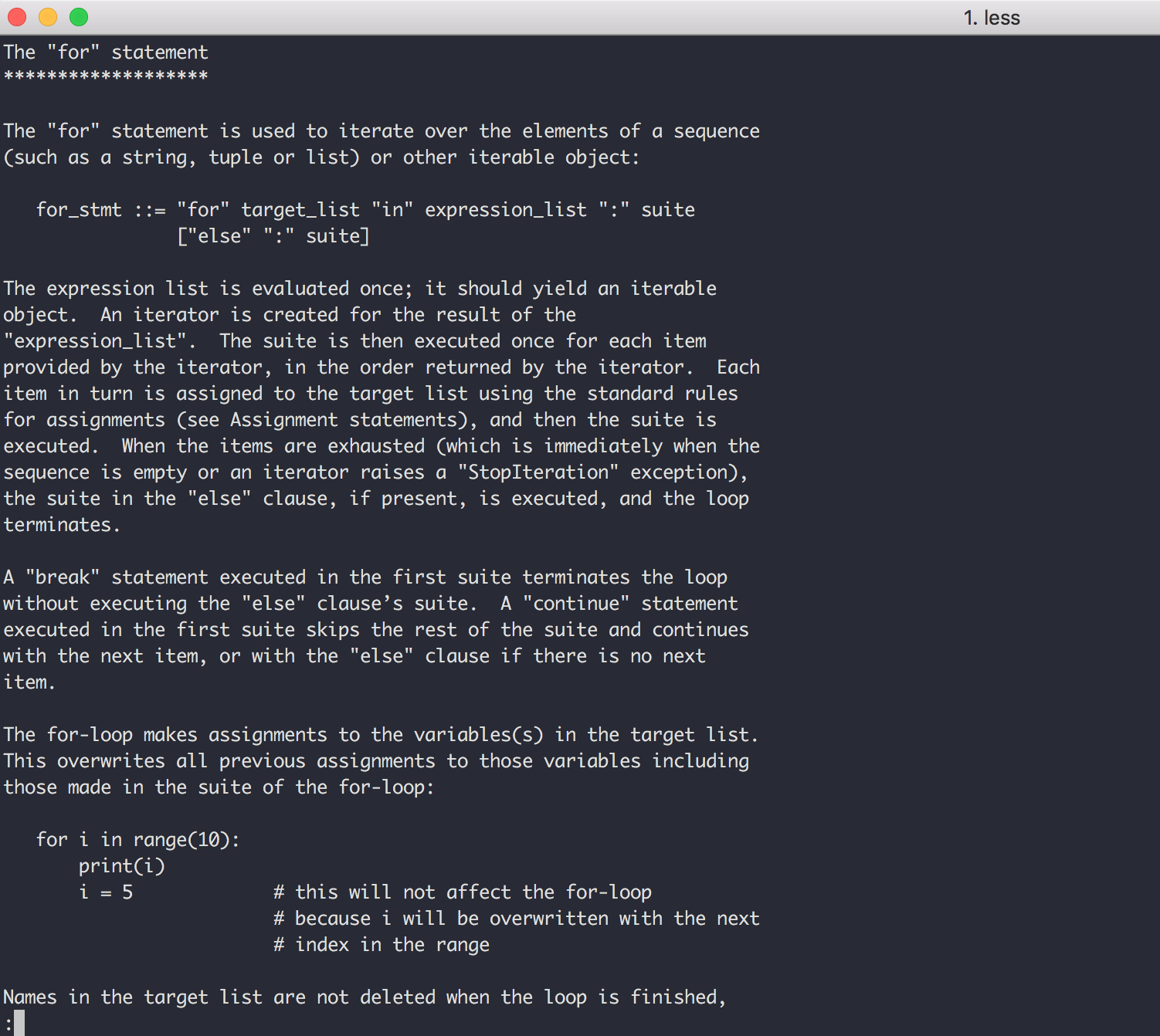

如果你想学习某个关键字的用法,可以在 help 模式下直接键入 关键字 查询用法,比如我直接键入 for 。

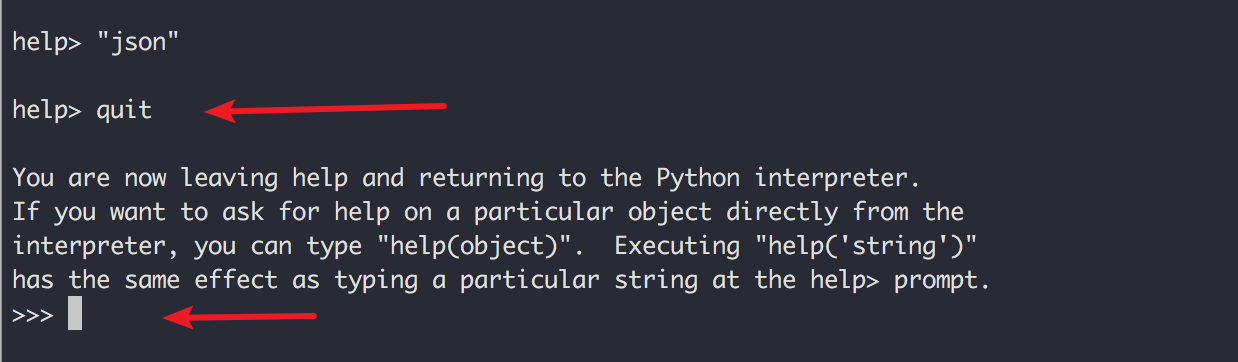

查完后,使用 quit 就可以退出 help 模式了。

如果你觉得进入 help 模式太麻烦,可以在 console 模式下直接查询

1 | |

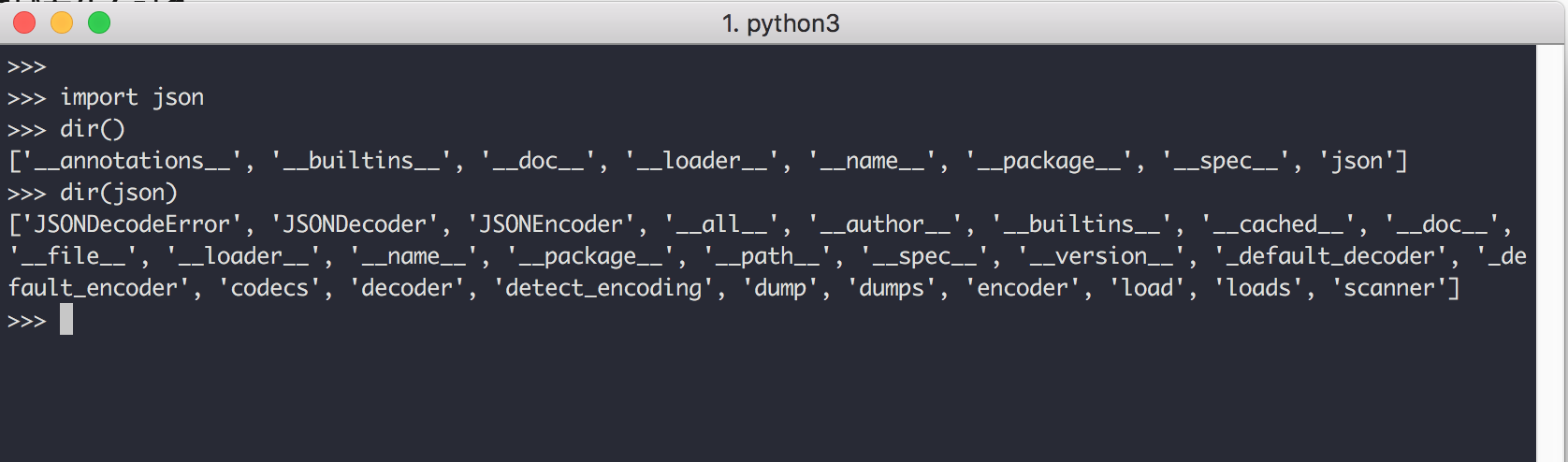

dir()

dir() 函数可能是 Python 自省机制中最著名的部分了。它返回传递给它的任何对象的属性名称经过排序的列表。如果不指定对象,则 dir() 返回当前作用域中的名称。让我们将 dir() 函数应用于 keyword 模块,并观察它揭示了什么:

2. 应用到实际开发中

type()

type() 函数有助于我们确定对象是字符串还是整数,或是其它类型的对象。它通过返回类型对象来做到这一点,可以将这个类型对象与 types 模块中定义的类型相比较:

1 | |

hasattr()

使用 dir() 函数会返回一个对象的属性列表。

但是,有时我们只想测试一个或多个属性是否存在。如果对象具有我们正在考虑的属性,那么通常希望只检索该属性。这个任务可以由 hasattr() 来完成.

1 | |

getattr()

使用 hasattr 获知了对象拥有某个属性后,可以搭配 getattr() 函数来获取其属性值。

1 | |

使用 getattr 获取函数后,可以很方便地使用这个函数,比如下面这样,可以不再使写 json.dumps 这么字。

1 | |

id()

id() 函数返回对象的唯一标识符,标识符是一个整数。

1 | |

isinstance()

使用 isinstance() 函数可以确定一个对象是否是某个特定类型或定制类的实例。

1 | |

callable()

使用 callable 可以确定一个对象是否是可调用的,比如函数,类这些对象都是可以调用的对象。

1 | |

3. 模块(Modules)

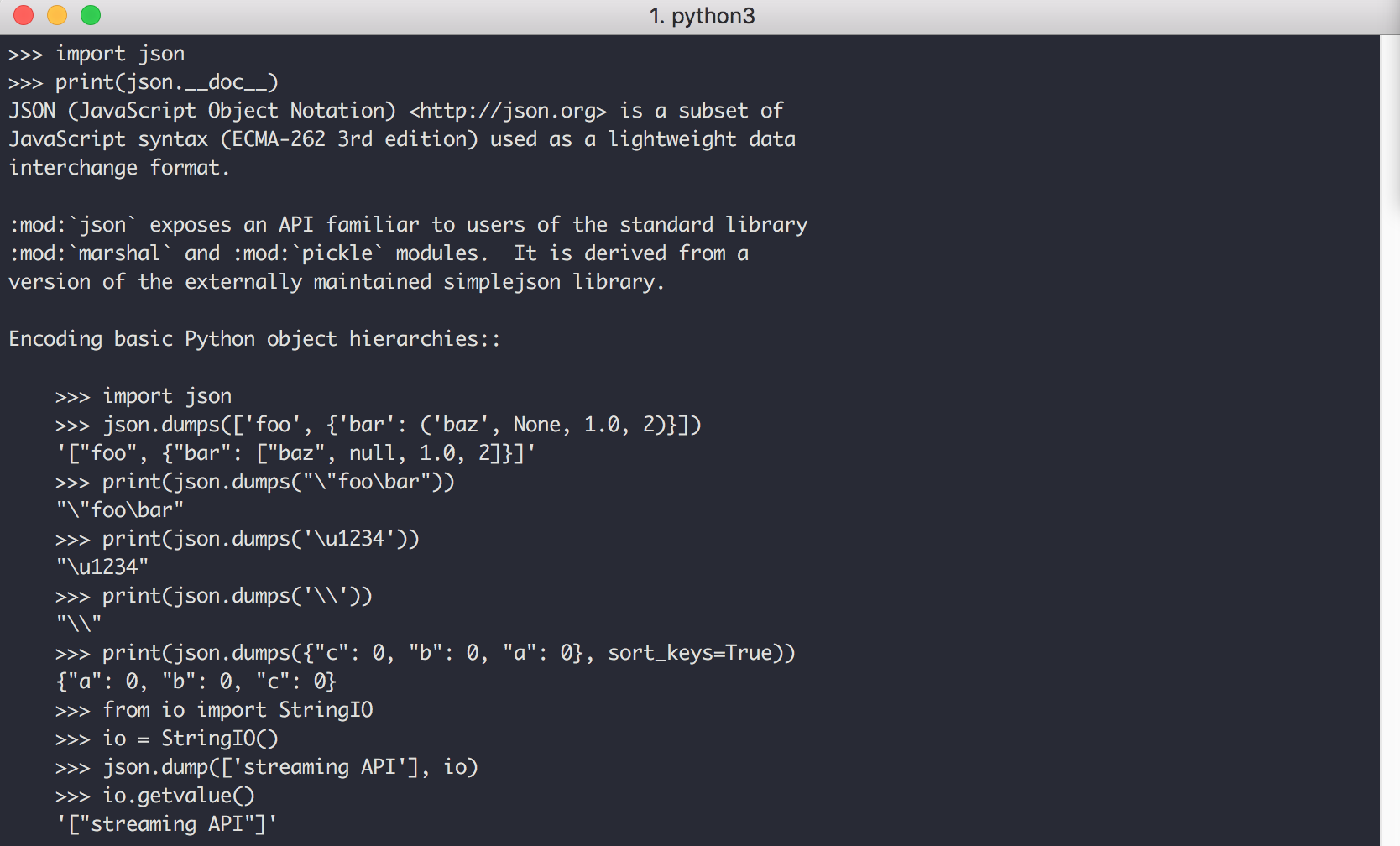

_doc_

使用 __doc__ 这个魔法方法,可以查询该模块的文档,它输出的内容和 help() 一样。

_name_

始终是定义时的模块名;即使你使用import .. as 为它取了别名,或是赋值给了另一个变量名。

1 | |

_file_

包含了该模块的文件路径。需要注意的是内建的模块没有这个属性,访问它会抛出异常!

1 | |

_dict_

包含了模块里可用的属性名-属性的字典;也就是可以使用模块名.属性名访问的对象。

4. 类(Class)

_doc_

文档字符串。如果类没有文档,这个值是None。

1 | |

_name_

始终是定义时的类名。

1 | |

_dict_

包含了类里可用的属性名-属性的字典;也就是可以使用类名.属性名访问的对象。

1 | |

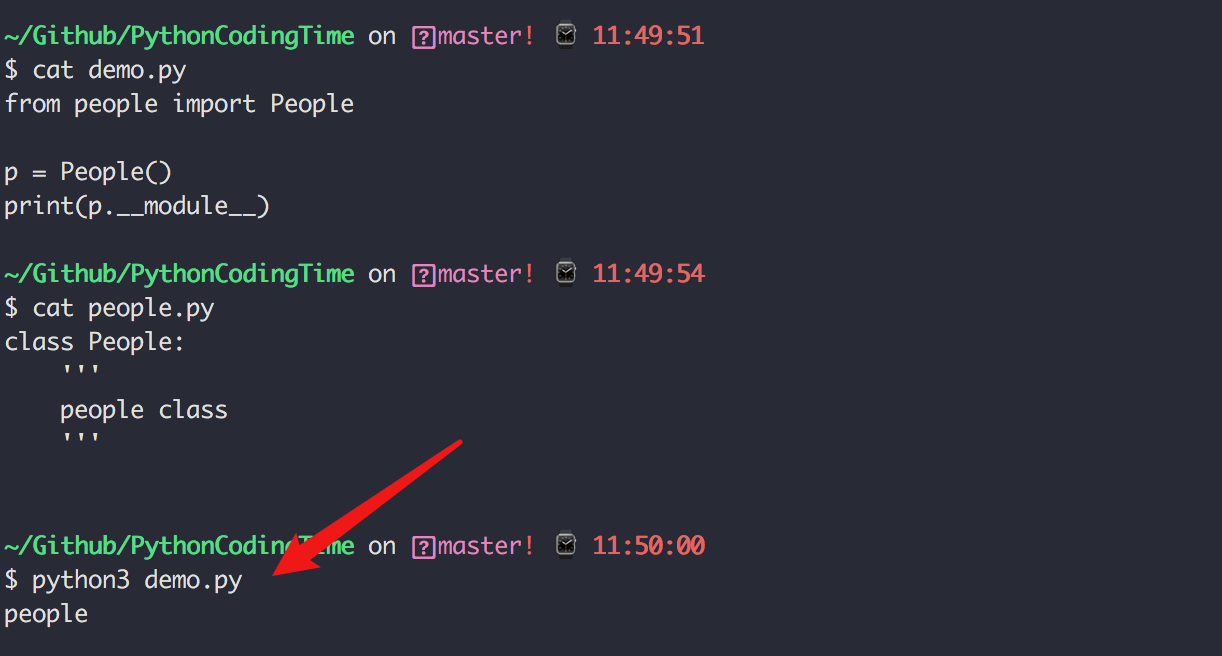

_module_

包含该类的定义的模块名;需要注意,是字符串形式的模块名而不是模块对象。

由于我是在 交互式命令行的环境下,所以模块是 __main__

1 | |

如果将上面的代码放入 demo.py,并且从 people 模块导入 People 类,其值就是 people 模块

_bases_

直接父类对象的元组;但不包含继承树更上层的其他类,比如父类的父类。

1 | |

5.6 【基础】偏函数的妙用

假如一个函数定义了多个位置参数,那你每次调用时,都需要把这些个参数一个一个地传递进去。

比如下面这个函数,是用来计算 x的n次方 的。

1 | |

那我每次计算 x 的 n 次方,都要传递两个参数

1 | |

后来我发现,我很多时候都是计算平方值,很多会去计算三次方,四次方。

那有什么办法可以偷个懒吗?

答案是,有。可以使用 偏函数。

偏函数(Partial Function),可以将某个函数的常用参数进行固定,避免每次调用时都要指定。

使用偏函数,需要导入 functools.partial ,然后利用它创建一个新函数,新函数的 n 固定等2。

具体使用请看下面的示例

1 | |

5.7 【进阶】泛型函数的使用

根据传入参数类型的不同而调用不同的函数逻辑体,这种实现我们称之为泛型。在 Python 中叫做 singledispatch。

singledispatch 是 PEP443 中引入的,如果你对此有兴趣,PEP443 应该是最好的学习文档:https://www.python.org/dev/peps/pep-0443/

它使用方法极其简单,只要被singledispatch 装饰的函数,就是一个single-dispatch 的泛函数(generic functions)。

- 单分派:根据一个参数的类型,以不同方式执行相同的操作的行为。

- 多分派:可根据多个参数的类型选择专门的函数的行为。

- 泛函数:多个函数绑在一起组合成一个泛函数。

这边举个简单的例子。

1 | |

执行结果

1 | |

说起泛型,其实在 Python 本身的一些内建函数中并不少见,比如 len() , iter(),copy.copy() ,pprint() 等

你可能会问,它有什么用呢?实际上真没什么用,你不用它或者不认识它也完全不影响你编码。

我这里举个例子,你可以感受一下。

大家都知道,Python 中有许许多的数据类型,比如 str,list, dict, tuple 等,不同数据类型的拼接方式各不相同,所以我这里我写了一个通用的函数,可以根据对应的数据类型对选择对应的拼接方式拼接,而且不同数据类型我还应该提示无法拼接。以下是简单的实现。

1 | |

输出结果如下

1 | |

如果不使用singledispatch 的话,你可能会写出这样的代码。

1 | |

输出如下

1 | |

5.8 【基础】变量的作用域

1. 作用域

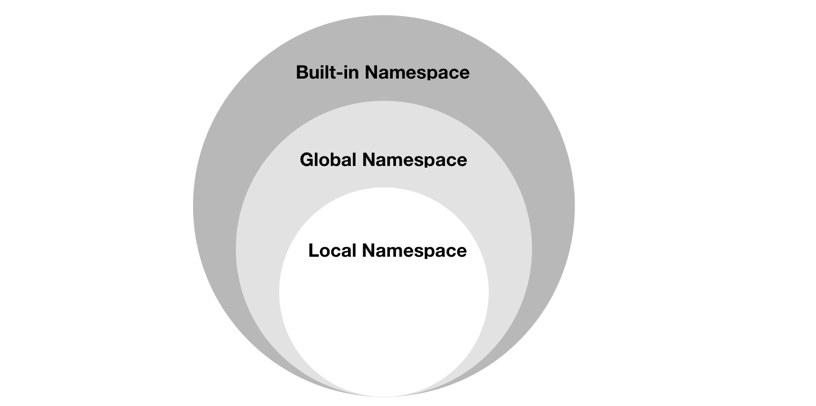

Python的作用域可以分为四种:

- L (Local) 局部作用域

- E (Enclosing) 闭包函数外的函数中

- G (Global) 全局作用域

- B (Built-in) 内建作用域

变量/函数 的查找顺序:

L –> E –> G –>B

意思是,在局部找不到的,便去局部外的局部作用域找(例如 闭包),再找不到的就去全局作业域里找,再找不到就去内建作业域中找。

会影响 变量/函数 作用范围的有

- 函数:def 或 lambda

- 类:class

- 关键字:global noglobal

- 文件:*py

- 推导式:[],{},()等,仅限Py3.x中,Py2.x会出现变量泄露。

1、赋值在前,引用在后

1 | |

2、引用在前,赋值在后(同一作用域内)

1 | |

3、赋值在低层,引用在高层

1 | |

2. 闭包

闭包这个概念很重要噢。你一定要掌握。

在一个外函数中定义了一个内函数,内函数里运用了外函数的临时变量,并且外函数的返回值是内函数的引用。这样就构成了一个闭包。其实装饰函数,很多都是闭包。

好像并不难理解,为什么初学者会觉得闭包难以理解呢?

我解释一下,你就明白了。

一般情况下,在我们认知当中,如果一个函数结束,函数的内部所有东西都会释放掉,还给内存,局部变量都会消失。但是闭包是一种特殊情况,如果外函数在结束的时候发现有自己的临时变量将来会在内部函数中用到,就把这个临时变量绑定给了内部函数,然后自己再结束。

你可以看下面这段代码,就构成了闭包。在内函数里可以引用外函数的变量。

1 | |

3. 改变作用域

变量的作用域,与其定义(或赋值)的位置有关,但不是绝对相关。

因为我们可以在某种程度上去改变向上的作用范围。

关键字:global

将 局部变量 变为全局变量关键字:nonlocal

可以在闭包函数中,引用并使用闭包外部函数的变量(非全局的噢)

global好理解,这里只讲下nonlocal。

先来看个例子

1 | |

运行一下,会报错。

1 | |

但是这样就OK

1 | |

其实,你如果不使用 +=、-=等一类的操作,不加nonlocal也没有关系。这就展示了闭包的特性。

1 | |

4. 变量集合

在Python中,有两个内建函数,你可能用不到,但是需要掌握它们。

- globals() :以dict的方式存储所有全局变量

- locals():以dict的方式存储所有局部变量

globals()

1 | |

locals()

1 | |

5.9 【进阶】上下文管理器

当你准备从一个文件中读取内容时,通常来说,都是这么写的。

1 | |

上面这种方法,需要你手动关闭文件句柄,但是很多时候,程序员是会忘记这一操作的。

因为推荐你使用下面这种方法,使用 with 这个关键字,可以在文件读取结束后,自动关闭文件句柄。

1 | |

使用 Python 的专业术语来说,with 的这个用法叫做 上下文管理器。

1. 什么是上下文管理器?

基本语法

1 | |

从上面这个语法中,先理清几个概念:

- 上下文表达式:

with open('test.txt') as file: - 上下文管理器:

open('test.txt') file不是上下文管理器,应该是资源对象。

2. 如何写上下文管理器?

要手动实现一个上下文管理器,需要你有对类有一些了解,至少需要知道什么是类,怎么定义类。对于类的知识,我放在了第七章,因此你可以先前往学习下第七章的的第一节内容:7.1 类的理解与使用 。

学习了类的基本知识,想要自己实现这样一个上下文管理,就简单了。

你只要在一个类里实现上下文管理协议,简单点说,就是在一个类里,定义了__enter__和__exit__的方法,这个类的实例就是一个上下文管理器。

例如这个示例:

1 | |

我们执行一下,通过日志的打印顺序。可以知道其执行过程。

1 | |

从这个示例可以很明显的看出,在编写代码时,可以将资源的连接或者获取放在__enter__中,而将资源的关闭写在__exit__ 中。

3. 为什么需要上下文管理器?

学习时多问自己几个为什么,养成对一些细节的思考,有助于加深对知识点的理解。

为什么要使用上下文管理器?

在我看来,这和 Python 崇尚的优雅风格有关。

- 可以以一种更加优雅的方式,操作(创建/获取/释放)资源,如文件操作、数据库连接;

- 可以以一种更加优雅的方式,处理异常;

第一种,我们上面已经以资源的连接为例讲过了。

而第二种,会被大多数人所忽略。这里会重点讲一下。

大家都知道,处理异常,通常都是使用 try...execept.. 来捕获处理的。这样做一个不好的地方是,在代码的主逻辑里,会有大量的异常处理代理,这会很大的影响我们的可读性。

好一点的做法呢,可以使用 with 将异常的处理隐藏起来。

仍然是以上面的代码为例,我们将1/0 这个一定会抛出异常的代码写在 operate 里

1 | |

运行一下,惊奇地发现,居然不会报错。

这就是上下文管理协议的一个强大之处,异常可以在__exit__ 进行捕获并由你自己决定如何处理,是抛出呢还是在这里就解决了。在__exit__ 里返回 True(没有return 就默认为 return False),就相当于告诉 Python解释器,这个异常我们已经捕获了,不需要再往外抛了。

在 写__exit__ 函数时,需要注意的事,它必须要有这三个参数:

- exc_type:异常类型

- exc_val:异常值

- exc_tb:异常的错误栈信息

当主逻辑代码没有报异常时,这三个参数将都为None。

4. 学会使用 contextlib

在上面的例子中,我们只是为了构建一个上下文管理器,却写了一个类。如果只是要实现一个简单的功能,写一个类未免有点过于繁杂。这时候,我们就想,如果只写一个函数就可以实现上下文管理器就好了。

这个点Python早就想到了。它给我们提供了一个装饰器,你只要按照它的代码协议来实现函数内容,就可以将这个函数对象变成一个上下文管理器。

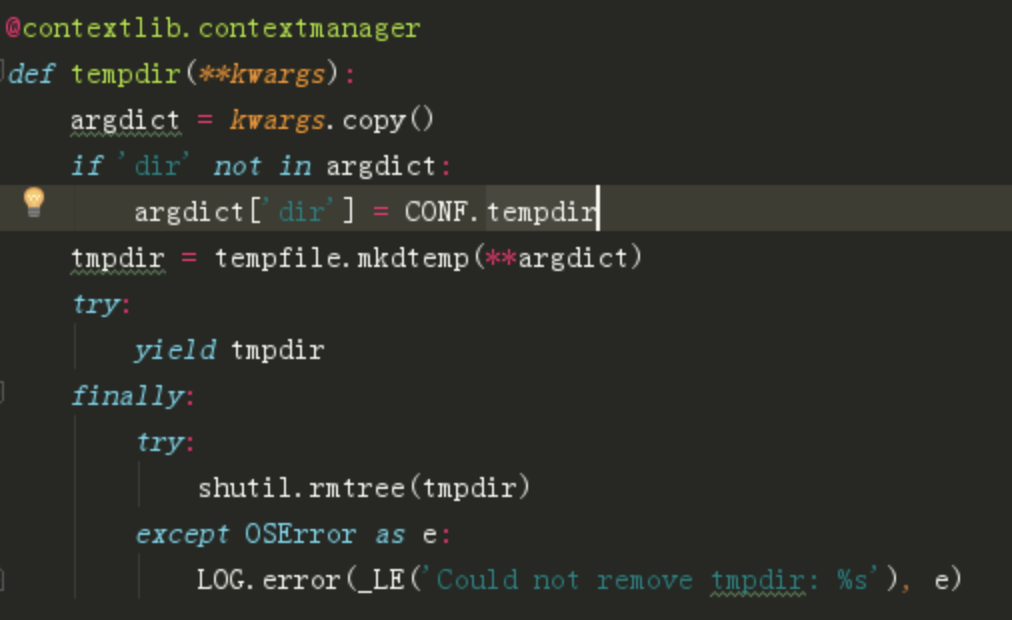

我们按照 contextlib 的协议来自己实现一个打开文件(with open)的上下文管理器。

1 | |

在被装饰函数里,必须是一个生成器(带有yield),而yield之前的代码,就相当于__enter__里的内容。yield 之后的代码,就相当于__exit__ 里的内容。

上面这段代码只能实现上下文管理器的第一个目的(管理资源),并不能实现第二个目的(处理异常)。

如果要处理异常,可以改成下面这个样子。

1 | |

好像只要讲到上下文管理器,大多数人都会谈到打开文件这个经典的例子。

但是在实际开发中,可以使用到上下文管理器的例子也不少。我这边举个我自己的例子。

在OpenStack中,给一个虚拟机创建快照时,需要先创建一个临时文件夹,来存放这个本地快照镜像,等到本地快照镜像创建完成后,再将这个镜像上传到Glance。然后删除这个临时目录。

这段代码的主逻辑是创建快照,而创建临时目录 ,属于前置条件,删除临时目录,是收尾工作。

虽然代码量很少,逻辑也不复杂,但是“创建临时目录,使用完后再删除临时目录”这个功能,在一个项目中很多地方都需要用到,如果可以将这段逻辑处理写成一个工具函数作为一个上下文管理器,那代码的复用率也大大提高。

代码是这样的

5. 总结起来

使用上下文管理器有三个好处:

- 提高代码的复用率;

- 提高代码的优雅度;

- 提高代码的可读性;

5.10 【进阶】装饰器的六种写法

Hello,装饰器

装饰器本质上是一个Python函数,它可以让其他函数在不需要做任何代码变动的前提下增加额外功能,装饰器的返回值也是一个函数对象。

它经常用于有切面需求的场景,比如:插入日志、性能测试、事务处理、缓存、权限校验等场景。

装饰器是解决这类问题的绝佳设计,有了装饰器,我们就可以抽离出大量与函数功能本身无关的雷同代码并继续重用。

装饰器的使用方法很固定

- 先定义一个装饰器(帽子)

- 再定义你的业务函数或者类(人)

- 最后把这装饰器(帽子)扣在这个函数(人)头上

就像下面这样子

1 | |

实际上,装饰器并不是编码必须性,意思就是说,你不使用装饰器完全可以,它的出现,应该是使我们的代码

- 更加优雅,代码结构更加清晰

- 将实现特定的功能代码封装成装饰器,提高代码复用率,增强代码可读性

接下来,我将以实例讲解,如何编写出各种简单及复杂的装饰器。

第一种:普通装饰器

首先咱来写一个最普通的装饰器,它实现的功能是:

- 在函数执行前,先记录一行日志

- 在函数执行完,再记录一行日志

1 | |

假如,我的业务函数是,计算两个数之和。写好后,直接给它带上帽子。

1 | |

然后执行一下 add 函数。

1 | |

来看看输出了什么?

1 | |

第二种:带参数的函数装饰器

通过上面两个简单的入门示例,你应该能体会到装饰器的工作原理了。

不过,装饰器的用法还远不止如此,深究下去,还大有文章。今天就一起来把这个知识点学透。

回过头去看看上面的例子,装饰器是不能接收参数的。其用法,只能适用于一些简单的场景。不传参的装饰器,只能对被装饰函数,执行固定逻辑。

装饰器本身是一个函数,做为一个函数,如果不能传参,那这个函数的功能就会很受限,只能执行固定的逻辑。这意味着,如果装饰器的逻辑代码的执行需要根据不同场景进行调整,若不能传参的话,我们就要写两个装饰器,这显然是不合理的。

比如我们要实现一个可以定时发送邮件的任务(一分钟发送一封),定时进行时间同步的任务(一天同步一次),就可以自己实现一个 periodic_task (定时任务)的装饰器,这个装饰器可以接收一个时间间隔的参数,间隔多长时间执行一次任务。

可以这样像下面这样写,由于这个功能代码比较复杂,不利于学习,这里就不贴了。

1 | |

那我们来自己创造一个伪场景,可以在装饰器里传入一个参数,指明国籍,并在函数执行前,用自己国家的母语打一个招呼。

1 | |

那我们如果实现这个装饰器,让其可以实现 传参 呢?

会比较复杂,需要两层嵌套。

1 | |

来执行一下

1 | |

看看输出结果。

1 | |

第三种:不带参数的类装饰器

以上都是基于函数实现的装饰器,在阅读别人代码时,还可以时常发现还有基于类实现的装饰器。

基于类装饰器的实现,必须实现 __call__ 和 __init__两个内置函数。__init__ :接收被装饰函数__call__ :实现装饰逻辑。

还是以日志打印这个简单的例子为例

1 | |

执行一下,看看输出

1 | |

第四种:带参数的类装饰器

上面不带参数的例子,你发现没有,只能打印INFO级别的日志,正常情况下,我们还需要打印DEBUG WARNING等级别的日志。 这就需要给类装饰器传入参数,给这个函数指定级别了。

带参数和不带参数的类装饰器有很大的不同。

__init__ :不再接收被装饰函数,而是接收传入参数。__call__ :接收被装饰函数,实现装饰逻辑。

1 | |

我们指定WARNING级别,运行一下,来看看输出。

1 | |

第五种:使用偏函数与类实现装饰器

绝大多数装饰器都是基于函数和闭包实现的,但这并非制造装饰器的唯一方式。

事实上,Python 对某个对象是否能通过装饰器( @decorator)形式使用只有一个要求:decorator 必须是一个“可被调用(callable)的对象。

对于这个 callable 对象,我们最熟悉的就是函数了。

除函数之外,类也可以是 callable 对象,只要实现了__call__ 函数(上面几个例子已经接触过了)。

还有容易被人忽略的偏函数其实也是 callable 对象。

接下来就来说说,如何使用 类和偏函数结合实现一个与众不同的装饰器。

如下所示,DelayFunc 是一个实现了 __call__ 的类,delay 返回一个偏函数,在这里 delay 就可以做为一个装饰器。(以下代码摘自 Python工匠:使用装饰器的小技巧)

1 | |

我们的业务函数很简单,就是相加

1 | |

来看一下执行过程

1 | |

第六种:能装饰类的装饰器

用 Python 写单例模式的时候,常用的有三种写法。其中一种,是用装饰器来实现的。

以下便是我自己写的装饰器版的单例写法。

1 | |

可以看到我们用singleton 这个装饰函数来装饰 User 这个类。装饰器用在类上,并不是很常见,但只要熟悉装饰器的实现过程,就不难以实现对类的装饰。在上面这个例子中,装饰器就只是实现对类实例的生成的控制而已。

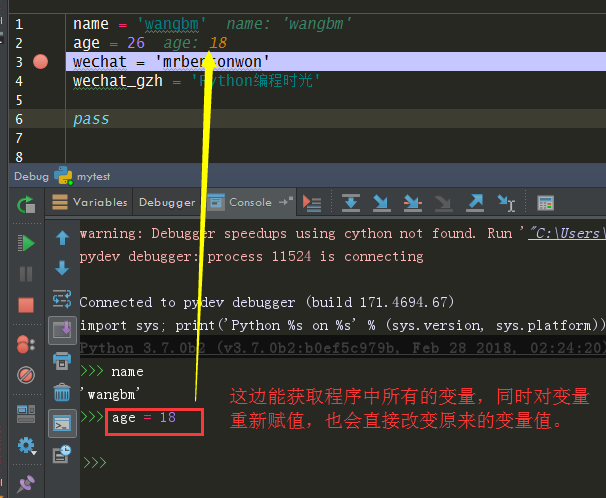

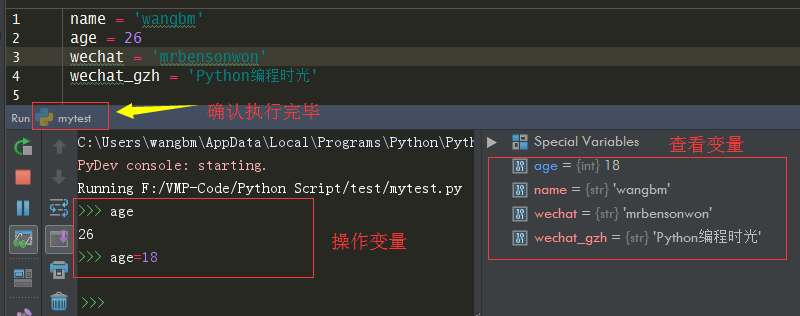

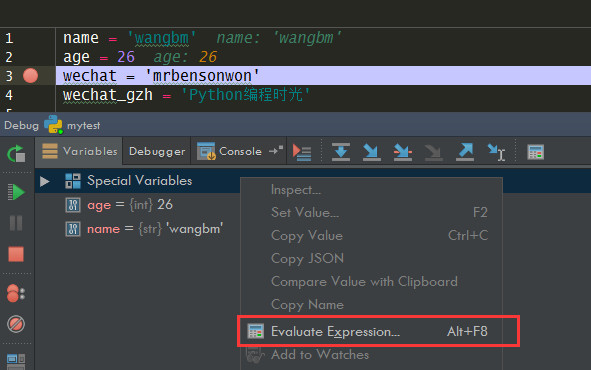

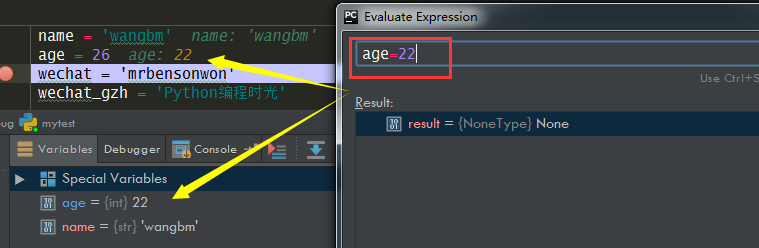

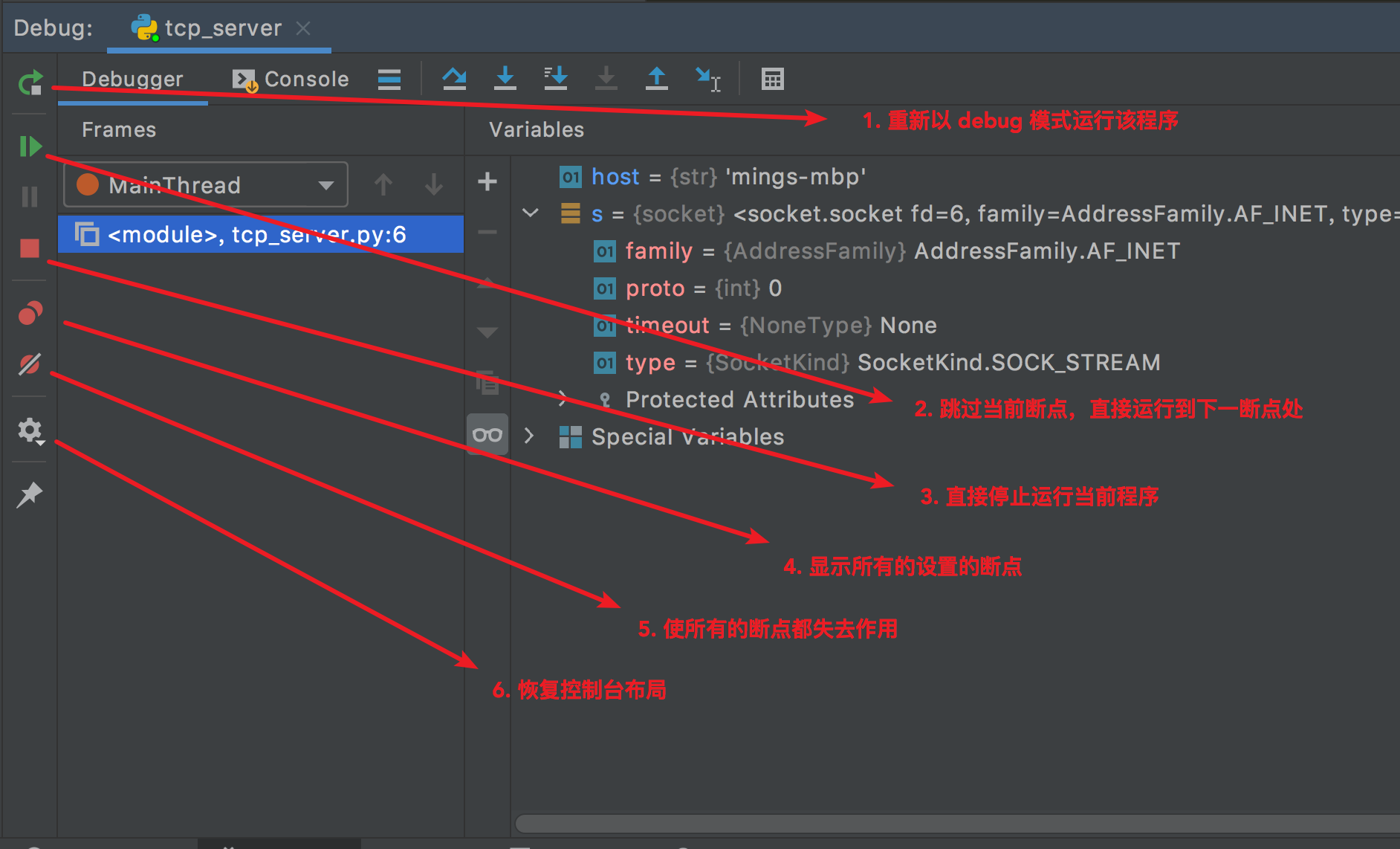

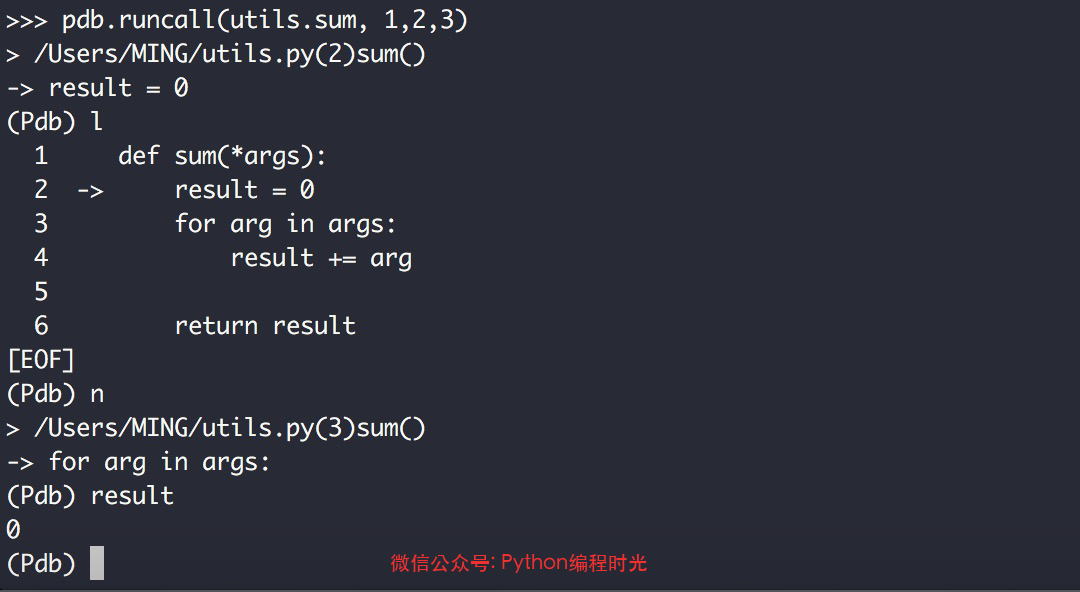

其实例化的过程,你可以参考我这里的调试过程,加以理解。

第六章:错误异常

6.1 【基础】什么是异常?

在程序运行过程中,总会遇到各种各样的问题和错误。

有些错误是我们编写代码时自己造成的,比如语法错误、调用错误,甚至逻辑错误。下面这个例子,在输入 if 后输入回车了,没有按照 Python 的语法规则来,所以直接抛出了语法错误。

1

2

3

4

5>>> if

File "<stdin>", line 1

if

^

SyntaxError: invalid syntax还有一些错误,则是不可预料的错误,但是完全有可能发生的,比如文件不存在、磁盘空间不足、网络堵塞、系统错误等等。下面这个例子,使用 open 函数打开

demo.txt文件,可是在当前目录下并没有这个文件,所以一定会打开失败,抛出了IOError。1

2

3

4>>> fp = open('demo.txt')

Traceback (most recent call last):

File "<stdin>", line 1, in <module>

IOError: [Errno 2] No such file or directory: 'demo.txt'

这些导致程序在运行过程中出现异常中断和退出的错误,我们统称为异常。正常情况下,异常都不会被程序处理,而是以错误信息的形式展现出来。

异常有很多种类型,Python内置了几十种常见的异常,就在builtins模块内,它们无需特别导入,就可以直接使用。需要注意的是,所有的异常都是异常类,首字母是大写的!

在发生异常的时候,Python会打印出异常信息,信息的前面部分显示了异常发生的上下文环境,并以调用栈的形式显示具体信息。异常类型作为信息的一部分也会被打印出来,例如ZeroDivisionError,TypeError。

1 | |

正常情况下,我们都不需要去记住 Python 到底内置了哪些错误和异常类型,除非你需要去捕获它,关于捕获的内容,我会放在下一节。这一节先来认识一下 Python 中有哪些常见的错误和异常,对于新手,下面的内容大概过一下就好,不用深究,因为这些在你以后的编码中都会遇到的。

1.SyntaxError

SyntaxError,是语法错误,可能是新手在学习 Python 时最容易遇到的错误

1 | |

解析器会输出出现语法错误的那一行,并显示一个“箭头”,指向这行里面检测到的第一个错误。 错误是由箭头指示的位置 上面 的 token 引起的(或者至少是在这里被检测出的):在示例中,在 print() 这个函数中检测到了错误,因为在它前面少了个冒号 (':') 。文件名和行号也会被输出,以便输入来自脚本文件时你能知道去哪检查。

2、TypeError

TypeError,是类型错误,也就是说将某个操作或功能应用于不合适类型的对象时引发,比如整型与字符型进行加减法

1 | |

3、IndexError

IndexError,是指索引出现了错误,比如最常见下标索引超出了序列边界

1 | |

4、KeyError

KeyError是关键字错误,这个异常主要发生在字典中,比如当用户试图访问一个字典中不存在的键时会被引发。

1 | |

5、ValueError

ValueError为值错误,当用户传入一个调用者不期望的值时会引发,即使这个值的类型是正确的,比如想获取一个列表中某个不存在值的索引。

1 | |

6、AttributeError

AttributeError是属性错误,当用户试图访问一个对象不存在的属性时会引发。

比如字典有get方法,而列表却没有,所以对一个列表对象调用该方法就会引发该异常。

1 | |

7、NameError

NameError是指变量名称发生错误,比如用户试图调用一个还未被赋值或初始化的变量时会被触发。

1 | |

8、IOError

IOError 为打开文件错误,当用户试图以读取方式打开一个不存在的文件时引发。

1 | |

9、StopIteration

StopIteration为迭代器错误,当访问至迭代器最后一个值时仍然继续访问,就会引发这种异常,提醒用户迭代器中已经没有值可供访问了。

1 | |

10、AssertionError

AssertionError 为断言错误,当用户利用断言语句检测异常时,如果断言语句检测的表达式为假,则会引发这种异常。

1 | |

11. IndentationError

Python 是一门严格缩进的语言,如果缩进有问题,就会导致解释器解析异常,抛出 IndentationError

1 | |

12. ImportError

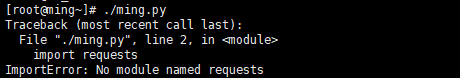

当你在使用 import 导包的时候,如果因为包名错误或者路径不对、包未安装,都会抛出 ImportError

1 | |

上面这些异常应该是平时编程中遇见频率比较高的一部分,还有更多的异常,可以前往官方文档:https://docs.python.org/3/library/exceptions.html## 6.2 【基础】如何抛出和捕获异常?

1. 如何抛出异常?

异常的产生有两种来源:

- 一种是程序自动抛出,比如

1/0会自动抛出 ZeroDivisionError - 一种是开发者主动抛出,使用

raise关键字抛出。

在 Python 中是使用 raise 关键字来抛出异常的,比如在下面这个函数中,如果不存在目标文件,则会抛出一个 Exception 通用异常。

1 | |

2. 如何捕获异常?

出现错误或者异常没有关系,关键在于你要学会预判程序可能会出现的错误或异常,然后在代码中捕获这些异常并处理。

异常的捕获的语法有如下四种:

第一种语法

只捕捉但是不想获取异常信息

1 | |

第二种语法

不但捕捉了还要获取异常信息,赋值给 e 后,后面你可以把异常信息打印到日志中。

1 | |

有了上面的基础语法,可以扩展出下面三种常用的异常捕获的写法。

第三种语法

正常使用 try ... except ...

如果代码A发生了异常,则会走到代码B的逻辑。

1 | |

举个例子

1 | |

第四种语法

使用 try ... except ... else

如果代码A发生了异常,则会走到代码B的逻辑,如果没有发生异常,则会走到代码C

1 | |

举个例子

不发生异常的情况

1 | |

发生异常的情况

1 | |

- 第三种:使用

try ... except ... finally

如果代码A发生了异常,则会走到代码B的逻辑,最后不管有没有发生异常都会走到代码C

1 | |

举个例子

发生异常的情况

1 | |

不发生异常的情况

1 | |

3. 捕获多个异常?

每个except捕获一个异常

一个 try 语句可能有多个 except 子句,以指定不同异常的处理程序,但是最多会执行一个处理程序。

当代码 A 在运行中抛出了异常时,Python 解释器会逐行运行代码,如果抛出的异常是 exception1 那么后面直接运行代码B,运行完 B 后,就不会再判断后面两个 except 语句了。

而如果不是 exception1 ,而是 exception2 ,那会运行代码C,而不会再运行第三个 except 语句了。

1 | |

举个例子吧,下面这段代码,由于 1/0 会抛出 ZeroDivisionError 错误,所以前面两个异常匹配都不成功,而在最后一个 except 成功匹配上,最终打印出 除数不能为 0

1 | |

一个except捕获多个异常

上面的例子可以看出来,第二个异常和第三个异常是属于同一类,就是 计算错误,异常处理的代码是一样的,那有没有办法将它们合并在一起呢,简化一下代码呢?

答案是,可以的。

在 except 后面其实是可以接多个异常的,多个异常之间使用括号包裹。只要匹配上一个就算捕获到,就会进入相应的代码分支。

1 | |

6.3 【基础】如何自定义异常?

大多数情况下,内置的错误和异常已经够用了,但是有时候你还是需要自定义一些异常。

自定义异常,需要你对 类 与 继承 有一些了解,对于类的知识,我放在了第七章,因此你可以先前往学习下第七章的的下面两节内容:

等学习完后再回过头来学习本节内容。

自定义异常应该继承 Exception 类,直接继承或者间接继承都可以,自定义的异常或错误类,下面使用 InputError ,表示接受用户输入时发生问题。

1 | |

异常的名字都以Error结尾,我们在为自定义异常命名的时候也需要遵守这一规范,就跟标准的异常命名一样。

定义完后,再看如下代码,我在 try 里调用 get_input 函数,如果发现用户没有输入内容,就使用 raise 关键字来抛出 InputError。

1 | |

6.4 【进阶】如何关闭异常自动关联上下文?

当你在处理异常时,由于处理不当或者其他问题,再次抛出另一个异常时,往外抛出的异常也会携带原始的异常信息。

就像这样子。

1 | |

从输出可以看到两个异常信息

1 | |

如果在异常处理程序或 finally 块中引发异常,默认情况下,异常机制会隐式工作会将先前的异常附加为新异常的 __context__属性。这就是 Python 默认开启的自动关联异常上下文。

如果你想自己控制这个上下文,可以加个 from 关键字(from 语法会有个限制,就是第二个表达式必须是另一个异常类或实例。),来表明你的新异常是直接由哪个异常引起的。

1 | |

输出如下

1 | |

当然,你也可以通过with_traceback()方法为异常设置上下文__context__属性,这也能在traceback更好的显示异常信息。

1 | |

最后,如果我想彻底关闭这个自动关联异常上下文的机制?有什么办法呢?

可以使用 raise...from None,从下面的例子上看,已经没有了原始异常

1 | |

6.5 【进阶】异常处理的三个好习惯

本文作者:piglei

本文来源:https://github.com/piglei/one-python-craftsman

如果你用 Python 编程,那么你就无法避开异常,因为异常在这门语言里无处不在。打个比方,当你在脚本执行时按 ctrl+c 退出,解释器就会产生一个 KeyboardInterrupt 异常。而 KeyError、ValueError、TypeError 等更是日常编程里随处可见的老朋友。

异常处理工作由“捕获”和“抛出”两部分组成。“捕获”指的是使用 try ... except 包裹特定语句,妥当的完成错误流程处理。而恰当的使用 raise 主动“抛出”异常,更是优雅代码里必不可少的组成部分。

在这篇文章里,我会分享与异常处理相关的 3 个好习惯。继续阅读前,我希望你已经了解了下面这些知识点:

- 异常的基本语法与用法(建议阅读官方文档 “Errors and Exceptions”)

- 为什么要使用异常代替错误返回(建议阅读《让函数返回结果的技巧》)

- 为什么在写 Python 时鼓励使用异常 (建议阅读 “Write Cleaner Python: Use Exceptions”)

1. 只做最精确的异常捕获

假如你不够了解异常机制,就难免会对它有一种天然恐惧感。你可能会觉得:异常是一种不好的东西,好的程序就应该捕获所有的异常,让一切都平平稳稳的运行。而抱着这种想法写出的代码,里面通常会出现大段含糊的异常捕获逻辑。

让我们用一段可执行脚本作为样例:

1 | |

脚本里的 save_website_title 函数做了好几件事情。它首先通过网络获取网页内容,然后利用正则匹配出标题,最后将标题写在本地文件里。而这里有两个步骤很容易出错:网络请求 与 本地文件操作。所以在代码里,我们用一个大大的 try ... except 语句块,将这几个步骤都包裹了起来。安全第一 ⛑。

那么,这段看上去简洁易懂的代码,里面藏着什么问题呢?

如果你旁边刚好有一台安装了 Python 的电脑,那么你可以试着跑一遍上面的脚本。你会发现,上面的代码是不能成功执行的。而且你还会发现,无论你如何修改网址和目标文件的值,程序仍然会报错 “save failed: unable to…”。为什么呢?

问题就藏在这个硕大无比的 try ... except 语句块里。假如你把眼睛贴近屏幕,非常仔细的检查这段代码。你会发现在编写函数时,我犯了一个小错误,我把获取正则匹配串的方法错打成了 obj.grop(1),少了一个 ‘u’(obj.group(1))。

但正是因为那个过于庞大、含糊的异常捕获,这个由打错方法名导致的原本该被抛出的 AttibuteError 却被吞噬了。从而给我们的 debug 过程增加了不必要的麻烦。

异常捕获的目的,不是去捕获尽可能多的异常。假如我们从一开始就坚持:只做最精准的异常捕获。那么这样的问题就根本不会发生,精准捕获包括:

- 永远只捕获那些可能会抛出异常的语句块

- 尽量只捕获精确的异常类型,而不是模糊的

Exception

依照这个原则,我们的样例应该被改成这样:

1 | |

2. 别让异常破坏抽象一致性

大约四五年前,当时的我正在开发某移动应用的后端 API 项目。如果你也有过开发后端 API 的经验,那么你一定知道,这样的系统都需要制定一套“API 错误码规范”,来为客户端处理调用错误时提供方便。

一个错误码返回大概长这个样子:

1 | |

在制定好错误码规范后,接下来的任务就是如何实现它。当时的项目使用了 Django 框架,而 Django 的错误页面正是使用了异常机制实现的。打个比方,如果你想让一个请求返回 404 状态码,那么只要在该请求处理过程中执行 raise Http404 即可。

所以,我们很自然的从 Django 获得了灵感。首先,我们在项目内定义了错误码异常类:APIErrorCode。然后依据“错误码规范”,写了很多继承该类的错误码。当需要返回错误信息给用户时,只需要做一次 raise 就能搞定。

1 | |

毫无意外,所有人都很喜欢用这种方式来返回错误码。因为它用起来非常方便,无论调用栈多深,只要你想给用户返回错误码,调用 raise error_codes.ANY_THING 就好。

随着时间推移,项目也变得越来越庞大,抛出 APIErrorCode 的地方也越来越多。有一天,我正准备复用一个底层图片处理函数时,突然碰到了一个问题。

我看到了一段让我非常纠结的代码:

1 | |

process_image 函数会尝试解析一个文件对象,如果该对象不能被作为图片正常打开,就抛出 error_codes.INVALID_IMAGE_UPLOADED (APIErrorCode 子类) 异常,从而给调用方返回错误代码 JSON。

让我给你从头理理这段代码。最初编写 process_image 时,我虽然把它放在了 util.image 模块里,但当时调这个函数的地方就只有 “处理用户上传图片的 POST 请求” 而已。为了偷懒,我让函数直接抛出 APIErrorCode 异常来完成了错误处理工作。

再来说当时的问题。那时我需要写一个在后台运行的批处理图片脚本,而它刚好可以复用 process_image 函数所实现的功能。但这时不对劲的事情出现了,如果我想复用该函数,那么:

- 我必须去捕获一个名为

INVALID_IMAGE_UPLOADED的异常- 哪怕我的图片根本就不是来自于用户上传

- 我必须引入

APIErrorCode异常类作为依赖来捕获异常- 哪怕我的脚本和 Django API 根本没有任何关系

这就是异常类抽象层级不一致导致的结果。APIErrorCode 异常类的意义,在于表达一种能够直接被终端用户(人)识别并消费的“错误代码”。它在整个项目里,属于最高层的抽象之一。但是出于方便,我们却在底层模块里引入并抛出了它。这打破了 image.processor 模块的抽象一致性,影响了它的可复用性和可维护性。

这类情况属于“模块抛出了高于所属抽象层级的异常”。避免这类错误需要注意以下几点:

- 让模块只抛出与当前抽象层级一致的异常

- 比如

image.processer模块应该抛出自己封装的ImageOpenError异常

- 比如

- 在必要的地方进行异常包装与转换

- 比如,应该在贴近高层抽象(视图 View 函数)的地方,将图像处理模块的

ImageOpenError低级异常包装转换为APIErrorCode高级异常

- 比如,应该在贴近高层抽象(视图 View 函数)的地方,将图像处理模块的

修改后的代码:

1 | |

除了应该避免抛出高于当前抽象级别的异常外,我们同样应该避免泄露低于当前抽象级别的异常。

如果你用过 requests 模块,你可能已经发现它请求页面出错时所抛出的异常,并不是它在底层所使用的 urllib3 模块的原始异常,而是通过 requests.exceptions 包装过一次的异常。

1 | |

这样做同样是为了保证异常类的抽象一致性。因为 urllib3 模块是 requests 模块依赖的底层实现细节,而这个细节有可能在未来版本发生变动。所以必须对它抛出的异常进行恰当的包装,避免未来的底层变更对 requests 用户端错误处理逻辑产生影响。

3. 异常处理不应该喧宾夺主

在前面我们提到异常捕获要精准、抽象级别要一致。但在现实世界中,如果你严格遵循这些流程,那么很有可能会碰上另外一个问题:异常处理逻辑太多,以至于扰乱了代码核心逻辑。具体表现就是,代码里充斥着大量的 try、except、raise 语句,让核心逻辑变得难以辨识。

让我们看一段例子:

1 | |

这是一个处理用户上传头像的视图函数。这个函数内做了三件事情,并且针对每件事都做了异常捕获。如果做某件事时发生了异常,就返回对用户友好的错误到前端。

这样的处理流程纵然合理,但是显然代码里的异常处理逻辑有点“喧宾夺主”了。一眼看过去全是代码缩进,很难提炼出代码的核心逻辑。

早在 2.5 版本时,Python 语言就已经提供了对付这类场景的工具:“上下文管理器(context manager)”。上下文管理器是一种配合 with 语句使用的特殊 Python 对象,通过它,可以让异常处理工作变得更方便。

那么,如何利用上下文管理器来改善我们的异常处理流程呢?让我们直接看代码吧。

1 | |

在上面的代码里,我们定义了一个名为 raise_api_error 的上下文管理器,它在进入上下文时什么也不做。但是在退出上下文时,会判断当前上下文中是否抛出了类型为 self.captures 的异常,如果有,就用 APIErrorCode 异常类替代它。

使用该上下文管理器后,整个函数可以变得更清晰简洁:

1 | |

Hint:建议阅读 PEP 343 – The “with” Statement | Python.org,了解与上下文管理器有关的更多知识。

模块 contextlib 也提供了非常多与编写上下文管理器相关的工具函数与样例。

总结一下

在这篇文章中,我分享了与异常处理相关的三个建议。最后再总结一下要点:

- 只捕获可能会抛出异常的语句,避免含糊的捕获逻辑

- 保持模块异常类的抽象一致性,必要时对底层异常类进行包装

- 使用“上下文管理器”可以简化重复的异常处理逻辑

第七章:类与对象

7.1 【基础】类的理解与使用

1. 通俗理解类

类(英文名 class),是具有相同特性(属性)和行为(方法)的对象(实例)的抽象模板。

从定义上来理解类,是一件非常吃力的事情,特别是对那些没有任何基础的初学者。

下面我举例来说明类中一些关键术语都是什么意思:

- 类:动物属于一个类,植物属于一个类

- 实例:猫和狗都属于同一类,就是动物类,那么猫和狗是动物类的实例/对象。

- 属性:类中所有的变量,都叫做属性。

- 方法:类中的所有函数,都叫做方法。

类与对象的关系就如模具和铸件的关系,类的实例化的结果就是对象,而对象的抽象就是类,类描述了一组有相同特性(属性)和相同行为(方法)的对象。

2. 如何定义类?

定义一个类,使用的是 class 关键字

下边我定义了一个 Animal 的类

1 | |

其中

Animal是类名__init__是构造函数,用于实例的初始化self.name是实例属性,age是类属性run是方法,第一个参数 self 是什么意思呢?这个咱后面再讲。

除了上面这种写法外

1 | |

还有另外两种写法,与之是等价的

1 | |

因为在 Python 3 中,无论你是否显示继承自 object,Python 解释器都会默认你继承 object ,这是新式类的写法,与之对应的是 Python 2 的经典类写法(Python 2 已经远去,无需要再了解经典类写法)。

3. 如何实例化?

定义了类之后,就可以通过下边的写法实例化它,并访问属性,调用方法

1 | |

在实例化时传入的参数 name="小黑" 传进入到构造函数 __init__ 中,最终赋值 self.name 成为实例的属性。

4. 方法的调用

实例化成对象后,如果访问实例属性,可以用 对象.属性名 进行访问。

1 | |

如果要调用方法,有两种方法

- 通过

对象.方法名:使用这种方法,在定义方法时 self 就代表对象(dog),调用时无需再传入了。

1 | |

- 通过

类.方法名:使用这种方法,self 参数要传入实例对象

1 | |

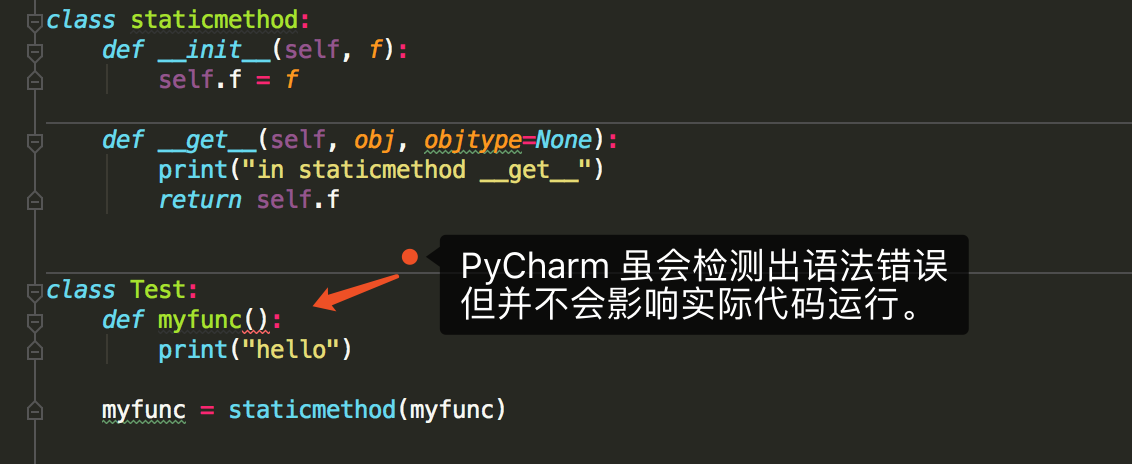

7.2 【基础】静态方法与类方法

1. 写法上的差异

类的方法可以分为:

- 静态方法:有

staticmethod装饰的函数 - 类方法:有

classmethod装饰的函数 - 实例方法:没有任何装饰器的普通函数

举个例子,如下这段代码中,run 普通的实例方法,eat 是静态方法,jump 是类方法。

1 | |

这三种方法,在写法有很大的区别:

1、普通的实例方法,在定义时,他的第一个方法固定是 self,如果是从实例调用,那么 self 参数 不需要传入,如果是通过类调用,那么 self 要传入已经实例化的对象。

1 | |

2、静态方法,在定义时,不需要 self 参数。

1 | |

3、类方法,在定义时,第一个参数固定是 cls,为 class 的简写,代表类本身。不管是通过实例还是类调用类方法,都不需要传入 cls 的参数。

1 | |

2. 方法与函数区别

在前面,我们很经常提到方法和函数,为免有同学将他们混为一谈,我这里总结一下他们的区别。

在 Python 3.x 中,

普通函数(未定位在类里)和静态方法,都是函数(

function)。实例方法(@staticmethod)和类方法,都是方法(

method)。

这些结论其实都可以使用 type 函数得到验证。

先准备如下代码

1 | |

然后进入 Python Console 模式

1 | |

到这里,你应该会有疑问了吧?

类方法和实例方法,名字本身就有方法,也是方法也说得过去。那静态方法呢,为什么不是方法而是函数呢?

对此,我的理解是:方法是一种和对象(实例或者类)绑定后的特殊函数。

方法本质上还是函数,不同之处在于它与对象进行绑定。## 7.3 【基础】私有变量与私有方法

1. 下划线妙用

在 Python 中,下划线可是非常推荐使用的符号:

- 变量名推荐使用下划线分隔的蛇形命名法

- 魔法方法、构造函数都需要使用双下划线

- 对于暂时用不到的变量值,可以赋值给单下划线

_进行占位

根据分类,我把下划线写法分成下面五种:

- 单前导下划线:

_var - 单末尾下划线:

var_ - 双前导下划线:

__var - 双前导和末尾下划线:

__var__ - 单下划线:

_

由于篇幅所限,本篇将只介绍跟标题(私有变量与私有方法)有关的用法,也就是访问控制。

上面五种写法中,涉及到访问控制的有:_var 和 __var

2. 单前导下划线 _var

下划线前缀的含义是告知其他程序员:以单个下划线开头的变量或方法仅供内部使用。

请看下面这个例子

1 | |

如果你实例化此类,然后分别访问 self.foo 和 self._bar 会发生什么情况?

1 | |

结果是:外界都可以直接访问这两个属性。

但实际上,二者是有区别的。PEP 8 有提及,如果一个属性的有单前导下划线,则该属性应该仅供内部访问。

但这并不是强制性的,不然上面我们也不可能通过 self._bar 访问到 22,但做为一名 Python 程序员最好遵守这一共识。

3. 双前导下划线 __var

双下划线前缀会导致Python解释器重写属性名称,以避免子类中的命名冲突。

这也叫做名称修饰(name mangling) - 解释器更改变量的名称,以便在类被扩展的时候不容易产生冲突。

我知道这听起来很抽象。因此,我组合了一个小小的代码示例来予以说明:

1 | |

将其进行实例化,然后使用 dir() 函数查看这个对象的属性

1 | |

不难发现,foo 和 _bar 都很正常,可以使用 demo.属性名 进行访问。

但 __baz 明显和 foo 、 _bar 不一样,尝试访问后却报了 AttributeError,属性不存在。

1 | |

如果你仔细观察,你会看到此对象上有一个名为_Demo__baz的属性。这就是Python解释器所做的名称修饰。它这样做是为了防止变量在子类中被重写。

如果想访问,那得按照 dir 提示的写法去访问,在 __baz 前面加上 _类名。

1 | |

总结可得,使用双下划线开头的属性变量,就是一个私有变量。

这样的规则在属性上生效,在方法上也同样适用。

如果一个实例方法,以双下划线开头,那么这个方法就是一个私有的方法,不能由实例对象或者类直接调用。

必须得通过 实例._类名__方法名 来调用。

4. 总结一下

Python并没有真正的私有化支持,但可用下划线得到伪私有。

尽量避免定义以下划线开头的变量。

- 私有变量:以双下划线前导的变量,可以使用

实例._类名__变量名进行访问 - 私有方法:以双下划线前导的方法,可以使用

实例._类名__方法名()进行访问

私有变量和私有方法,虽然有办法访问,但是仍然不建议使用上面给出的方法直接访问,而应该接口统一的接口(函数入口)来对私有变量进行查看、变量,对私有方法进行调用。对于这些内容我放到了下一节的的封装,请继续往后学习。

7.4 【基础】类的封装(Encapsulation)

封装是指将数据与具体操作的实现代码放在某个对象内部,使这些代码的实现细节不被外界发现,外界只能通过接口使用该对象,而不能通过任何形式修改对象内部实现。

要了解封装,离不开“私有化”,就是将类或者是函数中的某些属性限制在某个区域之内,外部无法直接调用。

关于什么是 私有化变量和私有化函数,在上一节我已经很详细的讲过啦。

私有变量和私有方法,虽然有办法访问,但是仍然不建议使用上面给出的方法直接访问,而应该接口统一的接口(函数入口)来对私有变量进行查看、变量,对私有方法进行调用。这就是封装。

正是由于封装机制,程序在使用某一对象时不需要关心该对象的数据结构细节及实现操作的方法。使用封装能隐藏对象实现细节,使代码更易维护,同时因为不能直接调用、修改对象内部的私有信息,在一定程度上保证了系统安全性。类通过将函数和变量封装在内部,实现了比函数更高一级的封装。

请看下面这段代码

1 | |

我定义了一个 Person 的类,它有 name 和 age 两个属性。

如果想判断小明是不是成年人,需要使用 xh.age 来与 18 比较。

对于很多女生还来说,年龄是非常隐私的。如果不想年龄被人随意就获取,可以在 age 前加两个下划线,将其变成一个私有变量。外界就无法随随便便就知道某个人年龄啦。

如此一来,想要知道一个人是否是成年人,该怎么办呢?

这时候,就该 封装 出场啦。

我可以定义一个用于专门判断一个人是否成年人的函数,对 self.__age 这个属性进行封装。

1 | |

7.5 【基础】类的继承(Inheritance)

类的继承,跟人类繁衍的关系相似。

被继承的类称为基类(也叫做父类),继承而得的类叫派生类(也叫子类),这种关系就像人类的父子关系。

继承最大的好处是子类获得了父类的全部变量和方法的同时,又可以根据需要进行修改、拓展。

继承的语法结构是

1 | |

1. 单继承

举个例子:下面的代码中。先是定义了一个 People 类,里面有一个 speak 方法。然后再定义一个 Student 类,并继承自 People 类。

1 | |

由于继承的机制,Student 实例会拥有 People 类所有属性和方法,比如下边我可以直接调用 People 类的 speak 方法。

1 | |

你如果不想使用父类的方法,你可以重写它以覆盖父类的 speak 方法。

1 | |

此时,再调用的话,就会调用自己的方法了

1 | |

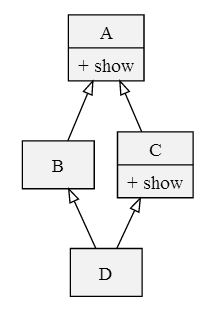

2. 多继承

Python 还支持多继承,可以继承自多个类。

1 | |

多继承的话,情况会比单继承复杂得多。

假设多个父类都有一个 foo 方法,并且子类没有重写 foo 方法,那么 子类 的实例在调用 foo 方法时,应该使用哪个父类的 foo 方法呢?

关于这一点,只要简单的做个验证就行啦。

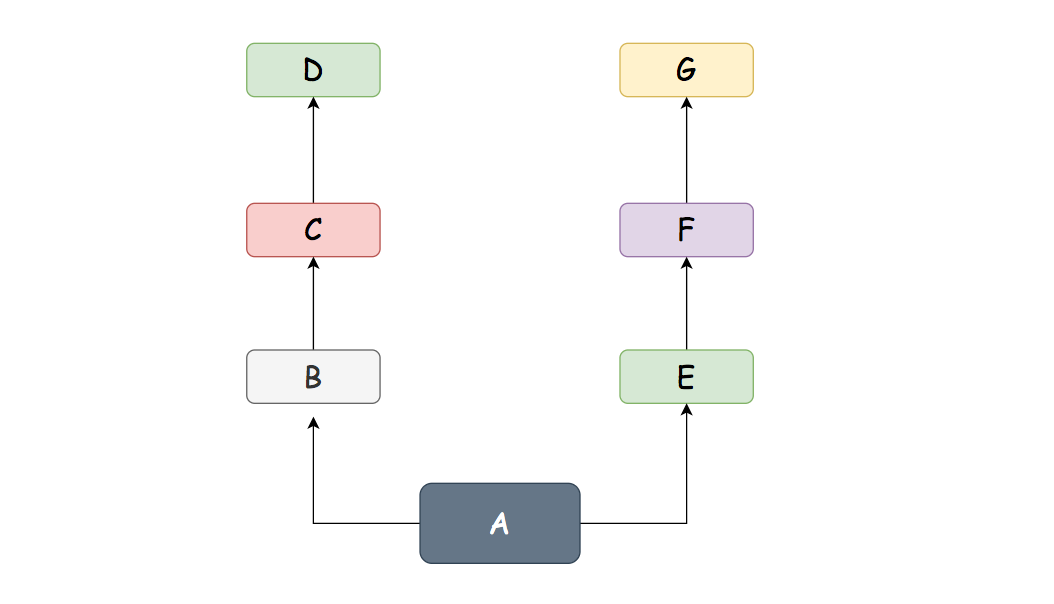

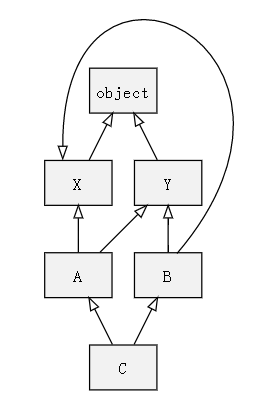

有如下代码,定义了 7 个类

1 | |

它们的继承关系是

运行后的结果如下

1 | |

在类A中,没有show()这个方法,于是它只能去它的父类里查找,它首先在B类中找,结果找到了,于是直接执行B类的show()方法。可见,在A的定义中,继承参数的书写有先后顺序,写在前面的被优先继承。

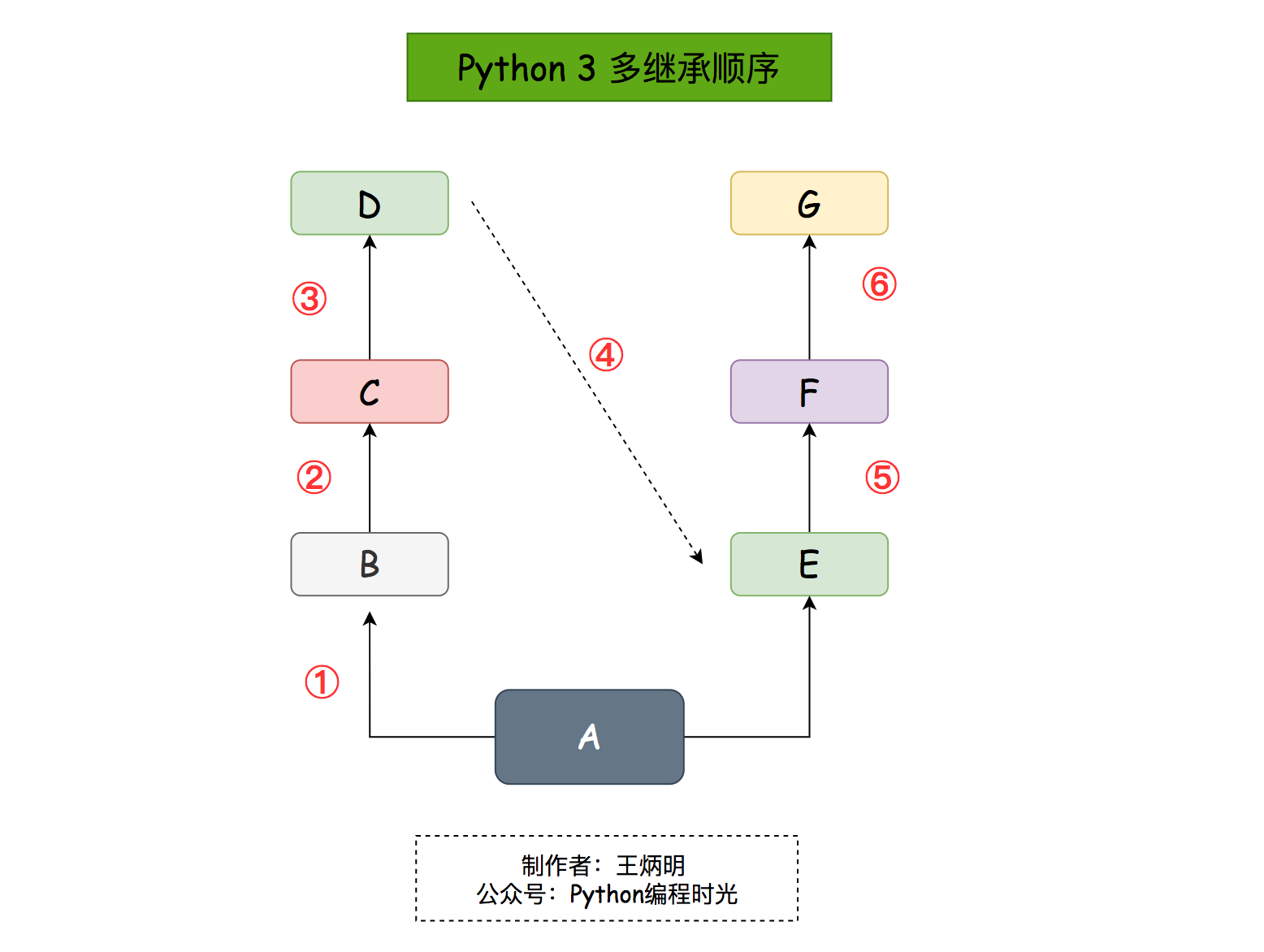

3. 继承顺序

那如果B没有show方法,而是D有呢?

1 | |

执行结果是

1 | |

由此可见,多继承的顺序使用的是从左向右再深度优先的原则。

4. MRO 算法

上面的继承案例是只是非常简单的一种场景,在实际应用中,会远比这个来得复杂。

此时如果你单纯的将其理解成

- 从左向右

- 深度优先

就会发现很场景下想要理清的方法解析顺序(MRO)是非常难的。

在这种情况下,你还可以有两种方法:

- 使用

__mro__来查询 - 使用 merge算法进行推导

使用 mro 查询

比如在下面这个菱形继承中

1 | |

可以使用 __mro__

1 | |

或者借助 inspect 模块

1 | |

得到的结果都将是

1 | |

使用 merge 推导

- 检查第一个列表的头元素(如 L[B1] 的头),记作 H。

- 若 H 未出现在其它列表的尾部,则将其输出,并将其从所有列表中删除,然后回到步骤1;否则,取出下一个列表的头部记作 H,继续该步骤。

- 重复上述步骤,直至列表为空或者不能再找出可以输出的元素。如果是前一种情况,则算法结束;如果是后一种情况,说明无法构建继承关系,Python 会抛出异常。

你可以在草稿纸上,参照上面的merge算法,写出如下过程

1 | |

附录:参考文章

- https://www.python.org/download/releases/2.3/mro/

- https://www.cnblogs.com/whatisfantasy/p/6046991.html

7.6 【基础】类的多态(Polymorphism)

多态,是指在同一类型下的不同形态。

比如下面这段代码

1 | |

American 和 Chinese 都继承了 People 类,但他们在 speak() 函数下,却有不同的形态表现。American 说英文,Chinese 说汉语。

倘若现在有一个 do_speak 函数

1 | |

那么无论传入的 American 实例还是 Chinese 实例,只要他有实现 speak 方法都可以。

这就是 Python 中非常有名鸭子类型:一个对象只要“看起来像鸭子,走起路来像鸭子”,那它就可以被看做是鸭子。

套入刚刚的代码实例中,就是一个对象,只要有 speak 方法,那么他就是一个 do_speak 方法所需要的 people 对象。

可能有人会觉得,这些内容很自然啊,没什么不好理解,不觉得多态有什么特殊,Python就是这样啊!

如果你学过 JAVA 这一类强类型静态语言,就不会这么觉得了,对于JAVA,必须指定函数参数的数据类型,只能传递对应参数类型或其子类型的参数,不能传递其它类型的参数,show_kind()函数只能接收animal、dog、cat和pig类型,而不能接收job类型。就算接收dog、cat和pig类型,也是通过面向对象的多态机制实现的。## 7.7 【基础】类的 property 属性

在之前的学习中,对象的属性,我们都是通过把变量值赋值给对象本身来实现的。

1 | |

直接赋值会存在一个问题,就是无法对属性值进行合法性较验,比如我给 age 赋值的是负数,在业务上这种数据是不合法的。但上面那种写法是无法检查出来的。

1 | |

为了实现属性的合法性校验,Python 引入的 property 属性。

请看下面这段代码

1 | |

此时再对 age 属性进行赋值就会对 value 的值进行合法性检查,小于 0 或者 大于 150 的都是不合法数据。

1 | |

由此我们知道了 property ,其实是 Python 中一个内置的装饰器,它可以在新式类中把一个函数 改造 成属性。

当你读取属性值时,会进入被

property装饰的函数。当你对属性进行赋值时,会进入被

@xx.setter装饰的函数。两个装饰器,一定是

@property在前面,而@xx.setter在后

7.8 【进阶】类的 Mixin 设计模式

类的单继承,是开发者再熟悉不过的继承方式,写起来也毫不费力。

而多继承呢,见得很多,写得很少。在很多的项目代码里,你还会见到一种很奇怪的类,他们有一个命名上的共同点,就是在类名的结尾,都喜欢用 Mixin。

1. 认识Mixin模式

那我们今天就来讲讲这个 Mixin,对于这个Mixin,如何理解?它其实是一种设计模式,如果开发者之间没有产生这样一种设计模式的共识,那么设计模式将不复存在。

为了让大家,对这个 Mixin 有一个更直观的理解,我摘录了网上一段说明。

继承是一个”is-a”关系。比如轿车类继承交通工具类,因为轿车是一个(“is-a”)交通工具。一个物品不可能是多种不同的东西,因此就不应该存在多重继承。不过有没有这种情况,一个类的确是需要继承多个类呢?

答案是有,我们还是拿交通工具来举例子,民航飞机是一种交通工具,对于土豪们来说直升机也是一种交通工具。对于这两种交通工具,它们都有一个功能是飞行,但是轿车没有。所以,我们不可能将飞行功能写在交通工具这个父类中。但是如果民航飞机和直升机都各自写自己的飞行方法,又违背了代码尽可能重用的原则(如果以后飞行工具越来越多,那会出现许多重复代码)。

怎么办,那就只好让这两种飞机同时继承交通工具以及飞行器两个父类,这样就出现了多重继承。这时又违背了继承必须是”is-a”关系。这个难题该怎么破?

这时候 Mixin 就闪亮登场了。飞行只是飞机做为交通工具的一种(增强)属性,我们可以为这个飞行的功能单独定义一个(增强)类,称之为 Mixin 类。这个类,是做为增强功能,添加到子类中的。为了让其他开发者,一看就知道这是个 Mixin 类,一般都要求开发者遵循规范,在类名末尾加上 Mixin 。

举个例子

1 | |

使用Mixin类实现多重继承要遵循以下几个规范

- 责任明确:必须表示某一种功能,而不是某个物品;

- 功能单一:若有多个功能,那就写多个Mixin类;

- 绝对独立:不能依赖于子类的实现;子类即便没有继承这个Mixin类,也照样可以工作,就是缺少了某个功能。

2. 不使用Mixin的弊端

你肯定会问,不使用 Mixin 行吗?

当然可以,这个问题就像在问,我不遵循 PEP8 代码规范行吗?完全没问题,只是不推荐那样做。

那么到底有什么理由,让我们要去用到 Mixin 设计模式呢?

不使用的话,大概有如下三点弊端:

1、结构复杂

单继承中一个类的父类是什么,父类的父类是什么非常明确。多继承一个类有多个父类,父类又有多个父类,继承关系复杂。

2、优先顺序模糊

多个父类中有同名方法,在开发过程中,容易造成思维混乱,子类不知道继承哪个父类,会增加开发难度。关于子类的继承顺序,有一个比较复杂的 C3 算法,如果你还不清楚,可以点击我的另一篇文章 ,了解一下。

3、功能冲突

多重继承有多个父类,但是子类只能继承一个,对于同名方法,就会导致另一个父类的方法失效。

7.9 【进阶】类的魔术方法(超全整理)

什么是魔法方法呢?它们在面向对象的Python的处处皆是。

它们是一些可以让你对类添加魔法的特殊方法。它们经常是两个下划线包围来命名的(比如 __init__ , __lt__ )。

本文整理自: (译)Python魔法方法指南,内容非常多,不适合新手全文阅读,如果你是跟着教程从头看到这的,建议先跳过本文内容。而如果你是一名有经验的 Python 老手,可以考虑全文通读,会加深你对 Python 魔法方法的理解。

01. 构造方法

我们最为熟知的基本的魔法方法就是 __init__ ,我们可以用它来指明一个对象初始化的行为。然而,当我们调用 x = SomeClass() 的时候, __init__ 并不是第一个被调用的方法。事实上,第一个被调用的是 __new__ ,这个 方法才真正地创建了实例。当这个对象的生命周期结束的时候, __del__ 会被调用。让我们近一步理解这三个方法:

__new__(cls,[…)__new__是对象实例化时第一个调用的方法,它只取下 cls 参数,并把其他参数传给__init__。__new__很少使用,但是也有它适合的场景,尤其是当类继承自一个像元组或者字符串这样不经常改变的类型的时候。我不打算深入讨论__new__,因为它并不是很有用, Python文档 中 有详细的说明。__init__(self,[…])类的初始化方法。它获取任何传给构造器的参数(比如我们调用 x = SomeClass(10, ‘foo’) ,

__init__就会接到参数 10 和 ‘foo’ 。__init__在Python的类定义中用的最多。__del__(self)__new__和__init__是对象的构造器,__del__是对象的销毁器。它并非实现了语句 del x (因此该语句不等同于 x.__del__()。而是定义了当对象被垃圾回收时的行为。当对象需要在销毁时做一些处理的时候这个方法很有用,比如 socket 对象、文件对象。但是需要注意的是,当Python解释器退出但对象仍然存活的时候,__del__并不会 执行。所以养成一个手工清理的好习惯是很重要的,比如及时关闭连接。

这里有个 __init__ 和 __del__ 的例子:

1 | |

02. 操作符

使用Python魔法方法的一个巨大优势就是可以构建一个拥有Python内置类型行为的对象。这意味着你可以避免使用非标准的、丑陋的方式来表达简单的操作。在一些语言中,这样做很常见:

1 | |

你当然可以在Python也这么做,但是这样做让代码变得冗长而混乱。不同的类库可能对同一种比较操作采用不同的方法名称,这让使用者需要做很多没有必要的工作。运用魔法方法的魔力,我们可以定义方法 __eq__

1 | |

这是魔法力量的一部分,这样我们就可以创建一个像内建类型那样的对象了!

2.1 比较操作符

Python包含了一系列的魔法方法,用于实现对象之间直接比较,而不需要采用方法调用。同样也可以重载Python默认的比较方法,改变它们的行为。下面是这些方法的列表:

__cmp__(self, other)__cmp__是所有比较魔法方法中最基础的一个,它实际上定义了所有比较操作符的行为(<,==,!=,等等),但是它可能不能按照你需要的方式工作(例如,判断一个实例和另一个实例是否相等采用一套标准,而与判断一个实例是否大于另一实例采用另一套)。__cmp__应该在 self < other 时返回一个负整数,在 self == other 时返回0,在 self > other 时返回正整数。最好只定义你所需要的比较形式,而不是一次定义全部。如果你需要实现所有的比较形式,而且它们的判断标准类似,那么__cmp__是一个很好的方法,可以减少代码重复,让代码更简洁。__eq__(self, other)定义等于操作符(==)的行为。

__ne__(self, other)定义不等于操作符(!=)的行为。

__lt__(self, other)定义小于操作符(<)的行为。

__gt__(self, other)定义大于操作符(>)的行为。

__le__(self, other)定义小于等于操作符(<)的行为。

__ge__(self, other)定义大于等于操作符(>)的行为。

举个例子,假如我们想用一个类来存储单词。我们可能想按照字典序(字母顺序)来比较单词,字符串的默认比较行为就是这样。我们可能也想按照其他规则来比较字符串,像是长度,或者音节的数量。在这个例子中,我们使用长度作为比较标准,下面是一种实现:

1 | |

现在我们可以创建两个 Word 对象( Word(‘foo’) 和 Word(‘bar’))然后根据长度来比较它们。注意我们没有定义 __eq__ 和 __ne__ ,这是因为有时候它们会导致奇怪的结果(很明显, Word(‘foo’) == Word(‘bar’) 得到的结果会是true)。根据长度测试是否相等毫无意义,所以我们使用 str 的实现来比较相等。

从上面可以看到,不需要实现所有的比较魔法方法,就可以使用丰富的比较操作。标准库还在 functools 模块中提供了一个类装饰器,只要我们定义 __eq__ 和另外一个操作符( __gt__, __lt__ 等),它就可以帮我们实现比较方法。这个特性只在 Python 2.7 中可用。当它可用时,它能帮助我们节省大量的时间和精力。要使用它,只需要它 @total_ordering 放在类的定义之上就可以了

2.2 数值操作符

就像你可以使用比较操作符来比较类的实例,你也可以定义数值操作符的行为。固定好你的安全带,这样的操作符真的有很多。看在组织的份上,我把它们分成了五类:一元操作符,常见算数操作符,反射算数操作符(后面会涉及更多),增强赋值操作符,和类型转换操作符。

一元操作符

一元操作符只有一个操作符。

__pos__(self)实现取正操作,例如 +some_object。

__neg_(self)实现取负操作,例如 -some_object。

__abs__(self)实现内建绝对值函数 abs() 操作。

__invert__(self)实现取反操作符 ~。

__round__(self, n)实现内建函数 round() ,n 是近似小数点的位数。

__floor__(self)实现 math.floor() 函数,即向下取整。

__ceil__(self)实现 math.ceil() 函数,即向上取整。

__trunc__(self)实现 math.trunc() 函数,即截断整数。

常见算数操作符

现在,我们来看看常见的二元操作符(和一些函数),像+,-,*之类的,它们很容易从字面意思理解。

__add__(self, other)实现加法操作。

__sub__(self, other)实现减法操作。

__mul__(self, other)实现乘法操作。

__floordiv__(self, other)实现使用 // 操作符的整数除法。

__div__(self, other)实现使用 / 操作符的除法。

__truediv__(self, other)实现 true 除法,这个函数只有使用

from __future__ import division时才有作用。__mod__(self, other)实现 % 取余操作。

__divmod__(self, other)实现 divmod 内建函数。

__pow__(self)实现 ** 操作符。

__lshift__(self, other)实现左移位运算符 << 。

__rshift__(self, other)实现右移位运算符 >> 。

__and__(self, other)实现按位与运算符 & 。

__or__(self, other)实现按位或运算符 | 。

__xor__(self, other)实现按位异或运算符 ^ 。

反射算数运算符

还记得刚才我说会谈到反射运算符吗?可能你会觉得它是什么高端霸气上档次的概念,其实这东西挺简单的,下面举个例子:

1 | |

这是“常见”的加法,反射是一样的意思,只不过是运算符交换了一下位置:

1 | |

所有反射运算符魔法方法和它们的常见版本做的工作相同,只不过是处理交换连个操作数之后的情况。绝大多数情况下,反射运算和正常顺序产生的结果是相同的,所以很可能你定义 __radd__ 时只是调用一下 __add__。注意一点,操作符左侧的对象(也就是上面的 other )一定不要定义(或者产生 NotImplemented 异常) 操作符的非反射版本。例如,在上面的例子中,只有当 other 没有定义 __add__ 时 some_object.__radd__ 才会被调用。

__radd__(self, other)实现反射加法操作。

__rsub__(self, other)实现反射减法操作。

__rmul__(self, other)实现反射乘法操作。

__rfloordiv__(self, other)实现使用 // 操作符的整数反射除法。

__rdiv__(self, other)实现使用 / 操作符的反射除法。

__rtruediv__(self, other)实现 true 反射除法,这个函数只有使用

from __future__ import division时才有作用。__rmod__(self, other)实现 % 反射取余操作符。

__rdivmod__(self, other)实现调用 divmod(other, self) 时 divmod 内建函数的操作。

__rpow__(self)实现 ** 反射操作符。

__rlshift__(self, other)实现反射左移位运算符 << 的作用。

__rshift__(self, other)实现反射右移位运算符 >> 的作用。

__rand__(self, other)实现反射按位与运算符 & 。

__ror__(self, other)实现反射按位或运算符 | 。

__rxor__(self, other)实现反射按位异或运算符 ^ 。

增强赋值运算符

Python同样提供了大量的魔法方法,可以用来自定义增强赋值操作的行为。或许你已经了解增强赋值,它融合了“常见”的操作符和赋值操作,如果你还是没听明白,看下面的例子:

1 | |

这些方法都应该返回左侧操作数应该被赋予的值(例如, a += b __iadd__ 也许会返回 a + b ,这个结果会被赋给 a ),下面是方法列表:

__iadd__(self, other)实现加法赋值操作。

__isub__(self, other)实现减法赋值操作。

__imul__(self, other)实现乘法赋值操作。

__ifloordiv__(self, other)实现使用 //= 操作符的整数除法赋值操作。

__idiv__(self, other)实现使用 /= 操作符的除法赋值操作。

__itruediv__(self, other)实现 true 除法赋值操作,这个函数只有使用

from __future__ import division时才有作用。__imod__(self, other)实现 %= 取余赋值操作。

__ipow__(self)实现 **= 操作。

__ilshift__(self, other)实现左移位赋值运算符 <<= 。

__irshift__(self, other)实现右移位赋值运算符 >>= 。

__iand__(self, other)实现按位与运算符 &= 。

__ior__(self, other)实现按位或赋值运算符 | 。

__ixor__(self, other)实现按位异或赋值运算符 ^= 。

类型转换操作符

Python也有一系列的魔法方法用于实现类似 float() 的内建类型转换函数的操作。它们是这些:

__int__(self)实现到int的类型转换。

__long__(self)实现到long的类型转换。

__float__(self)实现到float的类型转换。

__complex__(self)实现到complex的类型转换。

__oct__(self)实现到八进制数的类型转换。

__hex__(self)实现到十六进制数的类型转换。

__index__(self)实现当对象用于切片表达式时到一个整数的类型转换。如果你定义了一个可能会用于切片操作的数值类型,你应该定义

__index__。__trunc__(self)当调用 math.trunc(self) 时调用该方法,

__trunc__应该返回 self 截取到一个整数类型(通常是long类型)的值。__coerce__(self)该方法用于实现混合模式算数运算,如果不能进行类型转换,

__coerce__应该返回 None 。反之,它应该返回一个二元组 self 和 other ,这两者均已被转换成相同的类型。

03. 类的表示

使用字符串来表示类是一个相当有用的特性。在Python中有一些内建方法可以返回类的表示,相对应的,也有一系列魔法方法可以用来自定义在使用这些内建函数时类的行为。

__str__(self)定义对类的实例调用 str() 时的行为。

__repr__(self)定义对类的实例调用 repr() 时的行为。str() 和 repr() 最主要的差别在于“目标用户”。repr() 的作用是产生机器可读的输出(大部分情况下,其输出可以作为有效的Python代码),而 str() 则产生人类可读的输出。

__unicode__(self)定义对类的实例调用 unicode() 时的行为。unicode() 和 str() 很像,只是它返回unicode字符串。注意,如果调用者试图调用 str() 而你的类只实现了

__unicode__() ,那么类将不能正常工作。所有你应该总是定义__str__() ,以防有些人没有闲情雅致来使用unicode。__format__(self)定义当类的实例用于新式字符串格式化时的行为,例如, “Hello, 0:abc!”.format(a) 会导致调用

a.__format__("abc")。当定义你自己的数值类型或字符串类型时,你可能想提供某些特殊的格式化选项,这种情况下这个魔法方法会非常有用。__hash__(self)定义对类的实例调用 hash() 时的行为。它必须返回一个整数,其结果会被用于字典中键的快速比较。同时注意一点,实现这个魔法方法通常也需要实现

__eq__,并且遵守如下的规则:a == b 意味着 hash(a) == hash(b)。__nonzero__(self)定义对类的实例调用 bool() 时的行为,根据你自己对类的设计,针对不同的实例,这个魔法方法应该相应地返回True或False。

__dir__(self)定义对类的实例调用 dir() 时的行为,这个方法应该向调用者返回一个属性列表。一般来说,没必要自己实现

__dir__。但是如果你重定义了__getattr__或者__getattribute__(下个部分会介绍),乃至使用动态生成的属性,以实现类的交互式使用,那么这个魔法方法是必不可少的。

到这里,我们基本上已经结束了魔法方法指南中无聊并且例子匮乏的部分。既然我们已经介绍了较为基础的魔法方法,是时候涉及更高级的内容了。

04. 访问控制

很多从其他语言转向Python的人都抱怨Python的类缺少真正意义上的封装(即没办法定义私有属性然后使用公有的getter和setter)。然而事实并非如此。实际上Python不是通过显式定义的字段和方法修改器,而是通过魔法方法实现了一系列的封装。

__getattr__(self, name)

当用户试图访问一个根本不存在(或者暂时不存在)的属性时,你可以通过这个魔法方法来定义类的行为。这个可以用于捕捉错误的拼写并且给出指引,使用废弃属性时给出警告(如果你愿意,仍然可以计算并且返回该属性),以及灵活地处理AttributeError。只有当试图访问不存在的属性时它才会被调用,所以这不能算是一个真正的封装的办法。

__setattr__(self, name, value)

和 __getattr__ 不同, __setattr__ 可以用于真正意义上的封装。它允许你自定义某个属性的赋值行为,不管这个属性存在与否,也就是说你可以对任意属性的任何变化都定义自己的规则。然后,一定要小心使用 __setattr__ ,这个列表最后的例子中会有所展示。

__delattr__(self, name)

这个魔法方法和 __setattr__几乎相同,只不过它是用于处理删除属性时的行为。和 _setattr__ 一样,使用它时也需要多加小心,防止产生无限递归(在 __delattr__ 的实现中调用 del self.name 会导致无限递归)。

__getattribute__(self, name)

__getattribute__ 看起来和上面那些方法很合得来,但是最好不要使用它。__getattribute__ 只能用于新式类。在最新版的Python中所有的类都是新式类,在老版Python中你可以通过继承 object 来创建新式类。__getattribute__ 允许你自定义属性被访问时的行为,它也同样可能遇到无限递归问题(通过调用基类的 __getattribute__ 来避免)。__getattribute__ 基本上可以替代 __getattr__ 。只有当它被实现,并且显式地被调用,或者产生 AttributeError 时它才被使用。这个魔法方法可以被使用(毕竟,选择权在你自己),我不推荐你使用它,因为它的使用范围相对有限(通常我们想要在赋值时进行特殊操作,而不是取值时),而且实现这个方法很容易出现Bug。

自定义这些控制属性访问的魔法方法很容易导致问题,考虑下面这个例子:

1 | |

再次重申,Python的魔法方法十分强大,能力越强责任越大,了解如何正确的使用魔法方法更加重要。

到这里,我们对Python中自定义属性存取控制有了什么样的印象?它并不适合轻度的使用。实际上,它有些过分强大,而且违反直觉。然而它之所以存在,是因为一个更大的原则:Python不指望让杜绝坏事发生,而是想办法让做坏事变得困难。自由是至高无上的权利,你真的可以随心所欲。下面的例子展示了实际应用中某些特殊的属性访问方法(注意我们之所以使用 super 是因为不是所有的类都有 __dict__ 属性):

1 | |

05. 自定义序列

有许多办法可以让你的Python类表现得像是内建序列类型(字典,元组,列表,字符串等)。这些魔法方式是目前为止我最喜欢的。它们给了你难以置信的控制能力,可以让你的类与一系列的全局函数完美结合。在了解激动人心的内容之前,首先你需要掌握一些预备知识。

既然讲到创建自己的序列类型,就不得不说一说协议了。协议类似某些语言中的接口,里面包含的是一些必须实现的方法。在Python中,协议完全是非正式的,也不需要显式的声明,事实上,它们更像是一种参考标准。

为什么我们要讲协议?因为在Python中实现自定义容器类型需要用到一些协议。首先,不可变容器类型有如下协议:想实现一个不可变容器,你需要定义 __len__ 和 __getitem__ (后面会具体说明)。可变容器的协议除了上面提到的两个方法之外,还需要定义 __setitem__ 和 __delitem__ 。最后,如果你想让你的对象可以迭代,你需要定义 __iter__ ,这个方法返回一个迭代器。迭代器必须遵守迭代器协议,需要定义 __iter__ (返回它自己)和 next 方法。

5.1 容器背后的魔法方法

__len__(self)返回容器的长度,可变和不可变类型都需要实现。

__getitem__(self, key)定义对容器中某一项使用 self[key] 的方式进行读取操作时的行为。这也是可变和不可变容器类型都需要实现的一个方法。它应该在键的类型错误式产生 TypeError 异常,同时在没有与键值相匹配的内容时产生 KeyError 异常。

__setitem__(self, key)定义对容器中某一项使用 self[key] 的方式进行赋值操作时的行为。它是可变容器类型必须实现的一个方法,同样应该在合适的时候产生 KeyError 和 TypeError 异常。

__iter__(self, key)它应该返回当前容器的一个迭代器。迭代器以一连串内容的形式返回,最常见的是使用 iter() 函数调用,以及在类似 for x in container: 的循环中被调用。迭代器是他们自己的对象,需要定义

__iter__方法并在其中返回自己。__reversed__(self)定义了对容器使用 reversed() 内建函数时的行为。它应该返回一个反转之后的序列。当你的序列类是有序时,类似列表和元组,再实现这个方法,

__contains__(self, item)__contains__定义了使用 in 和 not in 进行成员测试时类的行为。你可能好奇为什么这个方法不是序列协议的一部分,原因是,如果__contains__没有定义,Python就会迭代整个序列,如果找到了需要的一项就返回 True 。__missing__(self ,key)__missing__在字典的子类中使用,它定义了当试图访问一个字典中不存在的键时的行为(目前为止是指字典的实例,例如我有一个字典 d , “george” 不是字典中的一个键,当试图访问 d[“george’] 时就会调用 d.__missing__(“george”) )。

5.2 一个例子

让我们来看一个实现了一些函数式结构的列表,可能在其他语言中这种结构更常见(例如Haskell):

1 | |

就是这些,一个(微不足道的)有用的例子,向你展示了如何实现自己的序列。当然啦,自定义序列有更大的用处,而且绝大部分都在标准库中实现了(Python是自带电池的,记得吗?),像 Counter , OrderedDict 和 NamedTuple 。

06. 反射

你可以通过定义魔法方法来控制用于反射的内建函数 isinstance 和 issubclass 的行为。下面是对应的魔法方法:

__instancecheck__(self, instance)检查一个实例是否是你定义的类的一个实例(例如 isinstance(instance, class) )。

__subclasscheck__(self, subclass)检查一个类是否是你定义的类的子类(例如 issubclass(subclass, class) )。

这几个魔法方法的适用范围看起来有些窄,事实也正是如此。我不会在反射魔法方法上花费太多时间,因为相比其他魔法方法它们显得不是很重要。但是它们展示了在Python中进行面向对象编程(或者总体上使用Python进行编程)时很重要的一点:不管做什么事情,都会有一个简单方法,不管它常用不常用。这些魔法方法可能看起来没那么有用,但是当你真正需要用到它们的时候,你会感到很幸运,因为它们还在那儿(也因为你阅读了这本指南!)

07. 抽象基类

请参考 http://docs.python.org/2/library/abc.html

08. 可调用的对象

你可能已经知道了,在Python中,函数是一等的对象。这意味着它们可以像其他任何对象一样被传递到函数和方法中,这是一个十分强大的特性。

Python中一个特殊的魔法方法允许你自己类的对象表现得像是函数,然后你就可以“调用”它们,把它们传递到使用函数做参数的函数中,等等等等。这是另一个强大而且方便的特性,让使用Python编程变得更加幸福。

__call__(self, [args…])允许类的一个实例像函数那样被调用。本质上这代表了 x() 和 x.

__call__() 是相同的。注意__call__可以有多个参数,这代表你可以像定义其他任何函数一样,定义__call__,喜欢用多少参数就用多少。

__call__ 在某些需要经常改变状态的类的实例中显得特别有用。“调用”这个实例来改变它的状态,是一种更加符合直觉,也更加优雅的方法。一个表示平面上实体的类是一个不错的例子:

1 | |

09. 上下文管理器

在Python 2.5中引入了一个全新的关键词,随之而来的是一种新的代码复用方法—— with 声明。上下文管理的概念在Python中并不是全新引入的(之前它作为标准库的一部分实现),直到PEP 343被接受,它才成为一种一级的语言结构。可能你已经见过这种写法了:

1 | |

当对象使用 with 声明创建时,上下文管理器允许类做一些设置和清理工作。上下文管理器的行为由下面两个魔法方法所定义:

__enter__(self)定义使用 with 声明创建的语句块最开始上下文管理器应该做些什么。注意

__enter__的返回值会赋给 with 声明的目标,也就是 as 之后的东西。__exit__(self, exception_type, exception_value, traceback)定义当 with 声明语句块执行完毕(或终止)时上下文管理器的行为。它可以用来处理异常,进行清理,或者做其他应该在语句块结束之后立刻执行的工作。如果语句块顺利执行, exception_type , exception_value 和 traceback 会是 None 。否则,你可以选择处理这个异常或者让用户来处理。如果你想处理异常,确保

__exit__在完成工作之后返回 True 。如果你不想处理异常,那就让它发生吧。

对一些具有良好定义的且通用的设置和清理行为的类,__enter__ 和 __exit__会显得特别有用。你也可以使用这几个方法来创建通用的上下文管理器,用来包装其他对象。下面是一个例子:

1 | |

这是一个 Closer 在实际使用中的例子,使用一个FTP连接来演示(一个可关闭的socket):

1 | |

看到我们的包装器是如何同时优雅地处理正确和不正确的调用了吗?这就是上下文管理器和魔法方法的力量。Python标准库包含一个 contextlib 模块,里面有一个上下文管理器 contextlib.closing() 基本上和我们的包装器完成的是同样的事情(但是没有包含任何当对象没有close()方法时的处理)。

10. 创建描述符对象

描述符是一个类,当使用取值,赋值和删除 时它可以改变其他对象。描述符不是用来单独使用的,它们需要被一个拥有者类所包含。描述符可以用来创建面向对象数据库,以及创建某些属性之间互相依赖的类。描述符在表现具有不同单位的属性,或者需要计算的属性时显得特别有用(例如表现一个坐标系中的点的类,其中的距离原点的距离这种属性)。

要想成为一个描述符,一个类必须具有实现 __get__ , __set__ 和 __delete__ 三个方法中至少一个。

让我们一起来看一看这些魔法方法:

__get__(self, instance, owner)定义当试图取出描述符的值时的行为。instance 是拥有者类的实例, owner 是拥有者类本身。

__set__(self, instance, owner)定义当描述符的值改变时的行为。instance 是拥有者类的实例, value 是要赋给描述符的值。

__delete__(self, instance, value)定义当描述符的值被删除时的行为。instance 是拥有者类的实例

现在,来看一个描述符的有效应用:单位转换:

1 | |

11. 拷贝

有些时候,特别是处理可变对象时,你可能想拷贝一个对象,改变这个对象而不影响原有的对象。这时就需要用到Python的 copy 模块了。然而(幸运的是),Python模块并不具有感知能力, 因此我们不用担心某天基于Linux的机器人崛起。但是我们的确需要告诉Python如何有效率地拷贝对象。

__copy__(self)定义对类的实例使用 copy.copy() 时的行为。copy.copy() 返回一个对象的浅拷贝,这意味着拷贝出的实例是全新的,然而里面的数据全都是引用的。也就是说,对象本身是拷贝的,但是它的数据还是引用的(所以浅拷贝中的数据更改会影响原对象)。

__deepcopy__(self, memodict=)定义对类的实例使用 copy.deepcopy() 时的行为。copy.deepcopy() 返回一个对象的深拷贝,这个对象和它的数据全都被拷贝了一份。memodict 是一个先前拷贝对象的缓存,它优化了拷贝过程,而且可以防止拷贝递归数据结构时产生无限递归。当你想深拷贝一个单独的属性时,在那个属性上调用 copy.deepcopy() ,使用 memodict 作为第一个参数。

这些魔法方法有什么用武之地呢?像往常一样,当你需要比默认行为更加精确的控制时。例如,如果你想拷贝一个对象,其中存储了一个字典作为缓存(可能会很大),拷贝缓存可能是没有意义的。如果这个缓存可以在内存中被不同实例共享,那么它就应该被共享。

12. Pickling

如果你和其他的Python爱好者共事过,很可能你已经听说过Pickling了。Pickling是Python数据结构的序列化过程,当你想存储一个对象稍后再取出读取时,Pickling会显得十分有用。然而它同样也是担忧和混淆的主要来源。

Pickling是如此的重要,以至于它不仅仅有自己的模块( pickle ),还有自己的协议和魔法方法。首先,我们先来简要的介绍一下如何pickle已存在的对象类型(如果你已经知道了,大可跳过这部分内容)。

12.1 小试牛刀

我们一起来pickle吧。假设你有一个字典,你想存储它,稍后再取出来。你可以把它的内容写入一个文件,小心翼翼地确保使用了正确地格式,要把它读取出来,你可以使用 exec() 或处理文件输入。但是这种方法并不可靠:如果你使用纯文本来存储重要数据,数据很容易以多种方式被破坏或者修改,导致你的程序崩溃,更糟糕的情况下,还可能在你的计算机上运行恶意代码。因此,我们要pickle它:

1 | |

过了几个小时,我们想把它取出来,我们只需要反pickle它:

1 | |

将会发生什么?正如你期待的,它就是我们之前的 data 。

现在,还需要谨慎地说一句:pickle并不完美。Pickle文件很容易因为事故或被故意的破坏掉。Pickling或许比纯文本文件安全一些,但是依然有可能被用来运行恶意代码。而且它还不支持跨Python版本,所以不要指望分发pickle对象之后所有人都能正确地读取。然而不管怎么样,它依然是一个强有力的工具,可以用于缓存和其他类型的持久化工作。

12.2 Pickle你的对象

Pickle不仅仅可以用于内建类型,任何遵守pickle协议的类都可以被pickle。Pickle协议有四个可选方法,可以让类自定义它们的行为(这和C语言扩展略有不同,那不在我们的讨论范围之内)。

__getinitargs__(self)如果你想让你的类在反pickle时调用

__init__,你可以定义__getinitargs__(self) ,它会返回一个参数元组,这个元组会传递给__init__。注意,这个方法只能用于旧式类。__getnewargs__(self)对新式类来说,你可以通过这个方法改变类在反pickle时传递给

__new__的参数。这个方法应该返回一个参数元组。__getstate__(self)你可以自定义对象被pickle时被存储的状态,而不使用对象的

__dict__属性。这个状态在对象被反pickle时会被__setstate__使用。__setstate__(self)当一个对象被反pickle时,如果定义了

__setstate__,对象的状态会传递给这个魔法方法,而不是直接应用到对象的__dict__属性。这个魔法方法和__getstate__相互依存:当这两个方法都被定义时,你可以在Pickle时使用任何方法保存对象的任何状态。__reduce__(self)当定义扩展类型时(也就是使用Python的C语言API实现的类型),如果你想pickle它们,你必须告诉Python如何pickle它们。reduce 被定义之后,当对象被Pickle时就会被调用。它要么返回一个代表全局名称的字符串,Pyhton会查找它并pickle,要么返回一个元组。这个元组包含2到5个元素,其中包括:一个可调用的对象,用于重建对象时调用;一个参数元素,供那个可调用对象使用;被传递给

__setstate__的状态(可选);一个产生被pickle的列表元素的迭代器(可选);一个产生被pickle的字典元素的迭代器(可选);__reduce_ex__(self)__reduce_ex__的存在是为了兼容性。如果它被定义,在pickle时__reduce_ex__会代替__reduce__被调用。__reduce__也可以被定义,用于不支持__reduce_ex__的旧版pickle的API调用。

12.3 一个例子

我们的例子是 Slate ,它会记住它的值曾经是什么,以及那些值是什么时候赋给它的。然而 每次被pickle时它都会变成空白,因为当前的值不会被存储:

1 | |

13. 总结在最后

这本指南的目标是使所有阅读它的人都能有所收获,无论他们有没有使用Python或者进行面向对象编程的经验。如果你刚刚开始学习Python,你会得到宝贵的基础知识,了解如何写出具有丰富特性的,优雅而且易用的类。如果你是中级的Python程序员,你或许能掌握一些新的概念和技巧,以及一些可以减少代码行数的好办法。如果你是专家级别的Python爱好者,你又重新复习了一遍某些可能已经忘掉的知识,也可能顺便了解了一些新技巧。无论你的水平怎样,我希望这趟遨游Python特殊方法的旅行,真的对你产生了魔法般的效果(实在忍不住不说最后这个双关)。

7.10 【进阶】神奇的元类编程(metaclass)

1. 类是如何产生的

类是如何产生?这个问题也许你会觉得很傻。

实则不然,很多初学者只知道使用继承的表面形式来创建一个类,却不知道其内部真正的创建是由 type 来创建的。

type?这不是判断对象类型的函数吗?

是的,type通常用法就是用来判断对象的类型。但除此之外,他最大的用途是用来动态创建类。当Python扫描到class的语法的时候,就会调用type函数进行类的创建。

2. 如何使用type创建类

首先,type() 需要接收三个参数

- 类的名称,若不指定,也要传入空字符串:

"" - 父类,注意以tuple的形式传入,若没有父类也要传入空tuple:

(),默认继承object - 绑定的方法或属性,注意以dict的形式传入

来看个例子

1 | |

3. 理解什么是元类

什么是类?可能谁都知道,类就是用来创建对象的「模板」。

那什么是元类呢?一句话通俗来说,元类就是创建类的「模板」。

为什么type能用来创建类?因为它本身是一个元类。使用元类创建类,那就合理了。

type是Python在背后用来创建所有类的元类,我们熟知的类的始祖 object 也是由type创建的。更有甚者,连type自己也是由type自己创建的,这就过份了。

1 | |

如果要形象的来理解的话,就看下面这三行话。

- str:用来创建字符串对象的类。

- int:是用来创建整数对象的类。

- type:是用来创建类对象的类。

反过来看

- 一个实例的类型,是类

- 一个类的类型,是元类

- 一个元类的类型,是type

写个简单的小示例来验证下

1 | |

下面再来看一个稍微完整的

1 | |

综上,我们知道了类是元类的实例,所以在创建一个普通类时,其实会走元类的 __new__。

同时,我们又知道在类里实现了 __call__ 就可以让这个类的实例变成可调用。

所以在我们对普通类进行实例化时,实际是对一个元类的实例(也就是普通类)进行直接调用,所以会走进元类的 __call__

在这里可以借助 「单例的实现」举一个例子,你就清楚了

1 | |

验证结果

1 | |

4. 使用元类的意义

正常情况下,我们都不会使用到元类。但是这并不意味着,它不重要。假如某一天,我们需要写一个框架,很有可能就需要你对元类要有进一步的研究。

元类有啥用,用我通俗的理解,元类的作用过程:

- 拦截类的创建

- 拦截下后,进行修改

- 修改完后,返回修改后的类

所以,很明显,为什么要用它呢?不要它会怎样?

使用元类,是要对类进行定制修改。使用元类来动态生成元类的实例,而99%的开发人员是不需要动态修改类的,因为这应该是框架才需要考虑的事。

但是,这样说,你一定不会服气,到底元类用来干什么?其实元类的作用就是创建API,一个最典型的应用是 Django ORM。

5. 元类实战:ORM

使用过Django ORM的人都知道,有了ORM,使得我们操作数据库,变得异常简单。

ORM的一个类(User),就对应数据库中的一张表。id,name,email,password 就是字段。

1 | |

如果我们要插入一条数据,我们只需这样做

1 | |

通常用户层面,只需要懂应用,就像上面这样操作就可以了。

但是今天我并不是来教大家如何使用ORM,我们是用来探究ORM内部究竟是如何实现的。我们也可以自己写一个简易的ORM。

从上面的User类中,我们看到StrField和IntField,从字段意思上看,我们很容易看出这代表两个字段类型。字段名分别是id,username,email,password。

StrField和IntField在这里的用法,叫做属性描述符。

简单来说呢,属性描述符可以实现对属性值的类型,范围等一切做约束,意思就是说变量id只能是int类型,变量name只能是str类型,否则将会抛出异常。

那如何实现这两个属性描述符呢?请看代码。

1 | |

我们看到User类继承自BaseModel,这个BaseModel里,定义了数据库操作的各种方法,譬如我们使用的save函数,也可以放在这里面的。所以我们就可以来写一下这个BaseModel类

1 | |

从BaseModel类中,save函数里面有几个新变量。

- fields: 存放所有的字段属性

- db_table:表名

我们思考一下这个u实例的创建过程:

type -> ModelMetaClass -> BaseModel -> User -> u

这里会有几个问题。

- init的参数是User实例时传入的,所以传入的id是int类型,name是str类型。看起来没啥问题,若是这样,我上面的数据描述符就失效了,不能起约束作用。所以我们希望init接收到的id是IntField类型,name是StrField类型。

- 同时,我们希望这些字段属性,能够自动归类到fields变量中。因为,做为BaseModel,它可不是专门为User类服务的,它还要兼容各种各样的表。不同的表,表里有不同数量,不同属性的字段,这些都要能自动类别并归类整理到一起。这是一个ORM框架最基本的。

- 我们希望对表名有两种选择,一个是User中若指定Meta信息,比如表名,就以此为表名,若未指定就以类名的小写 做为表名。虽然BaseModel可以直接取到User的db_table属性,但是如果在数据库业务逻辑中,加入这段复杂的逻辑,显然是很不优雅的。

上面这几个问题,其实都可以通过元类的__new__函数来完成。

下面就来看看,如何用元类来解决这些问题呢?请看代码。

1 | |

6. _new_ 有什么用?

在没有元类的情况下,每次创建实例,在先进入 __init__ 之前都会先进入 __new__。

1 | |

使用如下

1 | |

在有元类的情况下,每次创建类时,会都先进入 元类的 __new__ 方法,如果你要对类进行定制,可以在这时做一些手脚。

综上,元类的__new__和普通类的不一样:

- 元类的

__new__在创建类时就会进入,它可以获取到上层类的一切属性和方法,包括类名,魔法方法。 - 而普通类的

__new__在实例化时就会进入,它仅能获取到实例化时外界传入的属性。

附录:参考文章

7.11 【进阶】深藏不露的描述符(Descriptor)

在前几节里,有介绍过 property 的用法,property 实现将一系列函数改造成对象属性,并实现参数的访问检查。

很少有人会去深究这里面的原理究竟是什么?实际上对于大部分开发者而言,只要学会应用即可,无需深入探讨。

因此本节内容是 Python 的进阶知识点,若你是新手,请跳过此章节,否则会打击你的学习自信心。

打开天窗说亮话,实际上 property 的内部原理是 描述符 (Descriptor)

本篇都将带你全面的学习描述符,一起来感受 Python 语言的优雅。

1. 为什么要使用描述符?

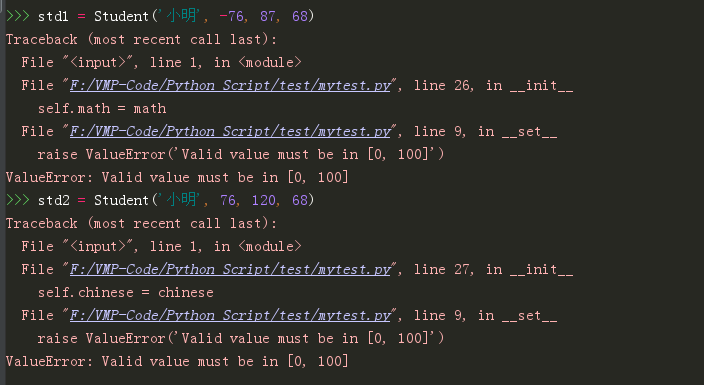

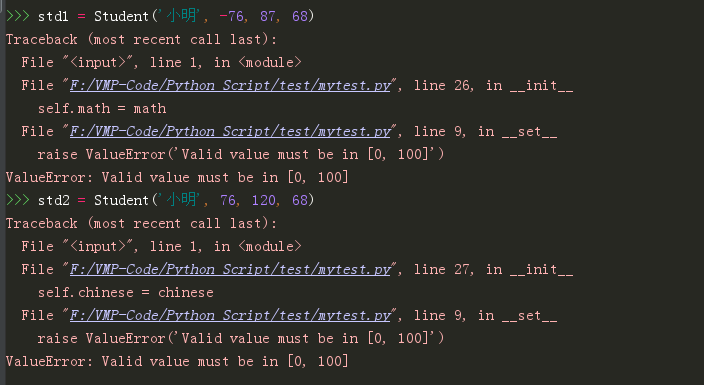

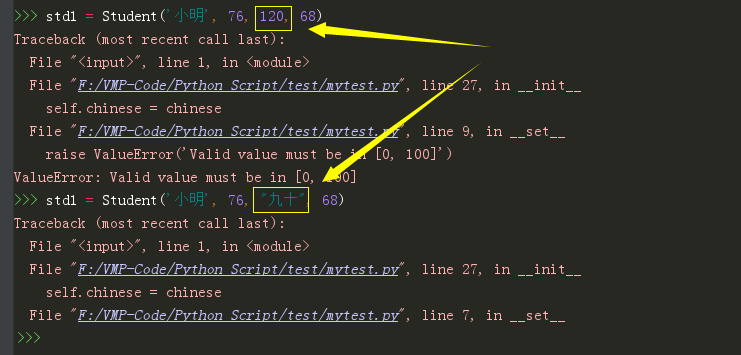

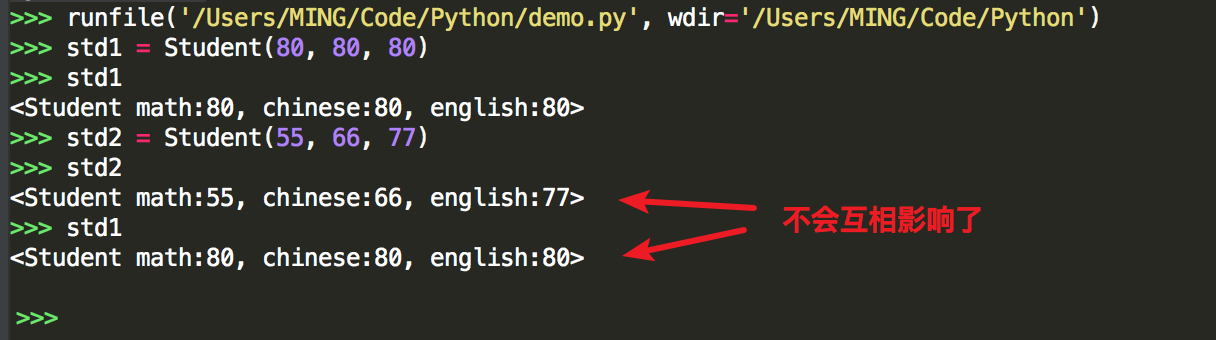

假想你正在给学校写一个成绩管理系统,并没有太多编码经验的你,可能会这样子写。

1 | |

看起来一切都很合理

1 | |

但是程序并不像人那么智能,不会自动根据使用场景判断数据的合法性,如果老师在录入成绩的时候,不小心录入了将成绩录成了负数,或者超过100,程序是无法感知的。

聪明的你,马上在代码中加入了判断逻辑。

1 | |

这下程序稍微有点人工智能了,能够自己明辨是非了。

程序是智能了,但在__init__里有太多的判断逻辑,很影响代码的可读性。巧的是,你刚好学过 Property 特性,可以很好的应用在这里。于是你将代码修改成如下,代码的可读性瞬间提升了不少

1 | |

程序还是一样的人工智能,非常好。

你以为你写的代码,已经非常优秀,无懈可击了。